Forum » Strojna oprema » Nvidiin čip naslednje generacije-G70

Nvidiin čip naslednje generacije-G70

Good Guy ::

ne je pa x80 xl s 512 mb in ni tko izy kr na 1gb tko da kr sanji

http://goo.gl/7ItKpU

Naj računalnik dela za vas^^

Naj računalnik dela za vas^^

Tilen ::

Pa a vam ni jasn. Tut ce dajo 5 giga rama gor nebo nekih opaznih pohitritev. Treba spremenit se arhitekturo.

413120536c6f76656e696a612c20642e642e

Geo ::

no ja js se nebi glih strinju s tabo! a ves kk je vec ko je rama bolj zakomplicirne in bol natancne in vecje slike lahko zacasno nalozi na grafo, uu jz ze vem, da bom kmalu ponosni lastnik X700PRo ali mogoce XT s 512 mb rama!

SHIT!!! I did it again...

Zgodovina sprememb…

- spremenil: Geo ()

Zheegec ::

no ja js se nebi glih strinju s tabo! a ves kk je vec ko je rama bolj zakomplicirne in bol natancne in vecje slike lahko zacasno nalozi na grafo

Eh ne, teksture se nahajajo v RAM in GPU jih potem obdeluje. Ce je GPU presvoh, potem vecje teksture v RAM se bolj obremenijo GPU in ga se bolj dotolcejo. In 6800Ultra je presvoh za 512MB RAM, to je definitivno.

"božja zapoved pravi; <Spoštuj očeta in mater>,

ne govori pa o spoštovanju sodstva."

Janez Janša, 29.04.2014

ne govori pa o spoštovanju sodstva."

Janez Janša, 29.04.2014

RC14 ::

rovtar: 1 gb pa kva je stabo 512 bm že mogoče sam 1 gb pa mi še dolgo časa ne bomo vidl vsaj na grafičnih ne!

Ti slabo bereš. Z mano ni nič narobe, sem lepo napisal, da sem prebral nekje novico da NAJ BI unreal3 potreboval........ in sem tud napisal da koliko je v tem resnice ne vem, tk da le daj očala gor.

Drugač pa boste vidli kako hitro bo 1GB rama na grafikah, sej pravim prehitro gre to naprej, brezveze ,sam da folk kupuje nove grafe in da služijo,verjemte da je marsikatera grafična starejše generacije sposobna gladkega igranja novejših igrc, ampak se izdelovalci ne potrudijo dovolj-torej preslabo optimizirajo,sej zakaj bi, če pa lahka novo kupimo.

Samo poglejte Half Life2 kako lepo deluje na slabših grafah, pa je ena najboljših in najlepših iger sploh. Pa npr Painkiller:battle of hell, pa še dosti je takšnih.

Ne pa npr Medal of Honnor:pacific assault ko klecne dostikrat tudi na 6800 ultra in X800XT. Torej kaj je zdej potrebno vsako leto nova generacija grafičnih, al malo več truda iz strani izdelovalcev.

Drugač pa se strinjam z Dr_M .

Ampak smo nekak prisiljeni v to, saj dati vsako leto 100-150k za grafično ki bo držala lih kako leto je pa res mal huda, bi popolnoma razumel, da pridejo grafe ven z 1GB rama in da bi ble oh in sploh hitre, bi pač te grafe kupovali tisti najbolj zagreti (1600x1200 6AA in 16AF), oz tisti ki jim denar ni problem, ampak ni pa normalno da kupiš grafično npr za 100k (komaj našparaš denar) pa ti po kakšnem letu in pol že vsaka tadruga igra kleca na 1024x768 na high resoluciji z 4AA. To pa je zame žalostno. Poudarjam, da je to moje mnenje.

Lp

Ti slabo bereš. Z mano ni nič narobe, sem lepo napisal, da sem prebral nekje novico da NAJ BI unreal3 potreboval........ in sem tud napisal da koliko je v tem resnice ne vem, tk da le daj očala gor.

Drugač pa boste vidli kako hitro bo 1GB rama na grafikah, sej pravim prehitro gre to naprej, brezveze ,sam da folk kupuje nove grafe in da služijo,verjemte da je marsikatera grafična starejše generacije sposobna gladkega igranja novejših igrc, ampak se izdelovalci ne potrudijo dovolj-torej preslabo optimizirajo,sej zakaj bi, če pa lahka novo kupimo.

Samo poglejte Half Life2 kako lepo deluje na slabših grafah, pa je ena najboljših in najlepših iger sploh. Pa npr Painkiller:battle of hell, pa še dosti je takšnih.

Ne pa npr Medal of Honnor:pacific assault ko klecne dostikrat tudi na 6800 ultra in X800XT. Torej kaj je zdej potrebno vsako leto nova generacija grafičnih, al malo več truda iz strani izdelovalcev.

Drugač pa se strinjam z Dr_M .

Ampak smo nekak prisiljeni v to, saj dati vsako leto 100-150k za grafično ki bo držala lih kako leto je pa res mal huda, bi popolnoma razumel, da pridejo grafe ven z 1GB rama in da bi ble oh in sploh hitre, bi pač te grafe kupovali tisti najbolj zagreti (1600x1200 6AA in 16AF), oz tisti ki jim denar ni problem, ampak ni pa normalno da kupiš grafično npr za 100k (komaj našparaš denar) pa ti po kakšnem letu in pol že vsaka tadruga igra kleca na 1024x768 na high resoluciji z 4AA. To pa je zame žalostno. Poudarjam, da je to moje mnenje.

Lp

kanzyani ::

no ja js se nebi glih strinju s tabo! a ves kk je vec ko je rama bolj

zakomplicirne in bol natancne in vecje slike lahko zacasno nalozi na grafo, uu jz ze vem, da bom kmalu ponosni lastnik X700PRo ali mogoce XT s 512 mb rama!

waaaaaaaaaaaaaaaaaw pole boš pa đek.................a

in kaj ku sm braw to temo ti kaj zagovarjaš Ati smo zato kr boš ti kupu to grafo..... boh ti pomagi...

zakomplicirne in bol natancne in vecje slike lahko zacasno nalozi na grafo, uu jz ze vem, da bom kmalu ponosni lastnik X700PRo ali mogoce XT s 512 mb rama!

waaaaaaaaaaaaaaaaaw pole boš pa đek.................a

in kaj ku sm braw to temo ti kaj zagovarjaš Ati smo zato kr boš ti kupu to grafo..... boh ti pomagi...

Geo ::

Umir se... Ja mal bolj sm na Ati-jevi strani pa kaj poglej kolko jih je tu na nVidijini, glede une greficne pa je tako, jaz cev cast preizkusam graficne in pac bom to si kupil, ker bo en ko ga poznnam si kupil 128mb verzijo, pol bomo lahko naredili primerjevo! Aja ma kdo okvirno ceno za

X700 PRO s pol giga.

X700 PRO s pol giga.

SHIT!!! I did it again...

dxx ::

Nevem kaj se sploh prepirate glede tega?!? Kupiš tisto grafično k se v danem trenutku najbolj izplača, ne glede na to al je ATi al Nvidia

Važn da si zadovoljen s svojim nakupom. Da pa proizvajalca tekmujeta med sabo je pa dobro tako za razvoj kot za cene. Včas se pa zgodi da je določen pogon optimiran za neko igro in bo tam pol ful več slik na tem proizvajalcu GPU-ja, pač sori kup tisto grafično ki dela boljš na teh pogonih če igraš te špile. Pa prosim nehite smetit spet s tem ATi vs Nvidia, al pa si novo temo odprite pa se miljontič skregite, sej itak bo pol kmal zaklenjena tema.

Važn da si zadovoljen s svojim nakupom. Da pa proizvajalca tekmujeta med sabo je pa dobro tako za razvoj kot za cene. Včas se pa zgodi da je določen pogon optimiran za neko igro in bo tam pol ful več slik na tem proizvajalcu GPU-ja, pač sori kup tisto grafično ki dela boljš na teh pogonih če igraš te špile. Pa prosim nehite smetit spet s tem ATi vs Nvidia, al pa si novo temo odprite pa se miljontič skregite, sej itak bo pol kmal zaklenjena tema.

dxx ::

Drugače pa nove novosti od G70 čipa. Izgleda da nvidia spet hoče ponovit napako GPU-ja NV30 (FX5800), kajti kartica naj bi "žrla" 225W . Imela naj bi 2 priključka za štrom na grafični po 75W in še napajanje iz pci-E slota 75W

. Imela naj bi 2 priključka za štrom na grafični po 75W in še napajanje iz pci-E slota 75W . Novico so objavili pri The Inquire-ju

. Novico so objavili pri The Inquire-ju

Tarzan ::

Mam rajš notri najcenejšo grafično kartico, kar se jih da dobit, ki žre 50× manj! Če je to res, bo to polomija za nVidio. Vsi bi morali težiti k zmanjšanju porabe štroma in gretju, dogaja se pa ravno obratno. Intelov procesor s 140W, potem tole čudo z 225W, en kup diskov v RAIDu, še malo navit sistem, malo morje ventilatorčkov, požrešna matična plošča polna kičastih funkcij, ki jih 3/4 folka ne rabi in poraba bo pol kilovata. tri take mašine in ostaneš a: brez prebite pare b: gretje stanovanja več ni problem (pozimi, poleti pa crkneš ti in sistemi zaradi pregrevanja).

To je en navaden D.R.E.K.!

To je en navaden D.R.E.K.!

Grey ::

Res je, da GPUji niso izpopolnjeni tako kot bi morali biti, ampak se pa trudijo po najboljši močeh(to je vsaj videti v prenosnih izvedenkah GPUjev).

Ampak ali niste pomislili na to, da je pri vas prišlo do paradoksalnega mišljenja? Čedalje močnejše in manj požrešne grafične kartice? Kako si lahko predstavljate GPU, ki je 10x močnejši in hitrejši kot 6800Ultra/X850XT in potrebuje samo 75W? Meni se zdi skoraj nemogoče.

Aja še nekaj glede G70...

Nekje sem prebral novico, da jim je uspelo narediti ali tako dobro hlajenje ali pa hladen procesor, ker bo najmočnejša izvedenka imela normalen hladilnik in ne tako gromozanskega kot ga imajo graf. kartice sedaj.

Ampak ali niste pomislili na to, da je pri vas prišlo do paradoksalnega mišljenja? Čedalje močnejše in manj požrešne grafične kartice? Kako si lahko predstavljate GPU, ki je 10x močnejši in hitrejši kot 6800Ultra/X850XT in potrebuje samo 75W? Meni se zdi skoraj nemogoče.

Aja še nekaj glede G70...

Nekje sem prebral novico, da jim je uspelo narediti ali tako dobro hlajenje ali pa hladen procesor, ker bo najmočnejša izvedenka imela normalen hladilnik in ne tako gromozanskega kot ga imajo graf. kartice sedaj.

Zgodovina sprememb…

- spremenilo: Grey ()

DominusSLO ::

Te vaše bitke ati vs. nvidia sploh niso več smešne... kaj ma veze firma ? odvisno kdaj in za koliko denarja kupuješ.. če kupiš en izdelek samo zato, ker piše gor ati ali nvidia si bebec.

dxx ::

Te vaše bitke ati vs. nvidia sploh niso več smešne... kaj ma veze firma ? odvisno kdaj in za koliko denarja kupuješ.. če kupiš en izdelek samo zato, ker piše gor ati ali nvidia si bebec.

Točno tako

ERGY ::

Sepravi eni bi radi ze kupli vse novo, kar se tice teh graficnih sam nvem komu bo se delalo na teh "starih" napajalcih. Ksn 1kW bo kr potrebn

sam nvem komu bo se delalo na teh "starih" napajalcih. Ksn 1kW bo kr potrebn

LP

LP

dxx ::

No, ne bodimo tako črnogledi, nvidia je le zaprosila da naj bo ta moč na razpolago, ni pa jasno koliko od tega bo resnično porabljene, pomoje ne več kot 150W. Sicer pa če gledamo na to da bo imela pošast dual core bi bilo to kar logično, pomislite porabo 2x6800 Ultra , verjetno ni kaj dosti nižja, ampak vseeno preveč. Sicer pa mene bolj zanimajo tiste osnovne izvedenke->srednji ter nižji trg, pomoje bo to eno jedro+ 256MB RAM, 16 pipes in hitrost na ravni 6800GT ali malenkost nižja.

, verjetno ni kaj dosti nižja, ampak vseeno preveč. Sicer pa mene bolj zanimajo tiste osnovne izvedenke->srednji ter nižji trg, pomoje bo to eno jedro+ 256MB RAM, 16 pipes in hitrost na ravni 6800GT ali malenkost nižja.

RC14 ::

Po mojem srednji razred ne bo imel 16 pipic, ampak recimo 12 pa se zna zgodit, pa malo navita,torej nekak tako hitra (po mojem malenkost poasnejša) kot je 6800 GT bi pa znala bit ja, ampak mislim da v srednjem razredu ne bo takšnega preskoka v hitrosti kot je bilo to z 6600GT ( ki je hitrejša od najhitrejše grafične prejšne generacije torej 9800XT).

Drugač pa je tole že too much res, poraba astronomska.pa vsako leto grafo menjat eh...

Men pa skoz foter teži zakaj mam 24 h/dan računalnik pržgan, pa mu rečem :sej ni panike, računalniki itak full malo elektrike pokurijo.

. Ja včasih so res, danes pa je groza. Boljš da ne ve.

. Ja včasih so res, danes pa je groza. Boljš da ne ve.

Lp

Drugač pa je tole že too much res, poraba astronomska.pa vsako leto grafo menjat eh...

Men pa skoz foter teži zakaj mam 24 h/dan računalnik pržgan, pa mu rečem :sej ni panike, računalniki itak full malo elektrike pokurijo.

Lp

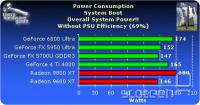

WhiteWolf ::

Eno nevmesno vprasanje:

Koliko stroma zre FX5900 in koliko 6800 Ultra?

Koliko stroma zre FX5900 in koliko 6800 Ultra?

"Maximus Decimus Meridius: What we do in life, echoes in eternity"

dxx ::

Test setup:

CPU Intel Pentium 4 3.2 GHz

FSB 200MHz

Motherboard Gigabyte GA-8IG 1000 PRO (i865)

Memory 2x Kingston PC3500, 1024MB

HDD Seagate Barracude 7200.7 120GB S-ATA (8MB)

DVD Hitachi GD-7000

LAN Netgear FA-312

Power Supply Antec True Control 550W

Drivers & Configuration

Graphics ATI Catalyst v4.3

NVIDIA v60.72

Chipset Intel Inf. Update

OS Windows XP Prof. SP1a

DirectX DirectX 9.0b

Graphic cards used in this article

ATI Radeon 9800XT (Sapphire)

NVIDIA GeForce FX 5950 Ultra (NV)

GeForce 6800 Ultra (NV)

Zgodovina sprememb…

- zavaroval slike: kuglvinkl ()

dxx ::

Pojavila se je novica o domnevnem imenu geforca G70-> GeForce 7800( mene mal spominja na 5800, sam da ne bojo spet zaj....)

Novica-klik

Znane naj bi bile tudi specifikacije 7800 GTX Geforca:

0.11 micron process TSMC

430Mhz core / 1.2GHz 256MB GDDR3 memory

256-bit memory interface

38.4GB/s memory bandwidth

24 pixels per clock

10.32Bps Fill Rate

8 Vertex Pipes

860M vertices/second

400MHz RAMDACs

NVIDIA CineFX 4.0 engine

Intellisample 4.0 technology

64-bit FP texture filtering & blending

NVIDIA SLI Ready (7800 GTX only)

DX 9.0 / SM 3.0 & OpenGL 2.0 supported

G70 comes with 3 models; GTX, GT and Standard

Single Slot solution

Single card requires min. 400W PSU with 12V rating of 26A

SLI configuration requires min. 500W PSU with 12V rating of 34A

Launch : 22nd of June

klik na vr-zone

Novica-klik

Znane naj bi bile tudi specifikacije 7800 GTX Geforca:

0.11 micron process TSMC

430Mhz core / 1.2GHz 256MB GDDR3 memory

256-bit memory interface

38.4GB/s memory bandwidth

24 pixels per clock

10.32Bps Fill Rate

8 Vertex Pipes

860M vertices/second

400MHz RAMDACs

NVIDIA CineFX 4.0 engine

Intellisample 4.0 technology

64-bit FP texture filtering & blending

NVIDIA SLI Ready (7800 GTX only)

DX 9.0 / SM 3.0 & OpenGL 2.0 supported

G70 comes with 3 models; GTX, GT and Standard

Single Slot solution

Single card requires min. 400W PSU with 12V rating of 26A

SLI configuration requires min. 500W PSU with 12V rating of 34A

Launch : 22nd of June

klik na vr-zone

Zgodovina sprememb…

- spremenil: dxx ()

Tarzan ::

Price/performance ni edino kar je pomembno, oziroma če drugače pomisliš, to je edino pomembno. S tem seveda, da pod price vključiš še porabo elektrike, ki jo bo kartica požrla. Jaz osebno bi vsem testom dodal eno dodatno sekcijo in to bi bila performance/watt zadeva, kjer bi za vsako kartico, procesor ali katerokoli komponento izmerili še porabo elektrike ter celokupno število točk iz performansa delili s številom Wattov, ki bi jih zadeva kurila. Pa naj se potem vidi, katera reč je za socialce najboljša. V ZDA se vsako leto ponekod srečujejo z redukcijami, zadeva pa se hitro seli tudi k nam. Malo daljše sušno obdobje bo potrebno, elektrike bo malo po celi evropi, ker je delež hidroenergije enormen, cene bodo naraščale, pojavljale se bodo redukcije,... Zakaj? Ker nobenega ne briga, koliko kaj požre štroma, važno je le, da ima v vasi najmočnejši P4, Geforce xXx,... in podobno seveda tudi na drugih področjih, ne samo računalniškem. Klima se seli v vsako hišo (roko na srce, zadeva postaja resnično nujna - ampak letos na srečo še ne ;) ), število energijsko požrešnih naprav se povečuje,...

Priznam, tudi sam imam 24/7 prižgane mašine doma, radio brenči ves čas, TV je ugasnjen samo takrat, ko ni prižgan ... To je v človekovi naravi, zato je še toliko bolj pomembno, da se že v osnovi nekaj začne delati na temu, da se porabo vsaj malo omeji.

... To je v človekovi naravi, zato je še toliko bolj pomembno, da se že v osnovi nekaj začne delati na temu, da se porabo vsaj malo omeji.

Ko bomo pa imel elektrarne s hladno fuzijo, potem pa se bomo naprej pogovarjal .

.

Priznam, tudi sam imam 24/7 prižgane mašine doma, radio brenči ves čas, TV je ugasnjen samo takrat, ko ni prižgan

Ko bomo pa imel elektrarne s hladno fuzijo, potem pa se bomo naprej pogovarjal

RC14 ::

Po specifikacijah sodeč ta grafa ne bo kaj bistveno hitrejša od 6800 ULTRE, tistih par megahercev in cevovodov in pa 8 vertex shaderjev (proti 6 na ultri) se bo pa poznalo samo pri visokih ločljivostih z 4AA+8AF. Na 1024x768 (veliko ljudi uporablja to resolucijo) bo po mojem zlo majhna razlika.

Sej sem že prej povedal, jaz osebno menim, da ta nova generacija ne bo prinesla takšnega naskoka v hitrosti kot je bilo to iz 5950 Ultre na 6800Ultra in iz 9800XT na X800XT. Tudi pri atiju mislim da ne kaj dosti drugače.

To grafo se bo splačalo kupiti samo tistim ki podirajo rekorde v raznih 3dmarkih, za tiste ki pa jim 3dmarki niso tako pomembni in imajo že sedaj grafe v rangu X800 in 6800 se ne bo splačalo.

Lp

Sej sem že prej povedal, jaz osebno menim, da ta nova generacija ne bo prinesla takšnega naskoka v hitrosti kot je bilo to iz 5950 Ultre na 6800Ultra in iz 9800XT na X800XT. Tudi pri atiju mislim da ne kaj dosti drugače.

To grafo se bo splačalo kupiti samo tistim ki podirajo rekorde v raznih 3dmarkih, za tiste ki pa jim 3dmarki niso tako pomembni in imajo že sedaj grafe v rangu X800 in 6800 se ne bo splačalo.

Lp

RC14 ::

Aja pa še to, 512 MB rama na grafah je zaenkrat samo marketinška poteza, nič kaj hitrosti ne prinese v igrah oz bore malo, verjamem pa, da bo to čez kakšno leto dobrodošlo. Sem gledal primerjavo med X800XL z 256rama in 512 rama in v večini sploh ni bilo razlike, na slabših karticah pa je to sploh bedarija.

Kot npr. na navadne 9600 so dajali 256 rama mislim ... brez komentarja. Torej na teh grafah kot so ranga X700pro in slabše se niti slučajno ne bo poznalo več rama,ker je sama kartica prepočasna.

Lp

Kot npr. na navadne 9600 so dajali 256 rama mislim ... brez komentarja. Torej na teh grafah kot so ranga X700pro in slabše se niti slučajno ne bo poznalo več rama,ker je sama kartica prepočasna.

Lp

Tilen ::

tistih par megahercev in cevovodov

TI sploh ves kaj govoris? Primerjaj razliko (ce jo poznas) med 4 in 8 cevovodi pri 9800SE@PRO pol pa se to moc preracunaj tukaj (vsaj priblizno) in videl bos da to ni kr tako :)

TI sploh ves kaj govoris? Primerjaj razliko (ce jo poznas) med 4 in 8 cevovodi pri 9800SE@PRO pol pa se to moc preracunaj tukaj (vsaj priblizno) in videl bos da to ni kr tako :)

413120536c6f76656e696a612c20642e642e

RC14 ::

ja med 4 in 8 je ogromna razlika, ampak v tem primeru 16 in 24 se pa ne bo tako Ogromno poznalo kot ti govoriš, sej sem reku na osnovnih resolucijah (1024x768) se to ne pozna veliko. Pri tej resoluciji je pa zlo pomembna hitrost gpuja in ramov, kar tukaj vidiš da bo imela ta nova grafa malenkost večjo hitrost od ultre. Na višjih resolucijah pa z vklopljenim AA in AF tam pa bo prišlo do izraza več cevovodov. Itak pa bomo vidli ko pridejo ven, ne vem zakaj bi se sedaj tukaj kregali in pametovali. .

.

Vsak lahko ima svoje mnenje.

Lp

Vsak lahko ima svoje mnenje.

Lp

Tilen ::

Vsak lahko ima svoje mnenje.

Itak da. Jaz te samo zelim usmerit v prava pota razmisljanja.

Itak da. Jaz te samo zelim usmerit v prava pota razmisljanja.

413120536c6f76656e696a612c20642e642e

Zgodovina sprememb…

- spremenil: Tilen ()

Dr_M ::

Vsak lahko ima svoje mnenje.

ja, ampak mnenje vcasih nima nic veze z dejstvi

ja, ampak mnenje vcasih nima nic veze z dejstvi

The reason why most of society hates conservatives and

loves liberals is because conservatives hurt you with

the truth and liberals comfort you with lies.

loves liberals is because conservatives hurt you with

the truth and liberals comfort you with lies.

Zheegec ::

@RC14:

Ja0, hitrost GPUja je odvisna od zmnozka - stevilo cevovodov x MTU (teoreticno vsaj) x frekvenca.

Torej vec cevovodov - vecja hitrost GPU. Ti si pa najbrz mislil "hitrost" kot MHz, tako bi lahko primerjali tudi AMD in Intel, tam je pa vazen zmnozek IPC x frekvenca, torej v vsakem primeru hitrosti GPU/CPU ni odvisna samo od frekvence.

Torej ja - vec cevovodov je hitrejsi GPU, ki rabi tudi hitrejse RAM, pa tale GPU bo imel se visjo frekvenco, tako da bo l33t in sploh zakon, grel se bo pa najbrz kar precej...

Pri tej resoluciji je pa zlo pomembna hitrost gpuja in ramov, kar tukaj vidiš da bo imela ta nova grafa malenkost večjo hitrost od ultre. Na višjih resolucijah pa z vklopljenim AA in AF tam pa bo prišlo do izraza več cevovodov.

Ja0, hitrost GPUja je odvisna od zmnozka - stevilo cevovodov x MTU (teoreticno vsaj) x frekvenca.

Torej vec cevovodov - vecja hitrost GPU. Ti si pa najbrz mislil "hitrost" kot MHz, tako bi lahko primerjali tudi AMD in Intel, tam je pa vazen zmnozek IPC x frekvenca, torej v vsakem primeru hitrosti GPU/CPU ni odvisna samo od frekvence.

Torej ja - vec cevovodov je hitrejsi GPU, ki rabi tudi hitrejse RAM, pa tale GPU bo imel se visjo frekvenco, tako da bo l33t in sploh zakon, grel se bo pa najbrz kar precej...

"božja zapoved pravi; <Spoštuj očeta in mater>,

ne govori pa o spoštovanju sodstva."

Janez Janša, 29.04.2014

ne govori pa o spoštovanju sodstva."

Janez Janša, 29.04.2014

Grey ::

Nekje sem zasledil, da naj bi bil G70 procesor za grafiko v rangu HDTV rendiranja in v 0.09 mikronski tehnologiji. Pojavljajo pa se špekulacije o dodatnih 10MB predpomnilnika za rendiranje take grafike. Podoben procesor naj bi bil v PS3.

Sami ::

7800 točk v 3d marku 2005 z g70 karto

Sej nekaj takega je bilo za pričakovat, moja 6600GT jih dobi 3700.

970A-UD3P,AMD FX 8350,16GB DDR3\1600,RX480 8GB,Tt 750W

Tilen ::

Pozabljate da so ti 3dmark testi precej irelevantni. Nas dejansko zanima performanci v igrah.

Sicer pa, glede na to, kaksno napihovanje je bilo slisat, sem tudi jaz pricakoval vec. Sem pa prav vesel, da nebom rabo se menjat svojga GT-ja.

Sicer pa, glede na to, kaksno napihovanje je bilo slisat, sem tudi jaz pricakoval vec. Sem pa prav vesel, da nebom rabo se menjat svojga GT-ja.

413120536c6f76656e696a612c20642e642e

Zgodovina sprememb…

- spremenil: Tilen ()

Dr_M ::

Sem pa prav vesel, da nebom rabo se menjat svojga GT-ja.

caki, kdo te pa sili menjat?

a ce bi bla zadeva 200% hitrejsa, bi pa mogu zamenat?

caki, kdo te pa sili menjat?

a ce bi bla zadeva 200% hitrejsa, bi pa mogu zamenat?

The reason why most of society hates conservatives and

loves liberals is because conservatives hurt you with

the truth and liberals comfort you with lies.

loves liberals is because conservatives hurt you with

the truth and liberals comfort you with lies.

Tilen ::

Nihce me ne sili. In bi jo zamenjal ja, ce bi bla 200% hitrejsa pa ce bi jo dobo za tako ceno kot to =)

413120536c6f76656e696a612c20642e642e

Zgodovina sprememb…

- spremenil: Tilen ()

dxx ::

Novice iz nvidiinega in ati-jevega tabora.

Čip G70 naj bi bil izdelan v 90nm tehnologiji, podoben naj bi bil čipu v Playstation 3. ATi-jev R520 naj bi bil podoben novemu Xbox grafičnem čipu.

Klik!

Čip G70 naj bi bil izdelan v 90nm tehnologiji, podoben naj bi bil čipu v Playstation 3. ATi-jev R520 naj bi bil podoben novemu Xbox grafičnem čipu.

Klik!

DrAndy ::

7800 točk v 3d marku 2005 z g70 karto

Heh, deluje precej malo glede na to, da bi naj ATI-jev R520 po nekaterih informacijah v 3D Marku 2005 presegel 10.000 točk.

http://www.theinquirer.net/?article=23752

Zagotovo vem le to, da nič ni zagotovo.

jest10 ::

Samo tukaj žal nič ne piše s katero verzijo R520 naj bi bilo toliko pik. 24 ali 32cevovodi?

Tilen ::

Nekateri pozabljate, da tut v generaciji 6xxx in x800xx ATI owna v 3DMarku nakar v igrah(primerani namen) srecamo malo drugacne rezultate.

413120536c6f76656e696a612c20642e642e

Myth ::

A se ne govori tukaj o nVidii?

Sicer pa je že skoraj trivialno da so nekatere igre zasnovane za svojo* grafično.

Sicer pa je že skoraj trivialno da so nekatere igre zasnovane za svojo* grafično.

¤ Space is Mystery. And Myth is on Earth. ¤

DrAndy ::

Tilen, ATI owna tudi na splošno.

X850XT PE je namreč še vedno najhitrejši grafični čip na svetu.

X850XT PE je namreč še vedno najhitrejši grafični čip na svetu.

Zagotovo vem le to, da nič ni zagotovo.

DrAndy ::

Hehe, pa ravno Doom 3 si izbral, za katerega je itak splošno znano, da je pač domena Nvidijinih grafičnih kartic.

Sploh pa en sam test ne more soditi o tem, katera grafična kartica je hitrejša.

Dejanska hitrost se izmeri na podlagi testiranj večih iger in programov, se pravi važen je 'Overall performance' in ne ena sama igra.

Pa kaj bi govoril, grafi povedo vse in v večini testov je zmagovalec X850XT PE:

http://www.digit-life.com/articles2/radeon/r480-tr.html

Sploh pa en sam test ne more soditi o tem, katera grafična kartica je hitrejša.

Dejanska hitrost se izmeri na podlagi testiranj večih iger in programov, se pravi važen je 'Overall performance' in ne ena sama igra.

Pa kaj bi govoril, grafi povedo vse in v večini testov je zmagovalec X850XT PE:

http://www.digit-life.com/articles2/radeon/r480-tr.html

Zagotovo vem le to, da nič ni zagotovo.

Zgodovina sprememb…

- spremenilo: DrAndy ()

tiborrr ::

Pozenimo SpecPerfView, tam vas se moj R9500@9700 @ FireGL Z1 owna, da glava pece.

Don't test the captain's validity or his vulnerability!

Vredno ogleda ...

| Tema | Ogledi | Zadnje sporočilo | |

|---|---|---|---|

| Tema | Ogledi | Zadnje sporočilo | |

| » | ATI izdal Radeon X1900 (strani: 1 2 3 )Oddelek: Novice / Grafične kartice | 15441 (12237) | Senitel |

| » | 7800GTX 512 rama že čez dober teden? (strani: 1 2 3 )Oddelek: Strojna oprema | 9287 (6082) | Good Guy |

| » | R520 in njegovi derivati (strani: 1 2 3 4 … 9 10 11 12 )Oddelek: Strojna oprema | 33010 (20995) | Shark-357 |

| » | NVIDIA GeForce 7800 GTOddelek: Strojna oprema | 2237 (1697) | jest10 |

| » | R520 bo zamudilOddelek: Novice / Grafične kartice | 3956 (2921) | kuglvinkl |