Osmina znanstvenih člankov ima prstne odtise umetne inteligence

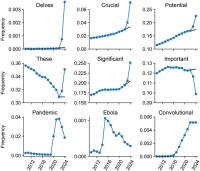

Slo-Tech - Veliki jezikovni modeli, ki so se pojavili v zadnjih letih, so po eni strani močno napredovali in ustvarjajo skorajda človeška besedila, po drugi strani pa so vplivali na besedišče, saj je pogostost uporabe posameznih besed drugačna kot pri naravnih govorcih. To je ena izmed značilnosti, ki jih moremo uporabiti za analizo njihove razširjenosti. Prav to so storili raziskovalci z Univerze Northwestern v Illinoisu in Univerze v Tübingenu v Nemčiji, ko so analizirali 15 milijonov povzetkov (abstract) biomedicinskih znanstvenih člankov iz baze PubMed, ki so nastali v letih 2010-2024. Lani je že 13,5 odstotka vsebin kazalo, da so pri njihovem nastanku avtorju v večji ali manjši meri uporabili velike jezikovne modele (LLM). V nekaterih vedah je ta delež dosegel 40 odstotkov. O raziskavi poročajo v reviji Science Advances.

Članek so ironično naslovili Delving into LLM-assisted writing in biomedical publications through excess vocabulary, saj je prav beseda delve z razmahom LLM-jev...

Članek so ironično naslovili Delving into LLM-assisted writing in biomedical publications through excess vocabulary, saj je prav beseda delve z razmahom LLM-jev...