več strani - Fudzilla poroča, da naj bi poraba nVidiinega grafičnega jedra z oznako GT200, na katerem naj bi temeljila grafična kartica GeForce 9800 GTX, znašala kar 250 W. Do tega zaključka so na omenjeni strani prišli zaradi dejstva, da bo omenjeno jedro izdelano v 65-nanometerski tehnologiji, vsebovalo pa bo preko milijardo tranzistorjev. Hkrati z veliko porabo po tako jedro potrebovalo tudi zmogljiv hladilnik za odvajanje toplote.

Pri tem se poraja vprašanje, zakaj nVidia ne preide na 55-nanometersko tehnologijo, kot je to storil njen konkurent AMD. Odgovor se skriva v zapletenosti prehoda, tako naj bi nVidia ostala na 65-nanometrih in s tem preprečila morebitne težave z novim jedrom ter s tem povezane zamude predstavitev nove grafične kartice. Le ta naj bi luč sveta zagledala v drugi polovici letošnjega leta, takrat pa naj bi tudi AMD predstavil svoj R700. Več o tem si preberite na Hartware.net.

Novice » Grafične kartice » GT200 s porabo 250 W

opeter ::

Obstaja možnost, da bo AMD tokrat v prednosti? Da bodo MAD-jeve kartice pri enaki hitrosti dosti manj porabile od konkurence?

Hrabri mišek (od 2015 nova serija!) -> http://tinyurl.com/na7r54l

18. november 2011 - Umrl je Mark Hall, "oče" Hrabrega miška

RTVSLO: http://tinyurl.com/74r9n7j

18. november 2011 - Umrl je Mark Hall, "oče" Hrabrega miška

RTVSLO: http://tinyurl.com/74r9n7j

Pyr0Beast ::

To je pa kar konkretna poraba, sicer je Die dokaj velik, da to nebi smelo predstavljati problema pri hlajenju, vseeno pa bo, če je to res, čipek pivnal vsaj 100A, če ne še več. Bi rad videl regler za to zverino

Some nanoparticles are more equal than others

Good work: Any notion of sanity and critical thought is off-topic in this place

Good work: Any notion of sanity and critical thought is off-topic in this place

Zgodovina sprememb…

- spremenil: Pyr0Beast ()

mtosev ::

Tehnologija gre napej pa tudi poraba.

Core i9 10900X, ASUS Prime X299 Edition 30, 32GB 4x8 3600Mhz G.skill, CM H500M,

ASUS ROG Strix RTX 2080 Super, Samsung 970 PRO, UltraSharp UP3017, Win 11 Pro,

Enermax Platimax 1700W | moj oče darko 1960-2016, moj labradorec max 2002-2013

ASUS ROG Strix RTX 2080 Super, Samsung 970 PRO, UltraSharp UP3017, Win 11 Pro,

Enermax Platimax 1700W | moj oče darko 1960-2016, moj labradorec max 2002-2013

Zgodovina sprememb…

- spremenil: mtosev ()

molotov ::

Hm ja bo treba kmalu razmišljat o računu za elekriko.

Kašno varčno zarnico kupit, kuhat na plin...

da bo lahko comp delal 24/7

Kašno varčno zarnico kupit, kuhat na plin...

da bo lahko comp delal 24/7

Senitel ::

To je tko kot govorice pred izidom G80, da bo to kartica z serijskim vodnim hlajenjem. Realnost je bila pa taka, da je prvi "full speed" prototip imel vodni blok gor.

dzinks63 ::

molotov ::

Volta: Go Ati... Da se vsaj malo pobere iz rdečih številk

Se strinjam, več konkurence -> majše cene & boljši izdelki -> mi srečni

Ja za 24/7 imam star tih comp, se bolj splača.

Se strinjam, več konkurence -> majše cene & boljši izdelki -> mi srečni

Ja za 24/7 imam star tih comp, se bolj splača.

FireSnake ::

Take kartice jaz nikoli ne bi kupil - ce je vse to res, seveda.

A sem ze velikokrat zasledil, da so partnerji zelenega tabora nezadovoljni, zaradi temperatur.

Zanimivo je to, da na vseh podrocjih prehajajo na manjsi proizvodni proces, poraba pa kar raste ... to je zaradi tega, ker tiscijo do meje.

Rdeci so se zadnje case zelo izkazali, sploh z X2, ki je v Avstriji na voljo ze za 360 eurov.

Bomo videli, kaj e bo iz tega razvilo ... jaz radovedno pricakujem R700 :)

A sem ze velikokrat zasledil, da so partnerji zelenega tabora nezadovoljni, zaradi temperatur.

Zanimivo je to, da na vseh podrocjih prehajajo na manjsi proizvodni proces, poraba pa kar raste ... to je zaradi tega, ker tiscijo do meje.

Rdeci so se zadnje case zelo izkazali, sploh z X2, ki je v Avstriji na voljo ze za 360 eurov.

Bomo videli, kaj e bo iz tega razvilo ... jaz radovedno pricakujem R700 :)

Poglej in se nasmej: vicmaher.si

FireSnake ::

Za hladne zimske dni:

http://www.fudzilla.com/index.php?optio...

Ha ha ha, rdeci tabor se res lahko samo smeji....... zdaj sem pa res zacel navijat za njih!

Pa na 45 nm se naj cim prej spravijo :)

http://www.fudzilla.com/index.php?optio...

Ha ha ha, rdeci tabor se res lahko samo smeji....... zdaj sem pa res zacel navijat za njih!

Pa na 45 nm se naj cim prej spravijo :)

Poglej in se nasmej: vicmaher.si

OChack ::

očitno so 3 al 4 mesce stare novice o špijunjenju nvidie v ATI taboru resnične, sadovi so tukej, nvidiia tud v novi generaciji ne bo znala podpret DX10.1, shame shame....

Int€l inside, IDIOT Outside

Pyr0Beast ::

Jst navijam tako ali drugače

Some nanoparticles are more equal than others

Good work: Any notion of sanity and critical thought is off-topic in this place

Good work: Any notion of sanity and critical thought is off-topic in this place

destroyer2k ::

Ja tudi če je res takšna poraba je lahko pozitivna lastnost v tem in mislim to da bi ta kartica bila izjemno možna proti zdajšni ultri. Samo vseen dvomim da bo tolikšna poraba, ker dozdaj je ATI-NVIDIA v tem segmentu skoz bila enaka. Tudi 8800ultra katera je narejena v (80 ali 90nm nisem čisto siguren) ima samo malo višjo porabo od ati 3870x2 (katera je na 55nm).

FireSnake ::

Zalostno je pa to, da razvijalci v veliki meri ne bodo podprli DX 10.1 le zaradi tega, ker nVidia zaostaja ..... je pa mocna, in to steje.

Ati ima DX 10.1 kartice ze dolgo, iz zelenega tabora se ni novic o podpori ... skorajda sramotno, ampak, tako je, ce imas tako velik trzni delez.

Ati ima DX 10.1 kartice ze dolgo, iz zelenega tabora se ni novic o podpori ... skorajda sramotno, ampak, tako je, ce imas tako velik trzni delez.

Poglej in se nasmej: vicmaher.si

Dr_M ::

Kok ste eni cudni...

ATI je zaostajal 3/4 leta, da je sploh spacal eno skropucalo z DX10 naredil, zdej pa Nvidia 2 mesca ne da inf o 10.1, pa ze cela panika. S casom vse pride. Bo pa tole hitra zadeva, ATI ne pride blizu, pa tudi ce 4 gpuje nalima na eno kartico

250W? bomo vidl, spekulacije niso uredu. tistle fudo gre lohk pa tut za lady pisat.

edit: typo

ATI je zaostajal 3/4 leta, da je sploh spacal eno skropucalo z DX10 naredil, zdej pa Nvidia 2 mesca ne da inf o 10.1, pa ze cela panika. S casom vse pride. Bo pa tole hitra zadeva, ATI ne pride blizu, pa tudi ce 4 gpuje nalima na eno kartico

250W? bomo vidl, spekulacije niso uredu. tistle fudo gre lohk pa tut za lady pisat.

edit: typo

The reason why most of society hates conservatives and

loves liberals is because conservatives hurt you with

the truth and liberals comfort you with lies.

loves liberals is because conservatives hurt you with

the truth and liberals comfort you with lies.

Zgodovina sprememb…

- spremenil: Dr_M ()

M-XXXX ::

Bo pa tole hitra zadeva, ATI ne pride bluzi, pa tudi ce 4 gpuje nalima na eno kartico

Po zdajšnih testih je GX2 okoli 15% počasnejša od X2 (saj je tudi pričakovati)

OChack ::

nvidia trenutno pov leta peha za ATIjem, ne v hitrosti pač pa tehnologija, ko bo nvidia izdala dx10.1 bojo na sitem, isto ste govorl ko ati ni izdav DX10 grafe ampak je pov leta trajal da je radon 2900 vn pršuin več, pač zdej smo na istm, vedt je treba da bo novi 3d mark podpirov dx10.1 in to bo kr velik dodatnih pik za ATI, kjer se bo kazala pomanklivost nvidie ki ne bo enga ali dveh testov mogla poganjat v HW načinu

bdv ma fudo zadne cajte kr velik prov tko da nvidia funi ne s ejokat, sj radon2900 je tud žru več k 200w pa ste jokal, bo pač nvidia enkrat prevzela krono največjega porabnika energije, pa še zebl vas ne bo :>

tole je pa naliman na nvidia grafičnih po tanovm :))

bdv ma fudo zadne cajte kr velik prov tko da nvidia funi ne s ejokat, sj radon2900 je tud žru več k 200w pa ste jokal, bo pač nvidia enkrat prevzela krono največjega porabnika energije, pa še zebl vas ne bo :>

tole je pa naliman na nvidia grafičnih po tanovm :))

Int€l inside, IDIOT Outside

Zgodovina sprememb…

- spremenil: OChack ()

Dr_M ::

Po zdajšnih testih je GX2 okoli 15% počasnejša od X2 (saj je tudi pričakovati)

po zdajsnjih testih?? katerih testih? Nej najprej pride sploh gx2, potem pa bomo teste gledal. sicer pa sploh ni o tem tema in to niti najmn ni pomembno. dual gpu pac ni dobra stvar, pa nej bo cf ali sli.

nvidia trenutno pov leta peha za ATIjem,

clovek, pod katerim kamnom pa ti zivis??

po zdajsnjih testih?? katerih testih? Nej najprej pride sploh gx2, potem pa bomo teste gledal. sicer pa sploh ni o tem tema in to niti najmn ni pomembno. dual gpu pac ni dobra stvar, pa nej bo cf ali sli.

nvidia trenutno pov leta peha za ATIjem,

clovek, pod katerim kamnom pa ti zivis??

The reason why most of society hates conservatives and

loves liberals is because conservatives hurt you with

the truth and liberals comfort you with lies.

loves liberals is because conservatives hurt you with

the truth and liberals comfort you with lies.

Mr.B ::

Lansko leto bil DX10, letos pa DX10.1, in tako dalje

Lol se Hutiji delajo Facpalm USA:

A Navy fighter jet fell overboard Monday when the USS Harry S. Truman

aircraft carrier veered to avoid fire from the Houthis

A Navy fighter jet fell overboard Monday when the USS Harry S. Truman

aircraft carrier veered to avoid fire from the Houthis

OChack ::

poglej dejstva, 55nm tehnologija vs 65, dx 10.2 vs dx10 in podobno, nvidia nima za sirov burek :)

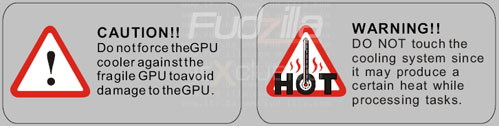

tlee nalepke gor k so so iz grafične 9800GX2 tko da stavr bo lih za jutranjo kavco dobra, tko da ti ne bo treba posebej štedilnika pržigat.

najbolš da kr kvazi vodno glajenje nardiš ki bo ubistvu avtomat za kavo obenm bo pa hladiv grafo :)

tlee nalepke gor k so so iz grafične 9800GX2 tko da stavr bo lih za jutranjo kavco dobra, tko da ti ne bo treba posebej štedilnika pržigat.

najbolš da kr kvazi vodno glajenje nardiš ki bo ubistvu avtomat za kavo obenm bo pa hladiv grafo :)

Int€l inside, IDIOT Outside

Senitel ::

Res nevem kaj taka panika glede DX10.1? Seveda omogoča par stvari, da ni treba developerjem okrog rit v varžet. DX 10.2? LOL... Come on umirite mal konje no...  Me pa res zanima kolk več pik bodo 38x0 karte dobivale v novem 3D Marku.

Me pa res zanima kolk več pik bodo 38x0 karte dobivale v novem 3D Marku.

Ti kaj pomaga, če ti povem da NVIDIA sploh ne bo imela DX 10.1 grafične? Da je to jasno že nekako tako dolgo kot so znane specifikacije DX 10.1?

Ti kaj pomaga, če ti povem da NVIDIA sploh ne bo imela DX 10.1 grafične? Da je to jasno že nekako tako dolgo kot so znane specifikacije DX 10.1?

kotnikd3 ::

Glede 9800gx2.....so NEURADNI testi z 169.12 driverji. Driverji posebej za 9800gx2 bodo stvar izboljšali. se vam ne zdi?

Tist glede DirectX 10.1. Vsaka DX10 grafa bo poganjala špil pisan v DX10.1. Pa tut z aplikacijami neb smelo bit težav, zato radeoni nebodo v "tako veliki" prednosti v 3D Mark Vantage. Vir

OChack. pravš da je ati daleeeeeč tehnološko spredaj pred nVidio. Nvidiji se "takorečeno" jebe za to. Poglej proračun od nVidie pa od ATIja, pa ti bo vse jasno zakaj. če bi hotel, bi naredil.....ker imajo!

EDIT: aja, :P, pa Ageio so kupli! ql a? Misliš da lahko v 2010 pričakujemo grafe in pospeševalnike fizike na eni PCB tiskanini? hm...od nvidie že!

Tist glede DirectX 10.1. Vsaka DX10 grafa bo poganjala špil pisan v DX10.1. Pa tut z aplikacijami neb smelo bit težav, zato radeoni nebodo v "tako veliki" prednosti v 3D Mark Vantage. Vir

OChack. pravš da je ati daleeeeeč tehnološko spredaj pred nVidio. Nvidiji se "takorečeno" jebe za to. Poglej proračun od nVidie pa od ATIja, pa ti bo vse jasno zakaj. če bi hotel, bi naredil.....ker imajo!

EDIT: aja, :P, pa Ageio so kupli! ql a? Misliš da lahko v 2010 pričakujemo grafe in pospeševalnike fizike na eni PCB tiskanini? hm...od nvidie že!

Zgodovina sprememb…

- spremenil: kotnikd3 ()

OChack ::

no ja za X2 bojo tud novi driverji...

hočm sam mal pomirit nvidiote, ki za vsako ceno pravjo kok so grafe dobre, bomo vidl čez 2 mesca, počakmo na izide, trenutno je tehnologija izdelave v prid Atiju

hočm sam mal pomirit nvidiote, ki za vsako ceno pravjo kok so grafe dobre, bomo vidl čez 2 mesca, počakmo na izide, trenutno je tehnologija izdelave v prid Atiju

Int€l inside, IDIOT Outside

sid911 ::

trenutno se vse vrti okol dveh čipov: RV670 in G92. In ker večno ne more biti tako (no, lahko bi bilo, vendar bi nVidia izdala grafično z x-PCB-ji, AMD pa z X GPU-ji ) bomo verjetno v drugi polovici leta videli R700 in tale GT200. Špekulacije so vedno nehvaležna stvar, vendar žal se tiste črnoglede večinoma uresničijo. Fud gor Fud dol, tu pa tam ima kar prav njegova kristalna krogla.

) bomo verjetno v drugi polovici leta videli R700 in tale GT200. Špekulacije so vedno nehvaležna stvar, vendar žal se tiste črnoglede večinoma uresničijo. Fud gor Fud dol, tu pa tam ima kar prav njegova kristalna krogla.

Zame je tista novica na Hartware mnogo bolj zanimiva. Govori namreč o tem da se želi nVidia izogniti komplikacijam ki bi se lako pojavile ob prehodu na 55(ali manj) nm. Zakaj je temu tako pa mislim da vsi vemo: R700. Če so do zdaj lahko nove grafe izdajali ko se jim je sprdnilo in so se na AMD-ja ozirali le toliko, da so dva tedna po tem ko je AMD izdal kako grafo izdali oni boljšo. AMD se je kot vse kaže (in večina nas upa - pa ne ker bi bili fanboyi) pobral in je dirka spet (bolj) odprta (kot je bila).

Zame je tista novica na Hartware mnogo bolj zanimiva. Govori namreč o tem da se želi nVidia izogniti komplikacijam ki bi se lako pojavile ob prehodu na 55(ali manj) nm. Zakaj je temu tako pa mislim da vsi vemo: R700. Če so do zdaj lahko nove grafe izdajali ko se jim je sprdnilo in so se na AMD-ja ozirali le toliko, da so dva tedna po tem ko je AMD izdal kako grafo izdali oni boljšo. AMD se je kot vse kaže (in večina nas upa - pa ne ker bi bili fanboyi) pobral in je dirka spet (bolj) odprta (kot je bila).

1. Asus P8P67 LE | i3 2100 | HD 3850 | 2x4GB | 320 GB + 2 TB

2. FSC Amilo PRO V3515 ( T2060;2 GB;80GB)

2. FSC Amilo PRO V3515 ( T2060;2 GB;80GB)

M-XXXX ::

o zdajsnjih testih?? katerih testih? Nej najprej pride sploh gx2, potem pa bomo teste gledal. sicer pa sploh ni o tem tema in to niti najmn ni pomembno. dual gpu pac ni dobra stvar, pa nej bo cf ali sli.

Tukaj

Temu testu pa tudi kar pošteno verjamem,... Zakaj? Zaradi ker je CF bolši (ima bolši izkoristek) od SLI, tako da je to zame kar primeren rezultat...

kotnikd3 ::

AMD se je kot vse kaže (in večina nas upa - pa ne ker bi bili fanboyi) pobral in je dirka spet (bolj) odprta (kot je bila).

Kje je pa cilj?

Kje je pa cilj?

Senitel ::

Tale novica je tako točna kot druga novica na tejle strani (BTW: Moj komentar v tistile temi se nanaša na GT200  , ok kot kaže ne bo 8900 j**** ga

, ok kot kaže ne bo 8900 j**** ga  ).

).

Kaj se tako paničari glede procesa izdelave tudi nevem... Tudi G80 je 90nm, R600 pa 80nm...

Kaj se tako paničari glede procesa izdelave tudi nevem... Tudi G80 je 90nm, R600 pa 80nm...

R33D3M33R ::

V vsej tej svetovni gonji proti prekomerni rabi energije bi se pa ja lahko malo potrudili in pričeli delati energijsko manj požrešne zadeve.

Ali je podpora DX 10.1 ali ni tako ali tako nima veze. A so grafične že sploh tako močne, da poganjajo zadeve tekoče? Ja, v raznih ultra duper sli/crossfire variacijah, ki jih pa ima kakih par hardcore zanesenjakov.

Ali je podpora DX 10.1 ali ni tako ali tako nima veze. A so grafične že sploh tako močne, da poganjajo zadeve tekoče? Ja, v raznih ultra duper sli/crossfire variacijah, ki jih pa ima kakih par hardcore zanesenjakov.

Moja domača stran: http://andrej.mernik.eu

Na spletu že od junija 2002 ;)

:(){ :|:& };:

Na spletu že od junija 2002 ;)

:(){ :|:& };:

MrDelight ::

Haha, Nvidioti pa že spet jokajo.

Senitela še nekako razumem, Dr_M, za tebe bi bil pa že skrajni čas, da si odstraniš te svoje zelene plašnice in se spustiš

na realna tla. Ker kakor hitro se kje omeni kaj negativnega v zvezi z omiljeno Nvidio, si takoj prvi v vrsti za jok in stok.

Jaz samo pravim, hvala bogu, da se ATI prebuja in da zopet dokaže svojo veljavo. Za nas potrošnike edino dobro.

Senitela še nekako razumem, Dr_M, za tebe bi bil pa že skrajni čas, da si odstraniš te svoje zelene plašnice in se spustiš

na realna tla. Ker kakor hitro se kje omeni kaj negativnega v zvezi z omiljeno Nvidio, si takoj prvi v vrsti za jok in stok.

Jaz samo pravim, hvala bogu, da se ATI prebuja in da zopet dokaže svojo veljavo. Za nas potrošnike edino dobro.

OChack ::

se strinjam leto 2007 je bilo nvidiino, leto 2008 bo Atijevo......in cikl se ponavla

Int€l inside, IDIOT Outside

kotnikd3 ::

Jaz samo pravim, hvala bogu, da se ATI prebuja...

A to, da bo GT200 energetsko požrešen, zate dejansko pomeni, da se ATI prebuja in da bo leto 2008 "njegovo"??

Tega celo ti ne moreš vedeti, počakmo pol leta...

A to, da bo GT200 energetsko požrešen, zate dejansko pomeni, da se ATI prebuja in da bo leto 2008 "njegovo"??

Tega celo ti ne moreš vedeti, počakmo pol leta...

Dr_M ::

MrDelight:jebiga, pac ne prenesem, da folk neki mlati prazno slamo. 3/4 ljudi tuki neve kaj sploh govori. vkljucno s tabo.

The reason why most of society hates conservatives and

loves liberals is because conservatives hurt you with

the truth and liberals comfort you with lies.

loves liberals is because conservatives hurt you with

the truth and liberals comfort you with lies.

RejZoR ::

TDP pomeni maximalna poraba v najbolj ekstremnih pogojih. Itaq da čip ne žre tolk ko pišeš post tle na Slo-Tech. Kdor pa hoče gnat špil pri 2560x1600 s 16xFSAA in 16xAF z 500fps mu je pa res zadnja briga kolk štroma porabi zadeva. Če si je lahko omislil tak hardware bo tud zmogel plačat račun za štrom.

Kot bi se lastniki več deset metrskih jaht tresli okoli porabe goriva... Like they care...

Kot bi se lastniki več deset metrskih jaht tresli okoli porabe goriva... Like they care...

Angry Sheep Blog @ www.rejzor.com

Volta ::

A to, da bo GT200 energetsko požrešen, zate dejansko pomeni, da se ATI prebuja in da bo leto 2008 "njegovo"??

Tega celo ti ne moreš vedeti, počakmo pol leta...

Nekateri upamo, da bo temu tako. Če želiš ti kupovati zmogljive grafične za velike denarce, kar izvoli. Mislim, da je večini tukaj na Slo-techu v dobrobit, da se Ati pobere in tekma spet zares začne... Saj vemo, kakšne bodo koristi tega V primeru, da bo Ati&Amd propadel, bog nam pomagaj... Nimamo vsi bančnih trezorjev doma, da bi kupili zmogljive mašine...

V primeru, da bo Ati&Amd propadel, bog nam pomagaj... Nimamo vsi bančnih trezorjev doma, da bi kupili zmogljive mašine...

Tega celo ti ne moreš vedeti, počakmo pol leta...

Nekateri upamo, da bo temu tako. Če želiš ti kupovati zmogljive grafične za velike denarce, kar izvoli. Mislim, da je večini tukaj na Slo-techu v dobrobit, da se Ati pobere in tekma spet zares začne... Saj vemo, kakšne bodo koristi tega

Swen F@tt ::

Razlika v DX 10 in 10.1 je, da je v DX10.1 dodan nabor ukazov, ki izboljša performans, izboljšan API, glavna izboljšava je boljši dostop do shader-resorsov, nova funkcionalnost v floating pointu pa blendingu, izboljšana zmožnost filtiriranja senčenja znotraj APIja, zlo pomembna stvar za nas pa je, da DX10.1 dovoljuje bolši performans na večljedrnih sistemih.

Razmeroma zmanjšane zahteve po APIju ob uporabi reflekcij, refrakcije ter cube mappinga, kar prinaša boljšo zmogljivost. To je kar se tiče zmogljivosti.

Kar se tiče pa izboljšave v kvaliteti, je pa tu:

-32bitna natančnost operacij z placajočo vejico aka floating-point. (DX10 in 9 imata 16 bitno).

-Izboljšan HDR rendering

-nasplošno izboljšana natančnost skozi rendering-cevovode

-popoln nadzor aplikacije nad glajenjem robov -> Antialiasing (aplikacija sama nadzira kaj je najbolje, multisampling, supersampling, kombinacija enega ali drugega, za določene odtenke in scene v danem momentu.) Čuje se zelo fino, kako se bo pa obneslo v praksi bomo pa videli.

Na koncu je pa tukaj še WDDM 2.1 (dx10 wddm 2.0) -> (Windows Driver Display Model), veliko izboljšanih malenkosti o katerih se mi ne da pisat.

Da zaključim, DX 10.1 ne bo neka izboljšava, zaradi katere bi se nekateri odločali za nakup trenutnih ATijevih kartulj, če si že lastijo karto z DX10. Pač performančno bo izboljšan, vizualno pa tudi, vendar za navadnega smrtnika ne prinaša nekih razlik. Boljši in lepši bo AA, to vsekakor (upajmo no). Nasplošno pa DX10.1 v glavnem odpravlja težave ki so pestile DX10 in 9, predvsem programerje, ki jim bo dokaj lažje delat z novim DXom.

Razmeroma zmanjšane zahteve po APIju ob uporabi reflekcij, refrakcije ter cube mappinga, kar prinaša boljšo zmogljivost. To je kar se tiče zmogljivosti.

Kar se tiče pa izboljšave v kvaliteti, je pa tu:

-32bitna natančnost operacij z placajočo vejico aka floating-point. (DX10 in 9 imata 16 bitno).

-Izboljšan HDR rendering

-nasplošno izboljšana natančnost skozi rendering-cevovode

-popoln nadzor aplikacije nad glajenjem robov -> Antialiasing (aplikacija sama nadzira kaj je najbolje, multisampling, supersampling, kombinacija enega ali drugega, za določene odtenke in scene v danem momentu.) Čuje se zelo fino, kako se bo pa obneslo v praksi bomo pa videli.

Na koncu je pa tukaj še WDDM 2.1 (dx10 wddm 2.0) -> (Windows Driver Display Model), veliko izboljšanih malenkosti o katerih se mi ne da pisat.

Da zaključim, DX 10.1 ne bo neka izboljšava, zaradi katere bi se nekateri odločali za nakup trenutnih ATijevih kartulj, če si že lastijo karto z DX10. Pač performančno bo izboljšan, vizualno pa tudi, vendar za navadnega smrtnika ne prinaša nekih razlik. Boljši in lepši bo AA, to vsekakor (upajmo no). Nasplošno pa DX10.1 v glavnem odpravlja težave ki so pestile DX10 in 9, predvsem programerje, ki jim bo dokaj lažje delat z novim DXom.

WingMan ^^

Senitel ::

Glede filtriranja in blendinga: DX10 zahteva FP16 floating point in blending, DX 10.1 zahteva FP32 floating point filtering in blending. G80 podpira FP32 floating point filtering in blending (vključno v kombinaciji s HDR) in lahko to šiba v DX10.

Glede reflekcij, refrakcij in cube mappinga: Ja, DX 10.1 podpira cube arraye, kar precej uporabna zadeva. Ampak že v štartu renderiranje environment mappa v cube map v enem passu ni win situacija za GPU.

Glede antialiasinga: Da DX 10.1 zahteva vsaj 4x multisampling. Aplikacija ima nadzor katere vrednosti se zapišejo v multisample buffer. Ni pa to kontrola nad multisamplingom in supersamplingom, če hočeš supersampling boš dejansko moral ročno naredit pixel shader x krat. Še ena dobra lastnost tu je, da lahko MSAA depth buffer uporabljaš direkt iz shaderja (DX10 moraš naredit render globine v običen color buffer).

Glede WDDM 2.1: To pomaga glede poganjanja večih rendering device-ov hkrati. Boljši scheduling ko je v Visti itak vsak window drug device praktično. To ni glih za multi threading (prihaja pa tudi na tem področju nekaj).

Glede reflekcij, refrakcij in cube mappinga: Ja, DX 10.1 podpira cube arraye, kar precej uporabna zadeva. Ampak že v štartu renderiranje environment mappa v cube map v enem passu ni win situacija za GPU.

Glede antialiasinga: Da DX 10.1 zahteva vsaj 4x multisampling. Aplikacija ima nadzor katere vrednosti se zapišejo v multisample buffer. Ni pa to kontrola nad multisamplingom in supersamplingom, če hočeš supersampling boš dejansko moral ročno naredit pixel shader x krat. Še ena dobra lastnost tu je, da lahko MSAA depth buffer uporabljaš direkt iz shaderja (DX10 moraš naredit render globine v običen color buffer).

Glede WDDM 2.1: To pomaga glede poganjanja večih rendering device-ov hkrati. Boljši scheduling ko je v Visti itak vsak window drug device praktično. To ni glih za multi threading (prihaja pa tudi na tem področju nekaj).

Swen F@tt ::

Ok, to sem hotel, da Senitel napiše. Heh

Če je še kakšna uporabna/zanimiva stvar v DX10 vs 10.1, se kar razpiši. Če že ne drugega, zaradi splošne razgledanosti.

Če je še kakšna uporabna/zanimiva stvar v DX10 vs 10.1, se kar razpiši. Če že ne drugega, zaradi splošne razgledanosti.

WingMan ^^

Zgodovina sprememb…

- spremenil: Swen F@tt ()

FireSnake ::

Hehe, kake ima nVidia zadnje case:

http://www.theinquirer.net/gb/inquirer/...

potem pa tole malo umiri situacijo:

http://www.fudzilla.com/index.php?optio...

Koliko je resnice presodite sami, je pa vekakor zanimivo branje

http://www.theinquirer.net/gb/inquirer/...

potem pa tole malo umiri situacijo:

http://www.fudzilla.com/index.php?optio...

Koliko je resnice presodite sami, je pa vekakor zanimivo branje

Poglej in se nasmej: vicmaher.si

Mr.B ::

Na THG-ju je tudi dober članek.

Razmisli PhysX, ki se nahaja tudi v Xboxu ?, kaj misliš koga bo MS izbral za naslednjo konzolo.

Razmisli PhysX, ki se nahaja tudi v Xboxu ?, kaj misliš koga bo MS izbral za naslednjo konzolo.

Lol se Hutiji delajo Facpalm USA:

A Navy fighter jet fell overboard Monday when the USS Harry S. Truman

aircraft carrier veered to avoid fire from the Houthis

A Navy fighter jet fell overboard Monday when the USS Harry S. Truman

aircraft carrier veered to avoid fire from the Houthis

Dr_M ::

Ce je tole, kar pise na theinquirerju res, potem je pri nvidii res nekdo mal bolan, ker nvidia se pa res nima cesa bat.

The reason why most of society hates conservatives and

loves liberals is because conservatives hurt you with

the truth and liberals comfort you with lies.

loves liberals is because conservatives hurt you with

the truth and liberals comfort you with lies.

kotnikd3 ::

Swen F@tt

ČE te prav zastopim, labutaš da bodo Radeoni 3870 oz. radeoni s podporo DX 10.1 imeli v 3DMARK Vantage boljši score v dx 10.1 testih kot pa njihova konkurenca (magari še en radeon brez podpore dx10.1) brez dx 10.1 ?? še kšnih 14 dni do izida 3dmarka...

ČE te prav zastopim, labutaš da bodo Radeoni 3870 oz. radeoni s podporo DX 10.1 imeli v 3DMARK Vantage boljši score v dx 10.1 testih kot pa njihova konkurenca (magari še en radeon brez podpore dx10.1) brez dx 10.1 ?? še kšnih 14 dni do izida 3dmarka...

OChack ::

načeloma nj bi blo tko, sicer so radoni kr dobri v 3d marku naprma drugim aplikacijam, tko da ja dx10.1 bi znov kšno piko doprnest, to ne pomen da bo isto v igrah.....bomo vidl

Int€l inside, IDIOT Outside

Senitel ::

Jah glede DX 10.1 je nekak to to.

-Uporabno je da imaš lahko več kot 16 outputov iz vertex shaderja. Deferred rendererji (ala Unreal Engine 3) bodo veseli tega, ker bodo lahko v enem passu več lučk obdelal. Po drugi strani pa je ta pass itak sam en full screen quad, ko je praktično vseen če je eden ali pa če jih je 10.

-No pa ker lahko renderiraš v 4 različne render targete lahko v DX 10.1 za vsak posamezen render target določiš svoj blending (v DX10 in DX9 bodo vsi imeli istega).

-Uporabne so fore z MSAA (za Call of Juarez bi bli veliko bolj pametni, če bi tist svoj veleumni softwareski AA prišparal za DX 10.1), SM 4.1 ti da kontrolo nad tem točno kater vzorec pobereš iz teksture (render target tekstura, ki je bila enkrat prej renderirana, recimo environment mapa), ampak moraš v bistvu resolve (torej iz recimo štirih vrednosti dobit eno) in filtriranje (!!!) naredit sam. Ko sem že omenjal Call of Juarez: špil itak renderira v FP16 HDR buffer, potem pa naredi tone mapping pass v navaden 32 biten buffer, ki bo viden na zaslonu. V tem passu bi ta funkcionalnost prišla do izraza (ampak so jo naredili brez DX 10.1). Res močna zadeva ob tem pa je, da lahko ugotoviš položaj posameznega sampla (če se kdo spomni unih pikčastih slik z D3D FSAA Viewerjem).

-Uporabna je tudi "gather" funkcija, oziroma "fetch four" kot je zadevo poimenoval ATI (in jo imajo že od Radeona X800 se mi zdi). Vrne 4 najbližje sosedne vrednosti iz teksture nefiltrirane. Če hočeš naredit svoje programske teste za shadow mapping (hmm zakaj za boga pa tu ne podpirajo označevanja vzorcev ), namesto PCF filtriranja.

), namesto PCF filtriranja.

-Potem so tu še cube arrayi ampak tuki je situacija itak bolj funky. Cube map je že tko al tko v DX10 array (6 tekstur), cube map array je pa pol array arrayev . Če je array velik 12 tekstur to pač pomeni da sta not 2 cube mapa. Kakor kol, stvar je bolj semantični popravek.

. Če je array velik 12 tekstur to pač pomeni da sta not 2 cube mapa. Kakor kol, stvar je bolj semantični popravek.

Če kdo kaj zastop tole...

To bi delal probleme implementirat v G8x/G9x driverjih, fetch four 100% vem da čip ne podpira in torej odpade, cube map array pa grejo tud na G8x/G9x čez.

Nič od tega ne nek hud performance win. DX 8.1 je bil hujši kot tole (PS 1.4)... Bo pa hudič tole testirat v 3D Mark Vantage, če bo kaj od DX 10.1 dejansko not. DX 10.1 bo Vista SP1 only, testirat 3870 pred SP1 in po SP1 in vso razliko pripisat DX 10.1 ne gre... Edino če se bo dalo izbrat DX 10 ali DX 10.1. Ker potencialno tudi če bo 3870 hitrejši od recimo 8800 GT/GTS to niti približno ne pomeni, da bo to zaradi DX 10.1.

-Uporabno je da imaš lahko več kot 16 outputov iz vertex shaderja. Deferred rendererji (ala Unreal Engine 3) bodo veseli tega, ker bodo lahko v enem passu več lučk obdelal. Po drugi strani pa je ta pass itak sam en full screen quad, ko je praktično vseen če je eden ali pa če jih je 10.

-No pa ker lahko renderiraš v 4 različne render targete lahko v DX 10.1 za vsak posamezen render target določiš svoj blending (v DX10 in DX9 bodo vsi imeli istega).

-Uporabne so fore z MSAA (za Call of Juarez bi bli veliko bolj pametni, če bi tist svoj veleumni softwareski AA prišparal za DX 10.1), SM 4.1 ti da kontrolo nad tem točno kater vzorec pobereš iz teksture (render target tekstura, ki je bila enkrat prej renderirana, recimo environment mapa), ampak moraš v bistvu resolve (torej iz recimo štirih vrednosti dobit eno) in filtriranje (!!!) naredit sam. Ko sem že omenjal Call of Juarez: špil itak renderira v FP16 HDR buffer, potem pa naredi tone mapping pass v navaden 32 biten buffer, ki bo viden na zaslonu. V tem passu bi ta funkcionalnost prišla do izraza (ampak so jo naredili brez DX 10.1). Res močna zadeva ob tem pa je, da lahko ugotoviš položaj posameznega sampla (če se kdo spomni unih pikčastih slik z D3D FSAA Viewerjem).

-Uporabna je tudi "gather" funkcija, oziroma "fetch four" kot je zadevo poimenoval ATI (in jo imajo že od Radeona X800 se mi zdi). Vrne 4 najbližje sosedne vrednosti iz teksture nefiltrirane. Če hočeš naredit svoje programske teste za shadow mapping (hmm zakaj za boga pa tu ne podpirajo označevanja vzorcev

-Potem so tu še cube arrayi ampak tuki je situacija itak bolj funky. Cube map je že tko al tko v DX10 array (6 tekstur), cube map array je pa pol array arrayev

Če kdo kaj zastop tole...

To bi delal probleme implementirat v G8x/G9x driverjih, fetch four 100% vem da čip ne podpira in torej odpade, cube map array pa grejo tud na G8x/G9x čez.

Nič od tega ne nek hud performance win. DX 8.1 je bil hujši kot tole (PS 1.4)... Bo pa hudič tole testirat v 3D Mark Vantage, če bo kaj od DX 10.1 dejansko not. DX 10.1 bo Vista SP1 only, testirat 3870 pred SP1 in po SP1 in vso razliko pripisat DX 10.1 ne gre... Edino če se bo dalo izbrat DX 10 ali DX 10.1. Ker potencialno tudi če bo 3870 hitrejši od recimo 8800 GT/GTS to niti približno ne pomeni, da bo to zaradi DX 10.1.

Loki ::

off, kako je pa z natancnostjo (single bit precision ali kako se ze rece), se bo to kdaj spremenilo? se sploh rabi vecjo natancnost v igricah? v mislih imam predvsem kaksen cuda.

I left my wallet in El Segundo

Senitel ::

DX 10.1 ima še vedno največ FP32 (single precision, full precision float), DX 10 zahteva vsaj FP16 (half precision) za blending, filtering in MSAA (ampak ves za igre uporaben hardware zmore FP32). CUDA pozna FP64 oziroma double (double precision floating point) vendar se na trenutnih GPU-jih to premapira v navaden FP32 float, ko bodo pa GPU-ji z podporo zunaj se bo pa uporabil FP64. Za igre pa trenutno ni nobene potrebe in je pomojem še lep čas ne bo.

Vredno ogleda ...

| Tema | Ogledi | Zadnje sporočilo | |

|---|---|---|---|

| Tema | Ogledi | Zadnje sporočilo | |

| » | Vse več informacij o prihajajočih grafičnih karticahOddelek: Novice / Grafične kartice | 5217 (3387) | Senitel |

| » | GeForce 7300 GT za AGPOddelek: Novice / Grafične kartice | 4841 (4136) | AtaStrumf |

| » | Prihajata G80 in R600Oddelek: Novice / Grafične kartice | 4924 (3936) | Vesoljc |

| » | Bodočim 64 bitnim Athlonom se obeta podpora SSE3Oddelek: Novice / Procesorji | 2828 (2828) | Mr.B |

| » | AMD dobavlja več procesorjevOddelek: Novice / Procesorji | 2780 (2780) | mchaber |