vir: Ars Technica

Globoko učenje - se pravi, raba globokih nevronskih mrež - si je v zadnjem desetletju praktično podredilo področje strojne inteligence. Dalo nam je algoritme, ki premagujejo ljudi v strateških igrah, prepoznavajo obraze, diagnosticirajo bolezni in vozijo avtomobile ... dokler cesta ni preveč luknjasta, mokra in polna nepredvidljivih kolesarjev. Prav ta zadnji primer pa že kaže, kako omejen je pravzaprav ta pristop, saj se avtonomna vozila kar ne morejo izviti iz primeža eksperimentalnih faz, pa čeprav naj bi bila že nekaj časa tik za ovinkom. Kdor redno bere našo stran, zna našteti šibke točke globokega učenja na izust: občutljivost na šum; ogromne baze podatkov, potrebne za učenje; pristranskost in pa katastrofično pozabljanje, se pravi neučinkovitost izven zelo ozko zastavljenih okvirjev.

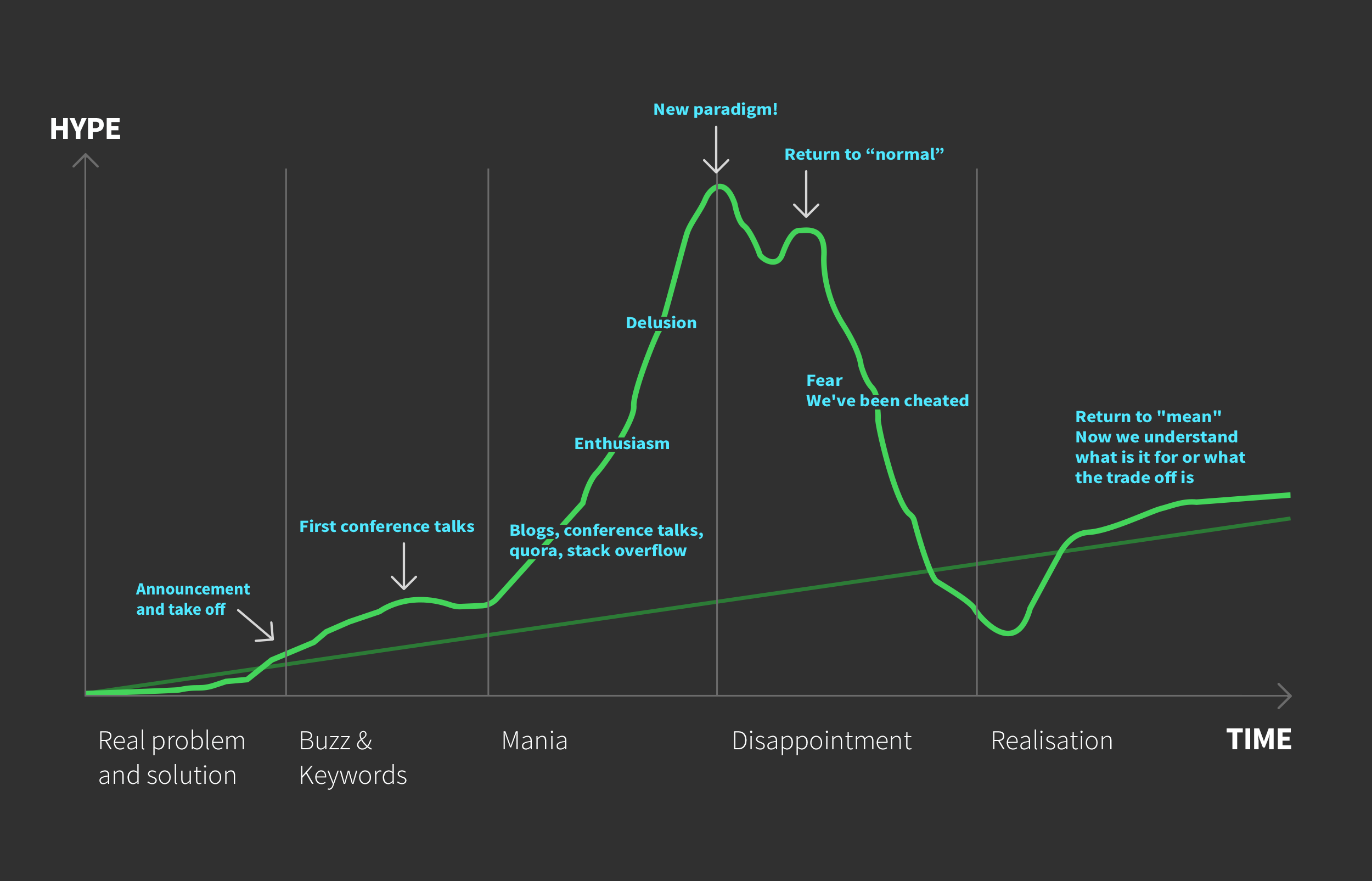

Tega se vse bolj odprto začenja zavedati tudi industrija. Pred tedni je Facebookov šef AI oddelka Jerome Pesenti opozoril, da bo umetna inteligenca kmalu "trčila ob zid", njegovo mnenje pa očitno že deli tudi znaten delež strokovnjakov, če gre soditi po vzdušju na letni konferenci NeurIPS (Conference on Neural Information Processing Systems), ki se je pretekli vikend zaključila v Vancouvru (plačljiv vir, alternativa). Konferenca, ki se je letos odvila že 33-tič in privabila prek 13.000 strokovnjakov z vsega sveta, je bila v zadnjih letih razvpita predvsem po razuzdanih zabavah, s katerimi so firme novačile kader, in visokoletečih najavah. Letos je bilo precej drugače (omejen vir).

Osrednje predavanje je pripadlo Yoshui Bengiu, enemu od "treh mušketirjev umetne inteligence", ki so si letos razdelili Turingovo nagrado za dosežke v računalništvu. Opozoril je, da je potencial klasičnih globokih mrež v navezi z utrjevanim učenjem bržkone docela izrabljen, zato za nadaljnji napredek potrebujemo nove pristope, ki jih je nekaj tudi predstavil. Ti principi, kot je meta-učenje, v glavnem gradijo na potiskanju strojne pameti v vedno nove nepredvidljive situacije, kar jo prisili, da je bolj vsestranska in se ne zgolj uči odzivov, temveč kratkomalo "uči učiti". Tako želijo strokovnjaki dobiti algoritme, ki bodo znali posnemati človeka v njegovi sposobnosti, da se uči na zelo majhnih vzorcih podatkov, ker zna posploševati naučene principe od drugod, česar AI trenutno ne zna. To je ponazoril denimo nedavni natečaj MineRL Competition, ki je tekmovalcem zadal napraviti algoritem, ki bo znal v Minecraftu rudariti diamante. Kljub temu, da je to nekaj, česar se osnovnošolec nauči v nekaj minutah, pa so bili vsi algoritmi na tekmovanju neuspešni.

Kljub treznejšim besedam na letošnji konferenci pa je optimizem še vedno v zraku in malokdo dvomi, da bomo tegobe premagali. Kakor pravi ravnokar izdani Stanfordov pregled področja, AI Index 2019, je strojno učenje še vedno v skokovitem porastu in otipljivi napredek nezmanjšan: medtem ko so algoritmi za prepoznavo podob še predlani za učenje neke omejene naloge potrebovali več ur, letos primerljiv zadatek opravijo v nekaj minutah. Vprašanje torej ni, ali bo AI napredovala, temveč, na kakšen način in kdo bo imel od tega največjo korist.