Forum » Strojna oprema » Nvidia-Kepler (6xx series)

Nvidia-Kepler (6xx series)

Temo vidijo: vsi

ncc2000 ::

se pravi ker mi je CUDA prioriteta, najbolje še malo počakat, da cene še padejo, potem pa kaj takega ubost, ali?

Senitel ::

Sej pravim, ne vem 100% kakšne so zadeve pri GTX 680 pod OpenCL? Pravijo, da nekatere zadeve delujejo v rangu pričakovanega price/performance, nekatere pa da bistveno počasneje. Bom pač raje počakal, da nekdo potestira v programih, ki jih uporabljam. Se pa vseeno lahko čudim, da je 680-ka res samo grafična za igre in ima GPGPU del pač zelo oskubljen (1/24), česar od nVidie v tej meri pač nisem vajen.

Še enkrat: double precision sploh ni problem! GTX 580 je tudi 1/8. GTX 680 1/24 glede na single precision, ampak je 2x hitrejši. Double je torej 1/2 tistega kar je na GTX 580. Če hočeš double precision, potem je itak edina logična izbira direkt Tesla board.

Saj ni po defaultu slabša. Samo treba je vedet upgrade česa tole dejansko je (torej GF114 in ne GF110). Če jo primerjaš z GF110 ima praktično identičen bandwidth, manjši L2 cache (512KB vs. 768KB), drastično večji float performance in manjši nekoliko manjš performance v double precision. Radeon 7970 naprimer ima tudi 768KB L2 cache.

Compute aplikacije so lahko omejene na miljon različnih načinov. In razen v primerih, ko je dejansko problem compute, GTX 680 pač nima šans.

FlyingBee ::

zgleda kar obetavno - nvidia 6xx roadmap - http://videocardz.com/31551/geforce-600...

670 zamenjava za 570 in 670ti zamenjava za 580

torej za mene bo najbolj pričakovana še vedno 660ti ali celo 660, ki bo verjetno dovolj dobra za monitorje do vključno 1900*1200

670 zamenjava za 570 in 670ti zamenjava za 580

torej za mene bo najbolj pričakovana še vedno 660ti ali celo 660, ki bo verjetno dovolj dobra za monitorje do vključno 1900*1200

P200 MMX, 32mb ram, 2gb HDD, s3 virge 2mb, 14" CRT 640x480

New Sphincter Kvartet:

Roko Spestner, Namaž Zlevčar, Daje Heading, Maraje Spetan

New Sphincter Kvartet:

Roko Spestner, Namaž Zlevčar, Daje Heading, Maraje Spetan

fireX88 ::

verjetno misli performance..

ANY OF MY POSTS ARE RESEARCHED AND/OR COMPILED BITS OF INFORMATION*

AND YOU SHOULD FOLLOW THEM AT YOUR OWN RISK.

*EXCLUDING SARCASTIC AND OR SUBJECTIVE RESPONSES!

AND YOU SHOULD FOLLOW THEM AT YOUR OWN RISK.

*EXCLUDING SARCASTIC AND OR SUBJECTIVE RESPONSES!

FlyingBee ::

radeon 9800xt če ne druge :)

ja, recimo leta 2003 je izšel 9700 pro in je bil takrat kot recimo 5870 leta 2009 popolnoma brez konkurence tako v moči kot tudi v podpori novega direct x-a

vmes je tudi nvidia imela svetle trenutke in prav tako ga ima zdaj s Keplerjem in ravno to je kar je pri GPU-jih naj bolj zanimivo

P200 MMX, 32mb ram, 2gb HDD, s3 virge 2mb, 14" CRT 640x480

New Sphincter Kvartet:

Roko Spestner, Namaž Zlevčar, Daje Heading, Maraje Spetan

New Sphincter Kvartet:

Roko Spestner, Namaž Zlevčar, Daje Heading, Maraje Spetan

Dr_M ::

HD5800 serija je dejansko bila brez konkurence celih 6 mesecev, R300 pa jo je imel, ampak je bila ta zaradi Nvidiinega spora z MS bolj klavrna. Seveda se je situacija relativno hitro popravila do neke mere, ampak skoda je ze bila storjena.

TechBeats ::

Sej pravim, ne vem 100% kakšne so zadeve pri GTX 680 pod OpenCL? Pravijo, da nekatere zadeve delujejo v rangu pričakovanega price/performance, nekatere pa da bistveno počasneje. Bom pač raje počakal, da nekdo potestira v programih, ki jih uporabljam. Se pa vseeno lahko čudim, da je 680-ka res samo grafična za igre in ima GPGPU del pač zelo oskubljen (1/24), česar od nVidie v tej meri pač nisem vajen.

single precision float 1.98tflops

link

vs moja 570gtx

default

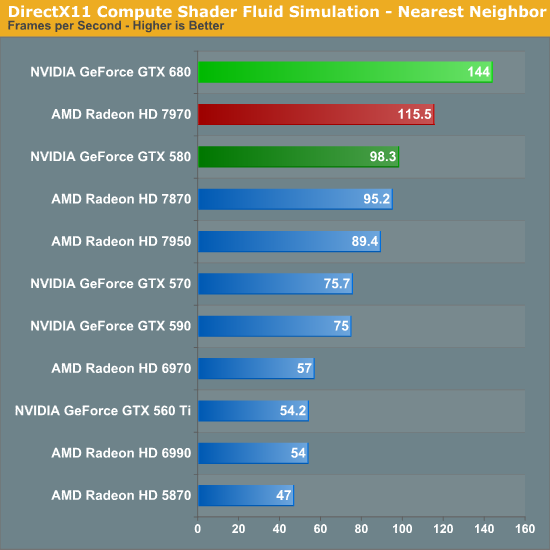

Tako pač je, dela ok pri špilkah, se kosa z 7970 in benda pri drect compute, no mogče se najde kakšna izjema.

Aja pa AMD je kr cenejša, svašta..

7970 za 441€

http://geizhals.at/eu/?cat=gra16_512&xf...

680gtx za 465€

http://geizhals.at/eu/?cat=gra16_512&xf...

Še 400€ je preveč za to kar ponujata.. lol

AciD TriP

Zgodovina sprememb…

- spremenilo: TechBeats ()

Senitel ::

S cenami je itak tako, da bodo padale. Verjetno tolk časa dokler si bo AMD lahko privoščil.

Glede konkretnega CUDA testa: Tukaj je source. Relavantna funkcija/kernel je CZCudaCalcKernelFloat. Naredi 16 * 16 * 256 množenj s seštevanji (1 op) = 65535 operacij. Kar je za enkrat vse lepo in prav. Potem pogledaš pa funkcijo CZCudaCalcDevicePerformanceTest, ki kliče ta kernel. Število blokov je 1 (spremenljivka blocksNum in kolikor sem gledal preostali del kode je heavyMode vedno 0 torej false), število threadov na blok je pa "maxThreadsPerBlock" (spremenljivka threadsNum).

Na GTX 580 je maxThreadsPerBlock = 1024, torej se na 512 SP-jih poganja 1024 threadov, kar je komaj komaj dovolj (ampak je ravno dovolj), da je GPU polno zaposlen (če bi kernel kaj šaril po pomnilniku to ne bi bilo več niti približno dovolj).

Na GTX 680 je maxThreadsPerBlock še vedno 1024. Sedaj mi pa prosim razloži kako lahko 1024 threadov teče na 1536 SP-jih in polno zaposli GPU? Performance je 2/3 maksimuma enostavno zato, ker je test napisan tako, da izkoristi samo 2/3 GPU-ja!

Si zadovoljen z analizo? Ali boš raje takoj zdele letel v štacuno po 680, jaz bom pa zvečer zamenjal en byte v izvorni kodi CUDA-z (tule, vrstica 169 bom zamenjal 0 z 1) in zbuildal nov executable. Če ostane performance tam kot je ti plačam račun, če gre na 3T flopse pa jaz odnesem 680 domov. Deal?

Glede konkretnega CUDA testa: Tukaj je source. Relavantna funkcija/kernel je CZCudaCalcKernelFloat. Naredi 16 * 16 * 256 množenj s seštevanji (1 op) = 65535 operacij. Kar je za enkrat vse lepo in prav. Potem pogledaš pa funkcijo CZCudaCalcDevicePerformanceTest, ki kliče ta kernel. Število blokov je 1 (spremenljivka blocksNum in kolikor sem gledal preostali del kode je heavyMode vedno 0 torej false), število threadov na blok je pa "maxThreadsPerBlock" (spremenljivka threadsNum).

Na GTX 580 je maxThreadsPerBlock = 1024, torej se na 512 SP-jih poganja 1024 threadov, kar je komaj komaj dovolj (ampak je ravno dovolj), da je GPU polno zaposlen (če bi kernel kaj šaril po pomnilniku to ne bi bilo več niti približno dovolj).

Na GTX 680 je maxThreadsPerBlock še vedno 1024. Sedaj mi pa prosim razloži kako lahko 1024 threadov teče na 1536 SP-jih in polno zaposli GPU? Performance je 2/3 maksimuma enostavno zato, ker je test napisan tako, da izkoristi samo 2/3 GPU-ja!

Si zadovoljen z analizo? Ali boš raje takoj zdele letel v štacuno po 680, jaz bom pa zvečer zamenjal en byte v izvorni kodi CUDA-z (tule, vrstica 169 bom zamenjal 0 z 1) in zbuildal nov executable. Če ostane performance tam kot je ti plačam račun, če gre na 3T flopse pa jaz odnesem 680 domov. Deal?

filip007 ::

OpenCL je odprt standart, Cuda pa zahteva komercijalna orodja se mi zdi. Saj je še WebCL v pripravi bo verjetno naredil pravo malo revolucijo, če bi združili vse te grafične na svetu bi lahko še vesoljce poklicali.

Zero games, zero talk.

Isotropic ::

vs express je zastonj. pa kaj ma veze, ce je odprt standard? (ajd, razen sorazmerno siroke podpore - arm ipd, sam je cuda pac hitrejsa)

x45 ::

Sej pravim, ne vem 100% kakšne so zadeve pri GTX 680 pod OpenCL? Pravijo, da nekatere zadeve delujejo v rangu pričakovanega price/performance, nekatere pa da bistveno počasneje. Bom pač raje počakal, da nekdo potestira v programih, ki jih uporabljam. Se pa vseeno lahko čudim, da je 680-ka res samo grafična za igre in ima GPGPU del pač zelo oskubljen (1/24), česar od nVidie v tej meri pač nisem vajen.

single precision float 1.98tflops

link

vs moja 570gtx

default

Tako pač je, dela ok pri špilkah, se kosa z 7970 in benda pri drect compute, no mogče se najde kakšna izjema.

Aja pa AMD je kr cenejša, svašta..

7970 za 441€

http://geizhals.at/eu/?cat=gra16_512&xf...

680gtx za 465€

http://geizhals.at/eu/?cat=gra16_512&xf...

Še 400€ je preveč za to kar ponujata.. lol

potem je 7970 dost boljši nakup, ker ima za resno delo krepko boljši score.

Senitel ::

OpenCL je odprt standart, Cuda pa zahteva komercijalna orodja se mi zdi. Saj je še WebCL v pripravi bo verjetno naredil pravo malo revolucijo, če bi združili vse te grafične na svetu bi lahko še vesoljce poklicali.

Mah kakšna komercialna orodja. CUDA lahko uporabljaš kjer ti paše, vse je zastonj. Edini problem zaprtosti je, da nad specifikacijami drži NVIDIA popolno kontrolo. Za OpenCL se pa en kup firm vsede skup in podebatirajo kaj bo šlo v standard. Ampak ker spet NVIDIA vse skup goni naprej gre tudi OpenCL nekak v isto smer.

(ajd, razen sorazmerno siroke podpore - arm ipd, sam je cuda pac hitrejsa)

CUDA ni kar "by default" hitrejša. Če boš imel isto kodo v OpenCL in v CUDA bo hitrost ista. Glede hitrosti je razlika edino v tem, da CUDA dopušča določene dodatne haklce, ki jih NV hardware podpira. Recimo selektivna konfiguracija shared memory/cache na Fermi/Kepler. Kar pa se vedno pozablja pri teh debatah je pa to, da je CUDA cel stack. OpenCL je del tega stacka. Isto je DirectCompute del tega stacka. In C for CUDA, kar ima večina ljudi v mislih, ko reče CUDA. In ta C for CUDA ima že pošteno obsežne podporne knjižnice: CUBLAS, FFT-ji, codeci,...

filip007 ::

Kar je odprto bodo podprli vsi tudi Intel. OpenCL je hitrejši na Radeonu, zato ker ga nVidia hoče malo postrani gledat. Radeon Bullet fizika je bila uporabljena v filmu 2012. http://bulletphysics.org/wordpress/?p=1...

Zero games, zero talk.

Senitel ::

Kar je odprto bodo podprli vsi tudi Intel. OpenCL je hitrejši na Radeonu, zato ker ga nVidia hoče malo postrani gledat. Radeon Bullet fizika je bila uporabljena v filmu 2012. http://bulletphysics.org/wordpress/?p=1...

Se lahko malo skuliraš preden še kakšno neumnost zineš.

-Kaj za vraga ima Bullet Physics z Radeon-om? Ja, nekaj stvari je pospešenih čez OpenCL in lahko tečejo na Radeon hardwaresko. Isto kot lahko tečejo na GeForce hardwaresko. Ali pa na Intelovih CPU-jih softwaresko čez njihov optimiziran OpenCL layer. Kaj ti pomaga, če je film uporabljal ta engine, če ga nobena konkretna AAA igra za PC ne uporablja?

-OpenCL je hitrejši na Radeonu? To je tako kot, če rečeš, da je DirectX hitrejši na Radeon-u. Odvisno kaj za vraga koda dela, se ti ne zdi? Ali hočeš povedat, da bo 1+1 GeForce seštel bistveno hitreje v CUDA kot OpenCL?

Lardi ::

Zelo napredno teoretično razmišljanje. V praksi pa bo še vsaj par let produkcija AAA naslovov potekala vzporedno za PC, XBoX360 in PS3. MMORPG-ji so namenjeni tudi tistim s prenosniki, da lahko s prijatelji igrajo z različnih lokacij.

PC igralcem bodo morda prilimali obliže z boljšimi teksturami, boljše svetlobne učinke in glajenje robov.

Ne bi rekel, da bodo igre snovali ločeno (višji stroški produkcije). Zatorej je neposredna povezava med GPGPU zmogljivostmi in namenskim nakupom za igričarstvo statistično šibka.

PC igralcem bodo morda prilimali obliže z boljšimi teksturami, boljše svetlobne učinke in glajenje robov.

Ne bi rekel, da bodo igre snovali ločeno (višji stroški produkcije). Zatorej je neposredna povezava med GPGPU zmogljivostmi in namenskim nakupom za igričarstvo statistično šibka.

TechBeats ::

S cenami je itak tako, da bodo padale. Verjetno tolk časa dokler si bo AMD lahko privoščil.

Glede konkretnega CUDA testa: Tukaj je source. Relavantna funkcija/kernel je CZCudaCalcKernelFloat. Naredi 16 * 16 * 256 množenj s seštevanji (1 op) = 65535 operacij. Kar je za enkrat vse lepo in prav. Potem pogledaš pa funkcijo CZCudaCalcDevicePerformanceTest, ki kliče ta kernel. Število blokov je 1 (spremenljivka blocksNum in kolikor sem gledal preostali del kode je heavyMode vedno 0 torej false), število threadov na blok je pa "maxThreadsPerBlock" (spremenljivka threadsNum).

Na GTX 580 je maxThreadsPerBlock = 1024, torej se na 512 SP-jih poganja 1024 threadov, kar je komaj komaj dovolj (ampak je ravno dovolj), da je GPU polno zaposlen (če bi kernel kaj šaril po pomnilniku to ne bi bilo več niti približno dovolj).

Na GTX 680 je maxThreadsPerBlock še vedno 1024. Sedaj mi pa prosim razloži kako lahko 1024 threadov teče na 1536 SP-jih in polno zaposli GPU? Performance je 2/3 maksimuma enostavno zato, ker je test napisan tako, da izkoristi samo 2/3 GPU-ja!

Si zadovoljen z analizo? Ali boš raje takoj zdele letel v štacuno po 680, jaz bom pa zvečer zamenjal en byte v izvorni kodi CUDA-z (tule, vrstica 169 bom zamenjal 0 z 1) in zbuildal nov executable. Če ostane performance tam kot je ti plačam račun, če gre na 3T flopse pa jaz odnesem 680 domov. Deal?

Jaz sem samo omenil SP tflops, in se nism osredotočil na to, pač pa na celoto.. in pri ostalih testih DP flops, 24, 32bit je še zmeraj slabša in tako tudi kaže pri vseh ostalig testih, luxmark, openCL in razni direct compute ipd. Tako da tisti extra bit kjer kao ne zaposli celotne grafe nima veze.

Sploh pa, ker ima samo 8? CU namesto 16 kot 580gtx.

AciD TriP

FlyingBee ::

kupil grafično kartico pri funtech, s kodo sem jo dobil za 530, kar se mi zdi dober deal.

gledano samo na ceno, niti ne http://www.dinokomp.si/index.php/cPath/...

je pa verjetno pri Dinokompu več za čakat

P200 MMX, 32mb ram, 2gb HDD, s3 virge 2mb, 14" CRT 640x480

New Sphincter Kvartet:

Roko Spestner, Namaž Zlevčar, Daje Heading, Maraje Spetan

New Sphincter Kvartet:

Roko Spestner, Namaž Zlevčar, Daje Heading, Maraje Spetan

Isotropic ::

Jaz sem samo omenil SP tflops, in se nism osredotočil na to, pač pa na celoto.. in pri ostalih testih DP flops, 24, 32bit je še zmeraj slabša in tako tudi kaže pri vseh ostalig testih, luxmark, openCL in razni direct compute ipd. Tako da tisti extra bit kjer kao ne zaposli celotne grafe nima veze.

Sploh pa, ker ima samo 8? CU namesto 16 kot 580gtx.

meh, saj je 1/2 hitrosti 580 cist dost imo. ce pa rabis vec oz. ne mores cakat, pa kupi teslo...

TechBeats ::

Jaz sem samo omenil SP tflops, in se nism osredotočil na to, pač pa na celoto.. in pri ostalih testih DP flops, 24, 32bit je še zmeraj slabša in tako tudi kaže pri vseh ostalig testih, luxmark, openCL in razni direct compute ipd. Tako da tisti extra bit kjer kao ne zaposli celotne grafe nima veze.

Sploh pa, ker ima samo 8? CU namesto 16 kot 580gtx.

meh, saj je 1/2 hitrosti 580 cist dost imo. ce pa rabis vec oz. ne mores cakat, pa kupi teslo...

Če že res hočem direct compute raje kupim 7970 kot pa teslo... Oz Tapravo high-end NV GK110 oz še boljš ostanem na tej 570gtx.

AciD TriP

PrimozR ::

Zelo napredno teoretično razmišljanje. V praksi pa bo še vsaj par let produkcija AAA naslovov potekala vzporedno za PC, XBoX360 in PS3. MMORPG-ji so namenjeni tudi tistim s prenosniki, da lahko s prijatelji igrajo z različnih lokacij.

PC igralcem bodo morda prilimali obliže z boljšimi teksturami, boljše svetlobne učinke in glajenje robov.

Ne bi rekel, da bodo igre snovali ločeno (višji stroški produkcije). Zatorej je neposredna povezava med GPGPU zmogljivostmi in namenskim nakupom za igričarstvo statistično šibka.

PC igralci imajo, če ne drugega, višje FPS (če le-ti niso omejeni, takisto FOV, kar je en totalen fail s konzol :D) in višje resolucije. Dandanes se vedno več 'lepih' oz. zahtevnih iger na konzolah poganja na 720p in se na 1080p nato upscale-a. Na PC-jih je 1920 x 1080 nativno nekaj običajnega, vedno več pa bo verjetno večjih resolucij, ali 2560 pik širine al pa multi-monitor setupov. Pa prehod na 4k bo verjetno bistveno bolj mehak (torej se bo začelo uporabljati te resolucije pri enem pa po enem uporabniku, namesto s popolnoma novo generacijo konzol, ki bodo sledile naslednji, prihajajoči).

FlyingBee ::

zakaj ne Dinokomp

P200 MMX, 32mb ram, 2gb HDD, s3 virge 2mb, 14" CRT 640x480

New Sphincter Kvartet:

Roko Spestner, Namaž Zlevčar, Daje Heading, Maraje Spetan

New Sphincter Kvartet:

Roko Spestner, Namaž Zlevčar, Daje Heading, Maraje Spetan

Lardi ::

PC igralci imajo, če ne drugega, višje FPS (če le-ti niso omejeni, takisto FOV, kar je en totalen fail s konzol :D) in višje resolucije. Dandanes se vedno več 'lepih' oz. zahtevnih iger na konzolah poganja na 720p in se na 1080p nato upscale-a. Na PC-jih je 1920 x 1080 nativno nekaj običajnega, vedno več pa bo verjetno večjih resolucij, ali 2560 pik širine al pa multi-monitor setupov. Pa prehod na 4k bo verjetno bistveno bolj mehak (torej se bo začelo uporabljati te resolucije pri enem pa po enem uporabniku, namesto s popolnoma novo generacijo konzol, ki bodo sledile naslednji, prihajajoči).

Ena poglavitnih prednosti PC-jev pred igralnimi konzolami, če kdo mene vpraša, prištejemo lahko še teselacijo.

Igro vzamemo kot dinamični sistem, katerega splošna zanimivost je odvisna od računskih kapacitet. Pridemo do tri in štirijedernih procesorjev ter 1GB porabe sistemskega pomnilnika.

Projekti, pri katerih bi igra vpregla 6-8 jeder, 4+ GB pomnilnika in polno GPGPU zaposlila dodatno grafično kartico, so finančno nezanimivi. Ciljna populacija hardcore gamerjev je že pripravljena nanje tam od izzida Windows 7.

Zatorej so očitki na okrnjenost GTX 680 skrajno priložnostni. Konceptualno stvar ni nazadovala in če se načrtovalni pri nVidii odločijo pohitriti GPGPU zmogljivosti, ko bo to merodajno tudi za igričarje, lahko IMO to pri naslednjih generacijah storijo brez večjih naporov.

Senitel ::

Jaz sem samo omenil SP tflops, in se nism osredotočil na to, pač pa na celoto.. in pri ostalih testih DP flops, 24, 32bit je še zmeraj slabša in tako tudi kaže pri vseh ostalig testih, luxmark, openCL in razni direct compute ipd. Tako da tisti extra bit kjer kao ne zaposli celotne grafe nima veze.

A bi lahko že nehal fantazirat s tem double precision, ker sem že 100x povedal, da ni problem... Radeon 7970 ima 947200M flops v double precision, GTX 580 ima 196608M flops. Sedaj mi pa prosim najdi eno GPGPU aplikacijo, kjer 7970 poseka 580 za 4,8x. Nikjer ne pride niti blizu temu.

80% vseh consumer GPGPU aplikacij je omejenih s strani propustnosti pomnilnika (super computer aplikacije so druga zgodba). Nobena consumer aplikacija ne uporablja double precision v GPGPU kodi. Redke uporabljajo integerje.

Če je 680 kar splošno drek za compute, zakaj potem tule:

Rukne 7970?

Kar ti noče in noče bit jasno in imam že občutek, da se pogovarjam s steno, je to, da moraš bit hudo previden, če hočeš označevat neko grafično za slabšo od druge. Ok to je internet in se vsak digen lahko dela, da je Einstain, ampak to ne pomeni, da ima prav.

Računske zmožnosti GPU-jev so s prehodom generacije zrasle precej bolj kot pomnilniška propustnost.

GeForce 8800 GTX je imel 294400M flopsov, 7970 jih ima 3788800M. 13x več.

Ima pa 8800 GTX 86,4GB/s bandwidtha, 7970 pa 264GB/s. Kar je samo 3x več. To je lep del problema, ki zadane tako 7970, kot 680 in vse prihajajoče grafične kartice.

To je na žalost tako kot bi se med 7970 in GTX 580 odločal na podlagi rezultata v Quake 3.

Sploh pa, ker ima samo 8? CU namesto 16 kot 580gtx.

In lahko poganja 8 različnih compute kernelov sočasno nameso 16. Pa kaj pol?

Jst ::

Ne-programerjem je takšne bolj tehnične stvari, kot je GPGPU, tako težko razlagati, da je prav smešno, čeprav imajo tudi takšni sogovorniki svoj point. Jaz recimo verjamem Senitelu in mi je logično kar govori. Drugi se pa lahko samo opirajo samo na trenutno izdane benchmarke, ki so pa vsi po svoje zavajujoči.

Islam is not about "I'm right, you're wrong," but "I'm right, you're dead!"

-Wole Soyinka, Literature Nobelist

|-|-|-|-|Proton decay is a tax on existence.|-|-|-|-|

-Wole Soyinka, Literature Nobelist

|-|-|-|-|Proton decay is a tax on existence.|-|-|-|-|

Dami ::

Ne vem zakaj se kregate. Jaz (in verjetno 99% ostalih) rabmo sam vedet kaj je trenutno bolš za igre, gtx680 al 7970. Za ostale stvari se pa kregajte pol k pride gt110 ven

Don't worry about me. The bleeding is just the begining of a healing process.

FlyingBee ::

eh potem pa je stvar zaključena, torej odvisno katere igre

P200 MMX, 32mb ram, 2gb HDD, s3 virge 2mb, 14" CRT 640x480

New Sphincter Kvartet:

Roko Spestner, Namaž Zlevčar, Daje Heading, Maraje Spetan

New Sphincter Kvartet:

Roko Spestner, Namaž Zlevčar, Daje Heading, Maraje Spetan

AngelOfDeath ::

@Senitel

Kdaj pridejo druge verzije 6xx serije ven ?

Da vem kdaj bodo cene padle :)

Kdaj pridejo druge verzije 6xx serije ven ?

Da vem kdaj bodo cene padle :)

edit: Slovnica

s51as ::

Kaj pa vpliva na glasnost teg grafičnih kartic?

A so tele nove, glede na to da porabijo manj el. moči. zaradi tega tudi tišje?

Ali morajo biti tudi temperature jeder nižje in se morajo zato ventilatorji bolj vrtet?

In če so o kakšni razliki govorimo?

Po testih so 560 ti nekje okoli 40dB idle in malo več na load. Kar je že kar tiho. Bi potem od 660 ti lahko pričakovali 35dB?

Pri kateri kartici bi se lahko začelo pasivno hlajenje?

A so tele nove, glede na to da porabijo manj el. moči. zaradi tega tudi tišje?

Ali morajo biti tudi temperature jeder nižje in se morajo zato ventilatorji bolj vrtet?

In če so o kakšni razliki govorimo?

Po testih so 560 ti nekje okoli 40dB idle in malo več na load. Kar je že kar tiho. Bi potem od 660 ti lahko pričakovali 35dB?

Pri kateri kartici bi se lahko začelo pasivno hlajenje?

It's just me myself and I

TechBeats ::

Jaz sem samo omenil SP tflops, in se nism osredotočil na to, pač pa na celoto.. in pri ostalih testih DP flops, 24, 32bit je še zmeraj slabša in tako tudi kaže pri vseh ostalig testih, luxmark, openCL in razni direct compute ipd. Tako da tisti extra bit kjer kao ne zaposli celotne grafe nima veze.

A bi lahko že nehal fantazirat s tem double precision, ker sem že 100x povedal, da ni problem... Radeon 7970 ima 947200M flops v double precision, GTX 580 ima 196608M flops. Sedaj mi pa prosim najdi eno GPGPU aplikacijo, kjer 7970 poseka 580 za 4,8x. Nikjer ne pride niti blizu temu.

80% vseh consumer GPGPU aplikacij je omejenih s strani propustnosti pomnilnika (super computer aplikacije so druga zgodba). Nobena consumer aplikacija ne uporablja double precision v GPGPU kodi. Redke uporabljajo integerje.

Če je 680 kar splošno drek za compute, zakaj potem tule:

Rukne 7970?

Kar ti noče in noče bit jasno in imam že občutek, da se pogovarjam s steno, je to, da moraš bit hudo previden, če hočeš označevat neko grafično za slabšo od druge. Ok to je internet in se vsak digen lahko dela, da je Einstain, ampak to ne pomeni, da ima prav.

Računske zmožnosti GPU-jev so s prehodom generacije zrasle precej bolj kot pomnilniška propustnost.

GeForce 8800 GTX je imel 294400M flopsov, 7970 jih ima 3788800M. 13x več.

Ima pa 8800 GTX 86,4GB/s bandwidtha, 7970 pa 264GB/s. Kar je samo 3x več. To je lep del problema, ki zadane tako 7970, kot 680 in vse prihajajoče grafične kartice.

To je na žalost tako kot bi se med 7970 in GTX 580 odločal na podlagi rezultata v Quake 3.

Sploh pa, ker ima samo 8? CU namesto 16 kot 580gtx.

In lahko poganja 8 različnih compute kernelov sočasno nameso 16. Pa kaj pol?

Ne se zjokat no.

lol In to je edni test kjer je 680gtx hitrjša, vau. Tako da ti kar veselo zagovarjaj ta mid-range z bogim direct compute..

AciD TriP

Pesimist ::

ma ste tečni ko drek z tem. Mene pa samo zanima kdaj pride kera za reveže. Tam do max 270€ nekje, pa da nerabi dvojno napajanje.

Zgodovina sprememb…

- spremenilo: Pesimist ()

PrimozR ::

A nvidiina? Al 28 nm? Ker pod drugo točko je 7850 seriji precej padla cena, za okrog 300 € se pa dobi tudi 7870. nVidiina konkurenca naj bi pa izšla nekje aprila/marca.

Pesimist ::

NE bom kr rabo Nvidio. Nisem doben fanboy, rabim pa nazalost njene optimizacije, drugace bi ze mel 7870 ja.

fireX88 ::

to ste vidli:

http://videocardz.com/31615/geforce-gt-...

pa tole:

http://videocardz.com/31551/geforce-600...

http://videocardz.com/31615/geforce-gt-...

pa tole:

http://videocardz.com/31551/geforce-600...

ANY OF MY POSTS ARE RESEARCHED AND/OR COMPILED BITS OF INFORMATION*

AND YOU SHOULD FOLLOW THEM AT YOUR OWN RISK.

*EXCLUDING SARCASTIC AND OR SUBJECTIVE RESPONSES!

AND YOU SHOULD FOLLOW THEM AT YOUR OWN RISK.

*EXCLUDING SARCASTIC AND OR SUBJECTIVE RESPONSES!

Lardi ::

fireX88 ::

ANY OF MY POSTS ARE RESEARCHED AND/OR COMPILED BITS OF INFORMATION*

AND YOU SHOULD FOLLOW THEM AT YOUR OWN RISK.

*EXCLUDING SARCASTIC AND OR SUBJECTIVE RESPONSES!

AND YOU SHOULD FOLLOW THEM AT YOUR OWN RISK.

*EXCLUDING SARCASTIC AND OR SUBJECTIVE RESPONSES!

s51as ::

Ajoj... in zdaj bo AMD objavil da se tudi na grafiki ne gre več tekmovanja in da se bo posvetil drugim rečem v življenju...

It's just me myself and I

Vredno ogleda ...

| Tema | Ogledi | Zadnje sporočilo | |

|---|---|---|---|

| Tema | Ogledi | Zadnje sporočilo | |

| » | AMD Radeon HD 7900 (strani: 1 2 3 4 … 47 48 49 50 )Oddelek: Strojna oprema | 373194 (253147) | rdecaluc |

| » | Nvidia Geforce GTX 7xx (strani: 1 2 3 4 … 11 12 13 14 )Oddelek: Strojna oprema | 144625 (119637) | Pro_moted |

| » | AMD-jeve kartice spet cenejše (strani: 1 2 3 )Oddelek: Novice / Grafične kartice | 31483 (27577) | Shkorc |

| » | Nvidia predstavila prvega keplerja: GTX 680Oddelek: Novice / Grafične kartice | 17271 (14378) | Isotropic |