Forum » Strojna oprema » Gradnja/sestava diskovnega polja

Gradnja/sestava diskovnega polja

levaky ::

Lep pozdrav!

V centru smo se odločili, da namesto razdrobljenih diskov sem in tja po postajah in strežnikih, naredimo centralno shrambo podatkov. Prehod na centralen sistem smo planirali že dolgo, pa nekako denarno ni zneslo, tokrat pa se je ponudila priložnost in smo jo zgrabili.

Po brskanju po raznoraznih forumih in prebiranju gradiv smo se, na koncu, odločili za lastno sestavo polja in kot OS uporabiti OpenFiler.

Ker zna biti zadeva zanimiva še za koga, sem se odločil, da sproti malo opišem postopek, opremo in probleme, na katere smo/bomo naleteli, ter s tem komu v podobni situaciji prihranimo nekaj živcev.

No, pa k stvari.

Strojna oprema:

* 19" rack ohišje Norco RPC-4220

* SAS Multilane kabli (6x)

* RAID kontroler Adaptec RAID 5405

* SAS expander Chembro CK12804

* Matična Gigabyte GA-P55-USB3

* Procesor Intel Core i3 540

* Ram Kingston PC3-12800 HyperX 4GB kit

* 2x WD 250GB 2,5" (za sistem)

* Napajalnik Cooler Master Silent PRO M700

* 2x Intel Gigabit CT Desktop

* Slim CDROM

Ohišje in SAS kabli so bili naročeni pri EU uvozniku www.ri-vier.nl (s poštnino 580€)

RAID kontroler smo naročili pri mylemon.at (s poštnino 320€)

Chembro SAS expander pri xcase.co.uk ( s poštnino 260€)

Vse ostale komponente v AGTju (s podaljšano garancijo 600€)

Skupaj trenutno znese malo čez 1700€.

Upam, da bodo komponente pri nas naslednji ponedeljek.

Trenutno nam malo gusti pri nakupu večje količine diskov, tako da bomo začeli z 4x 2TB. Po vsej verjetnosti bodo to Samsung F3 EcoGreen, čeprav sem opazil, da se sedaj dobijo že F4. Ima kdo izkušnje z njimi?

Planirana sta 2 RAID6 arraya in v vsakem bo 10 diskov.

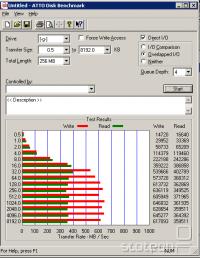

Podobno konfiguracijo ima sestavljen en Švicar, ki ima notri 10xF3 2TB diske in RAID6 polje, dosega pa naslednje rezultate:

Na storage bo direktno preko 1GBps mrežne priklopljen 1 strežnik, na katerem lavfajo VMji, ostali 2 mrežni pa bosta bondani in priklopljeni na switch za serviranje podatkov po omrežju.

Kot sem že omenil, vse skupaj bo fural openfiler.

Tako, to je to zaenkrat:) Če ima kdo kako vprašanje, predlog, idejo, kritiko, z besedo na dan.

Imamo pa eno manjšo dilemo. Odločiti se moramo med ext3 in XFS filesystemom. Kakšne so kaj prednosti enega in drugega? V končni fazi(sproti, ko bomo dodajali diske, bomo resizali FS) bo max velikost posameznega FSja okoli 10TB.

Matej

V centru smo se odločili, da namesto razdrobljenih diskov sem in tja po postajah in strežnikih, naredimo centralno shrambo podatkov. Prehod na centralen sistem smo planirali že dolgo, pa nekako denarno ni zneslo, tokrat pa se je ponudila priložnost in smo jo zgrabili.

Po brskanju po raznoraznih forumih in prebiranju gradiv smo se, na koncu, odločili za lastno sestavo polja in kot OS uporabiti OpenFiler.

Ker zna biti zadeva zanimiva še za koga, sem se odločil, da sproti malo opišem postopek, opremo in probleme, na katere smo/bomo naleteli, ter s tem komu v podobni situaciji prihranimo nekaj živcev.

No, pa k stvari.

Strojna oprema:

* 19" rack ohišje Norco RPC-4220

* SAS Multilane kabli (6x)

* RAID kontroler Adaptec RAID 5405

* SAS expander Chembro CK12804

* Matična Gigabyte GA-P55-USB3

* Procesor Intel Core i3 540

* Ram Kingston PC3-12800 HyperX 4GB kit

* 2x WD 250GB 2,5" (za sistem)

* Napajalnik Cooler Master Silent PRO M700

* 2x Intel Gigabit CT Desktop

* Slim CDROM

Ohišje in SAS kabli so bili naročeni pri EU uvozniku www.ri-vier.nl (s poštnino 580€)

RAID kontroler smo naročili pri mylemon.at (s poštnino 320€)

Chembro SAS expander pri xcase.co.uk ( s poštnino 260€)

Vse ostale komponente v AGTju (s podaljšano garancijo 600€)

Skupaj trenutno znese malo čez 1700€.

Upam, da bodo komponente pri nas naslednji ponedeljek.

Trenutno nam malo gusti pri nakupu večje količine diskov, tako da bomo začeli z 4x 2TB. Po vsej verjetnosti bodo to Samsung F3 EcoGreen, čeprav sem opazil, da se sedaj dobijo že F4. Ima kdo izkušnje z njimi?

Planirana sta 2 RAID6 arraya in v vsakem bo 10 diskov.

Podobno konfiguracijo ima sestavljen en Švicar, ki ima notri 10xF3 2TB diske in RAID6 polje, dosega pa naslednje rezultate:

Na storage bo direktno preko 1GBps mrežne priklopljen 1 strežnik, na katerem lavfajo VMji, ostali 2 mrežni pa bosta bondani in priklopljeni na switch za serviranje podatkov po omrežju.

Kot sem že omenil, vse skupaj bo fural openfiler.

Tako, to je to zaenkrat:) Če ima kdo kako vprašanje, predlog, idejo, kritiko, z besedo na dan.

Imamo pa eno manjšo dilemo. Odločiti se moramo med ext3 in XFS filesystemom. Kakšne so kaj prednosti enega in drugega? V končni fazi(sproti, ko bomo dodajali diske, bomo resizali FS) bo max velikost posameznega FSja okoli 10TB.

Matej

- zavaroval slike: bluefish ()

krho ::

* RAID kontroler Adaptec RAID 5405

Sam sem za eno manjšo virtualizacijo gledal Adaptec RAID 5805Z, ker nisem hotel takoj še z expanderjem težit, vendar sem se po prebranih naslednjih treh člankih o Adaptecu premislil. In bom raje vzel Areco najbrž ARC-1222 + Batery pack.

Članek 1

Članek 2

Članek 3

Pri takšnih fuckupih naj jih kar imajo.

si.Mail odprto-kodni odjemalec elektronske pošte. - http://www.simail.si

Uredite si svojo zbirko filmov, serij in iger - http://xcollect.sf.net

Uredite si svojo zbirko filmov, serij in iger - http://xcollect.sf.net

levaky ::

No, tole pa nisem ravno z veseljem prebral. Le kako da sam nisem našel teh postov. Našel sem nekaj objav, kjer ljudje že kar nekaj časa na istem oziroma podobnem kontrolerju lavfajo zadeve in zaenkrat brez problema. Očitno bomo tudi mi morali eno štih probo narest in upati, da pri nas ne bo prihajalo do podobnih problemov...

Je pa zanimivo, če sem prav prebral, da vsi lavfajo *BSD.

Pri Areci pazi, ker model 1222 ne podpira expanderja. Samo toliko v vednost.

Sedaj je kontroler že naročen in plačan, tako da bomo verjetno vseeno šli v sestavo in test. Bom poročal o rezultatih. Če se nam zgodi isti problem, zadevo zapakiramo in pošljemo nazaj.

hvala za info, Matej

Je pa zanimivo, če sem prav prebral, da vsi lavfajo *BSD.

Pri Areci pazi, ker model 1222 ne podpira expanderja. Samo toliko v vednost.

Sedaj je kontroler že naročen in plačan, tako da bomo verjetno vseeno šli v sestavo in test. Bom poročal o rezultatih. Če se nam zgodi isti problem, zadevo zapakiramo in pošljemo nazaj.

hvala za info, Matej

krho ::

NE tip piše gnilnike za OpenBSD. Adapteca pa uporabljajo v mail gatewayu, kateri pa teče na linuxu.

si.Mail odprto-kodni odjemalec elektronske pošte. - http://www.simail.si

Uredite si svojo zbirko filmov, serij in iger - http://xcollect.sf.net

Uredite si svojo zbirko filmov, serij in iger - http://xcollect.sf.net

levaky ::

Hum... Nič kaj vzpodbudna novica... Ko bi vsaj prej opazil te threade...

Zdej tako ne preostane drugega kot da sestavimo storage in stestiramo, če bomo imeli enake probleme...

Matej

Zdej tako ne preostane drugega kot da sestavimo storage in stestiramo, če bomo imeli enake probleme...

Matej

levaky ::

Evo, prvi kosi opreme so prišli...

Kontroler je že poupdejtan na zadnjo verzijo, sedaj pa je potrebno počakati še na preostanek robe. Če sneg ne bo preveč oviral prometa, jutri dobimo ohišje.

Največja žalost je to, da bo oprema, naročena v Sloveniji, prišla zadnja... Medtem ko so Angleži in Avstrijci že dostavili, Nizozemci pa skoraj, naši še niti ne vedo, kdaj bo oprema prišla...

Matej

Kontroler je že poupdejtan na zadnjo verzijo, sedaj pa je potrebno počakati še na preostanek robe. Če sneg ne bo preveč oviral prometa, jutri dobimo ohišje.

Največja žalost je to, da bo oprema, naročena v Sloveniji, prišla zadnja... Medtem ko so Angleži in Avstrijci že dostavili, Nizozemci pa skoraj, naši še niti ne vedo, kdaj bo oprema prišla...

Matej

Zgodovina sprememb…

- zavaroval slike: bluefish ()

levaky ::

Evo, prišel je še drugi del pošilke...

Vseh 6 SAS kablov, ki bodo povezovali backplane z expanderjem in expander s kontrolerjem.

Na žalost je prodajalec priložil napačni fan wall(manjkajo luknje na sredini) in ne morem zmontirati kablov. Trenutno čakam odgovor, vendar verjetno mi bodo poslali nov fanwall. Glede ohišja nimam kaj za rečt. Sicer nimam izkušenj z drugimi ohišji, vendar deluje izredno natančno narejen. Dovolj dolgi kabli, 2x molex za priklop redundančnega napajalnika, močni ventilatorji, ki naredijo cel prepih, je pa res, da so glasni ko hudič. Za tiste, ki mislijo imeti zadevo v bolj javnem prostoru, lahko dokupiš 3x120mm fan wall, kjer imaš lahko tišje ventilatorje. Je pa potrebno malo paziti pri podiranju in sestavljanju, saj se sem in tja še vedno najde kakšen oster rob, na katerem se lahko urežemo.

Edino kar bi rad še pogruntal je, kaj so tisti beli konektorji na desni strani backplana.

Matej

Takole pa zgleda trenutni problem z fan wallom.

Matej

Vseh 6 SAS kablov, ki bodo povezovali backplane z expanderjem in expander s kontrolerjem.

Na žalost je prodajalec priložil napačni fan wall(manjkajo luknje na sredini) in ne morem zmontirati kablov. Trenutno čakam odgovor, vendar verjetno mi bodo poslali nov fanwall. Glede ohišja nimam kaj za rečt. Sicer nimam izkušenj z drugimi ohišji, vendar deluje izredno natančno narejen. Dovolj dolgi kabli, 2x molex za priklop redundančnega napajalnika, močni ventilatorji, ki naredijo cel prepih, je pa res, da so glasni ko hudič. Za tiste, ki mislijo imeti zadevo v bolj javnem prostoru, lahko dokupiš 3x120mm fan wall, kjer imaš lahko tišje ventilatorje. Je pa potrebno malo paziti pri podiranju in sestavljanju, saj se sem in tja še vedno najde kakšen oster rob, na katerem se lahko urežemo.

Edino kar bi rad še pogruntal je, kaj so tisti beli konektorji na desni strani backplana.

Matej

Takole pa zgleda trenutni problem z fan wallom.

Matej

Zgodovina sprememb…

- zavaroval slike: bluefish ()

krho ::

Beli konektorji so najbrž diagnostika + disk activity, če imaš seveda ledice na disk rackih.

si.Mail odprto-kodni odjemalec elektronske pošte. - http://www.simail.si

Uredite si svojo zbirko filmov, serij in iger - http://xcollect.sf.net

Uredite si svojo zbirko filmov, serij in iger - http://xcollect.sf.net

levaky ::

Jap, zna biti kar prav. Konektorji imajo po 5 pinov(4x+ in 1x- za eno vrsto diskov). Ledice ima vsak rack posebej, vendar mislim, da ledice delujejo tudi, če na belem konektorju ni nič priklopljeno. Vprašanje pa je, ali samo gorijo, ko je disk v racku ali prikazujejo tudi activity...

levaky ::

No tako, končno smo prejšnjo sredo dobili še zadnje komponente(o hitrosti dostave slovenskih trgovin kdaj drugič) in tako sem lahko sestavil polje.

Trenutno čakam še nove SATA kable in molex podalške, da bodo kabli malo lepše urejeni.

V ISO-tu je nek star kernel, ki ne podpira P55 chipseta, zato sem moral inštalirate na starejšem hardweru in narediti system update. Potem je prepoznal vso strojno opremo.

Prvo polje smo sestavili iz treh 1TB diskov, 2x 1TB samsung F3 in 1x Seagate neki 1TB.

Za storage management skrbi, kot že rečeno, openfiler. Malo me skrbi dejstvo, da v brezplačni različici podpira samo do 16TB diska, ampak s tem se bomo ubadali, ko enkrat pridemo do te meje.

Trenutno se mal lotevam takšnih in drugačnih benchmarkov. Nekako imam željo za FS imeti XFS(na izbiro imam XFS in ext3), saj se po raznih testih na internetu obnese bolje kot ext3. Na trenutnem raid polju bodo večino maili(v maildir formatu) in spletne strani. Sodeč po testih na internetu, se tu xfs obnese odlično, na račun malo večje porabe CPUja, kar pa pri meni ni tak problem, saj je kontroler več kot dovolj močen.

Problem pa nastane, ko se meni XFS ne obnaša tako, kot vsem drugim. Imam porazne file create/delete bechmarke. Sicer sem bral na internetu, da je za nastalo situacijo lahko kriv write barrier of XFSa, vendar tudi, če mountam z nobarrier, pridem do enakih rezultatov.

XFS:

XFS:

Version 1.03e ------Sequential Create------ --------Random Create--------

-Create-- --Read--- -Delete-- -Create-- --Read--- -Delete--

files | /sec %CP /sec %CP /sec %CP /sec %CP /sec %CP /sec %CP

16 | 512 2 +++++ +++ 440 2 538 2 +++++ +++ 358 1

Kot se lahko vidi, dobim 512 file creation/second in 440 file delete/second. Če to primerjam z ext3:

Version 1.03e ------Sequential Create------ --------Random Create--------

-Create-- --Read--- -Delete-- -Create-- --Read--- -Delete--

files /sec %CP /sec %CP /sec %CP /sec %CP /sec %CP /sec %CP

128 51664 71 +++++ +++ 12410 14 15255 21 +++++ +++ 2405 3

kjer imam 51000 creation in 12000 delete, je stvar jasna. Nekje nekaj ne štima, ampak ne znam najti razloga. Tudi iskanje okoli te napake ni obrodilo sadov ali pa samo ne znam iskati pravo stvar. Je kdo že naletel na podobne težave?

Benchmark z bonnie++:

Version 1.03e ------Sequential Output------ --Sequential Input- --Random-

-Per Chr- --Block-- -Rewrite- -Per Chr- --Block-- --Seeks--

Machine Size K/sec %CP K/sec %CP K/sec %CP K/sec %CP K/sec %CP /sec %CP

8G 68151 81 64177 11 40733 6 94012 95 160922 18 359.6 1

Jutri bom probal še kak test z IOmetrom.

lp, Matej

Trenutno čakam še nove SATA kable in molex podalške, da bodo kabli malo lepše urejeni.

V ISO-tu je nek star kernel, ki ne podpira P55 chipseta, zato sem moral inštalirate na starejšem hardweru in narediti system update. Potem je prepoznal vso strojno opremo.

Prvo polje smo sestavili iz treh 1TB diskov, 2x 1TB samsung F3 in 1x Seagate neki 1TB.

Za storage management skrbi, kot že rečeno, openfiler. Malo me skrbi dejstvo, da v brezplačni različici podpira samo do 16TB diska, ampak s tem se bomo ubadali, ko enkrat pridemo do te meje.

Trenutno se mal lotevam takšnih in drugačnih benchmarkov. Nekako imam željo za FS imeti XFS(na izbiro imam XFS in ext3), saj se po raznih testih na internetu obnese bolje kot ext3. Na trenutnem raid polju bodo večino maili(v maildir formatu) in spletne strani. Sodeč po testih na internetu, se tu xfs obnese odlično, na račun malo večje porabe CPUja, kar pa pri meni ni tak problem, saj je kontroler več kot dovolj močen.

Problem pa nastane, ko se meni XFS ne obnaša tako, kot vsem drugim. Imam porazne file create/delete bechmarke. Sicer sem bral na internetu, da je za nastalo situacijo lahko kriv write barrier of XFSa, vendar tudi, če mountam z nobarrier, pridem do enakih rezultatov.

XFS:

XFS:

Version 1.03e ------Sequential Create------ --------Random Create--------

-Create-- --Read--- -Delete-- -Create-- --Read--- -Delete--

files | /sec %CP /sec %CP /sec %CP /sec %CP /sec %CP /sec %CP

16 | 512 2 +++++ +++ 440 2 538 2 +++++ +++ 358 1

Kot se lahko vidi, dobim 512 file creation/second in 440 file delete/second. Če to primerjam z ext3:

Version 1.03e ------Sequential Create------ --------Random Create--------

-Create-- --Read--- -Delete-- -Create-- --Read--- -Delete--

files /sec %CP /sec %CP /sec %CP /sec %CP /sec %CP /sec %CP

128 51664 71 +++++ +++ 12410 14 15255 21 +++++ +++ 2405 3

kjer imam 51000 creation in 12000 delete, je stvar jasna. Nekje nekaj ne štima, ampak ne znam najti razloga. Tudi iskanje okoli te napake ni obrodilo sadov ali pa samo ne znam iskati pravo stvar. Je kdo že naletel na podobne težave?

Benchmark z bonnie++:

Version 1.03e ------Sequential Output------ --Sequential Input- --Random-

-Per Chr- --Block-- -Rewrite- -Per Chr- --Block-- --Seeks--

Machine Size K/sec %CP K/sec %CP K/sec %CP K/sec %CP K/sec %CP /sec %CP

8G 68151 81 64177 11 40733 6 94012 95 160922 18 359.6 1

Jutri bom probal še kak test z IOmetrom.

lp, Matej

Zgodovina sprememb…

- zavaroval slike: bluefish ()

Rok22 ::

Uau super tema.

Matej še malo poročaj kako se sedaj zadeva obnese in če si uspel rešit težavo, ki si jo imel.

Edino, kar me na tehle slikcah moti je slikca na kateri je board, proc in ram. Občutek imam da si kabel za venti preveč našponal okoli ventija in da bo vse skupaj rajsalo po kablih. al samo tako izgleda na sliki?

Jaz ponavadi kabel za venti peljem kar okoli štiftov, s kaerim je venti pritrjen na board. (tisi, ki jih moraš zasukat, če želiš venti dol vzet).

Drugače pa SUPER TEMA!!! le tako naprej.

Matej še malo poročaj kako se sedaj zadeva obnese in če si uspel rešit težavo, ki si jo imel.

Edino, kar me na tehle slikcah moti je slikca na kateri je board, proc in ram. Občutek imam da si kabel za venti preveč našponal okoli ventija in da bo vse skupaj rajsalo po kablih. al samo tako izgleda na sliki?

Jaz ponavadi kabel za venti peljem kar okoli štiftov, s kaerim je venti pritrjen na board. (tisi, ki jih moraš zasukat, če želiš venti dol vzet).

Drugače pa SUPER TEMA!!! le tako naprej.

levaky ::

Ja, tisto je bilo res preveč na tesno ovito in sem potem moral zrahlati oziroma drugače speljati kable...

Storage trenutno deluje odlično. Sedaj ga serje en drug server oziroma mrežna v njem... Ampak je tudi tisto v fazi popravljanja. Glede XFSja še vedno nisem našel rešitve... Bo potrebno počakati na naslednji kernel upgrade.

Naslednji teden pridejo še novi diski, tako da bomo potem premaknili na novo polje še preostale podatke.

Matej

Storage trenutno deluje odlično. Sedaj ga serje en drug server oziroma mrežna v njem... Ampak je tudi tisto v fazi popravljanja. Glede XFSja še vedno nisem našel rešitve... Bo potrebno počakati na naslednji kernel upgrade.

Naslednji teden pridejo še novi diski, tako da bomo potem premaknili na novo polje še preostale podatke.

Matej

Rok22 ::

Se mi je zdelo ja, da bi v takem primeru venti rajsal po kablu. Jaz ponavadi gledam tudi INTEL logo na ventiju da je obrnjen pravilno (sorry, hočem, da je vse perfektno), če že kdo odpira kišto, da je vse vse perfect!

Si kje zaslediš da naj bi v novem kernelu ta tvoj problem odpravli?

Take teme me prav navdušujejo! Če tako rekoč malo pogledaš zadevo hitro ugotoviš, da zadeva niti ni tako draga, glede na to kaj ti zadeva ponuja! skratka SUPER.

Si kje zaslediš da naj bi v novem kernelu ta tvoj problem odpravli?

Take teme me prav navdušujejo! Če tako rekoč malo pogledaš zadevo hitro ugotoviš, da zadeva niti ni tako draga, glede na to kaj ti zadeva ponuja! skratka SUPER.

levaky ::

Hehe, no, moram priznati, da jaz logotipa nisem gledal:)

V detaile glede novega kernela nisem šel, so mi pa svetovali upgradena XFS irc kanalu... Zna biti kaj za barrier(http://xfs.org/index.php/XFS_FAQ#Write_... "lastnostjo", saj naj bi barrier omejil creation/delete na 500 fajlov/s. Ampak mount z -o nobarrier ne spremeni veliko zadeve... Kaj pa vem:) Trenutno kar ext3 lavfamo in deluje:)

Matej

V detaile glede novega kernela nisem šel, so mi pa svetovali upgradena XFS irc kanalu... Zna biti kaj za barrier(http://xfs.org/index.php/XFS_FAQ#Write_... "lastnostjo", saj naj bi barrier omejil creation/delete na 500 fajlov/s. Ampak mount z -o nobarrier ne spremeni veliko zadeve... Kaj pa vem:) Trenutno kar ext3 lavfamo in deluje:)

Matej

levaky ::

No pa smo tam:) Krhove napovedi so se uresničile...

Po dobrih treh mescih testiranj kontrolerja nismo in nismo mogli spraviti v red. Na začetku je še kazalo, da bodo stvari OK delale, a so se kmalu začeli problemi. Iz neznanega razloga so diski leteli iz arraya, občasno je sistem potem ponovno zaznal disk in rebuildal raid, večino krat pa ne. Dogajalo se je tudi, da po resetu PC ni zaznal kontrolerja in je bilo potrebno server ugasnit in ponovno prižgati.

Da nebi bila kriva ravno napačna verzija driverjev/firmwara, OS-a ali hardwera, sem zadevo testiral tako na linux-u(debian in RH) kot MS Server 2008, 2 različna hardwera in različni diski in vsakič sem imel enake probleme. Preizkusim sem tudi 3 verzije firmwara in prav toliko driverjev.

Kontroler je romal nazaj v trgovino, kjer sem dobil dobropis in sedaj sem pred dilemo, kateri kontroler kupiti. Na žalost v mylemon.at nimajo velike izbire kontrolerjev, tako da imam na izbiro nekaj Intelovih ter nekaj LSIja(ki je sicer napisan pod HP opremo in me malo skrbi, da nebi deloval na NON-HP opremi).

Trenutno imam ogledana naslednje dva:

LSI 9260-8I SAS 6GB/S ROC RAID

Intel RS2BL080

Tako en kot drugi imata na sebi enak LSIjev LSISAS2108 800MHz procesor. HP-jev LSI podpira več diskov(do 128 preko SAS expanderja), medtem ko Intel samo 32(kar je vseeno dovolj za naše trenutne potrebe).

Me pa malo skrbi tisti HPjev LSI, saj pri opisu piše, da je "Dedicated workstation z400,600,800". Ali to lahko pomeni, da kontroler preverja, ali teče na HPjevem hardweru in se v nasprotnem primeru noče zagnati?

Ima kdo izkušnje z zgoraj omenjenima? Predvsem me zanima delovanje pod linux-om.

Ali kdo ve za podobne probleme, kot jih ima Adaptec?

Če ima kdo kakšno minuto časa viška pa ga prosim, če lahko skoči tudi na mylemon stran in preveri, če je tam kakšen kontroler, ki bi se morda bolje odrezal kot zgornje dva.

Najlepša hvala, Matej

Po dobrih treh mescih testiranj kontrolerja nismo in nismo mogli spraviti v red. Na začetku je še kazalo, da bodo stvari OK delale, a so se kmalu začeli problemi. Iz neznanega razloga so diski leteli iz arraya, občasno je sistem potem ponovno zaznal disk in rebuildal raid, večino krat pa ne. Dogajalo se je tudi, da po resetu PC ni zaznal kontrolerja in je bilo potrebno server ugasnit in ponovno prižgati.

Da nebi bila kriva ravno napačna verzija driverjev/firmwara, OS-a ali hardwera, sem zadevo testiral tako na linux-u(debian in RH) kot MS Server 2008, 2 različna hardwera in različni diski in vsakič sem imel enake probleme. Preizkusim sem tudi 3 verzije firmwara in prav toliko driverjev.

Kontroler je romal nazaj v trgovino, kjer sem dobil dobropis in sedaj sem pred dilemo, kateri kontroler kupiti. Na žalost v mylemon.at nimajo velike izbire kontrolerjev, tako da imam na izbiro nekaj Intelovih ter nekaj LSIja(ki je sicer napisan pod HP opremo in me malo skrbi, da nebi deloval na NON-HP opremi).

Trenutno imam ogledana naslednje dva:

LSI 9260-8I SAS 6GB/S ROC RAID

Intel RS2BL080

Tako en kot drugi imata na sebi enak LSIjev LSISAS2108 800MHz procesor. HP-jev LSI podpira več diskov(do 128 preko SAS expanderja), medtem ko Intel samo 32(kar je vseeno dovolj za naše trenutne potrebe).

Me pa malo skrbi tisti HPjev LSI, saj pri opisu piše, da je "Dedicated workstation z400,600,800". Ali to lahko pomeni, da kontroler preverja, ali teče na HPjevem hardweru in se v nasprotnem primeru noče zagnati?

Ima kdo izkušnje z zgoraj omenjenima? Predvsem me zanima delovanje pod linux-om.

Ali kdo ve za podobne probleme, kot jih ima Adaptec?

Če ima kdo kakšno minuto časa viška pa ga prosim, če lahko skoči tudi na mylemon stran in preveri, če je tam kakšen kontroler, ki bi se morda bolje odrezal kot zgornje dva.

Najlepša hvala, Matej

levaky ::

Oziroma v primeru, da nič od tega tukaj ne ustreza, kateri kontroler bi priporočali? Firmo in model...

Matej

Matej

krho ::

Sam sem vzel potem vzel 5x WD 1T RE4, ter Areco ARC-1680i ter naredil RAID 10 + hot spare. Vse skupaj diski in kontroler + kabli + battery pack je bilo cca 1000EUR.

Je pa zanimivo tole.

Tole je na enem navadnem dual coru s zgornjimi diski:

BUFFERED READS: 289.84 MB/sec

AVERAGE SEEK TIME: 7.53 ms

FSYNCS/SECOND: 2734.11

Tole je pa na HPjevem P410i kontroleju s 512M buferja in 6x 2,5" 300G 10000rpm diskih v RAID10

BUFFERED READS: 166.24 MB/sec

AVERAGE SEEK TIME: 12.82 ms

FSYNCS/SECOND: 1247.34

Pa hoče recimo HP za tistole usrano P410ko skoraj toliko, kot je bila Areca

Je pa zanimivo tole.

Tole je na enem navadnem dual coru s zgornjimi diski:

BUFFERED READS: 289.84 MB/sec

AVERAGE SEEK TIME: 7.53 ms

FSYNCS/SECOND: 2734.11

Tole je pa na HPjevem P410i kontroleju s 512M buferja in 6x 2,5" 300G 10000rpm diskih v RAID10

BUFFERED READS: 166.24 MB/sec

AVERAGE SEEK TIME: 12.82 ms

FSYNCS/SECOND: 1247.34

Pa hoče recimo HP za tistole usrano P410ko skoraj toliko, kot je bila Areca

si.Mail odprto-kodni odjemalec elektronske pošte. - http://www.simail.si

Uredite si svojo zbirko filmov, serij in iger - http://xcollect.sf.net

Uredite si svojo zbirko filmov, serij in iger - http://xcollect.sf.net

Zgodovina sprememb…

- spremenil: krho ()

Daedalus ::

Zakaj pa ne ob spodobnem procesorju in spodobni količini rama sprobaš softraida? Jaz sem podedoval en server z Areco 2xxx (bom pogledal točen model) in zadeva ima v raid6 obupne performanse.

@krho - s čim si to testiral? Pa HP kontrolerji (vsaj P4xx do P8xx) niso neko čudo tehnike. Ko sem delal benchmarke na P800 raid 5 vs Solaris ZFS raid 5 varijanta, ga je ZFS potolkel. In to kompletno.

SAS HBA + softraid. Kak LSI je poceni in dober. Za filesystem pa jfs, če ti xfs dela probleme. JFS je spodoben all round performance file system, pa precej težko ga je sesuti:) Jaz se sicer poceni HW kontrolerjem izogibam. Al niso lih zanesljivi, al pa performančno smrdijo. Al pa oboje.

@krho - s čim si to testiral? Pa HP kontrolerji (vsaj P4xx do P8xx) niso neko čudo tehnike. Ko sem delal benchmarke na P800 raid 5 vs Solaris ZFS raid 5 varijanta, ga je ZFS potolkel. In to kompletno.

Oziroma v primeru, da nič od tega tukaj ne ustreza, kateri kontroler bi priporočali? Firmo in model...

SAS HBA + softraid. Kak LSI je poceni in dober. Za filesystem pa jfs, če ti xfs dela probleme. JFS je spodoben all round performance file system, pa precej težko ga je sesuti:) Jaz se sicer poceni HW kontrolerjem izogibam. Al niso lih zanesljivi, al pa performančno smrdijo. Al pa oboje.

Man is condemned to be free; because once thrown into the world,

he is responsible for everything he does.

[J.P.Sartre]

he is responsible for everything he does.

[J.P.Sartre]

Brane2 ::

SW raid je IMHO problematičen za RAID-6, ker je tadruga pariteta totalen bitch za zgenerirat in še večji za recover.

V bistvu ni fora v tem,d a bi bil tako prekleto zahteven kot v tem, da se dela za vsak byte posebej.

Saj HW za tole IMHO ne bi bil kaj strašno kompliciran, le potek in medsebojna odvisnost operacij totalka ubija konvencionalen CPU.

Baje da obstaja nek nov postopek, ki je bistveno manj zatežen, samo ta je AFAIK patentiran...

RAID-5 je druga pesem, ker je pariteta čisti XOR.

V bistvu ni fora v tem,d a bi bil tako prekleto zahteven kot v tem, da se dela za vsak byte posebej.

Saj HW za tole IMHO ne bi bil kaj strašno kompliciran, le potek in medsebojna odvisnost operacij totalka ubija konvencionalen CPU.

Baje da obstaja nek nov postopek, ki je bistveno manj zatežen, samo ta je AFAIK patentiran...

RAID-5 je druga pesem, ker je pariteta čisti XOR.

On the journey of life, I chose the psycho path.

Daedalus ::

Jap, raid6 je zatežen za CPU. Zato jaz za softraid uporabljam raid5 + hotspare, če čem biti on the "safe" side. Itak poleg takega storaga rabiš še backup (al pa sekundarni storage), tak da bi blo verjetno razmislit tud kaj na temo raid levela. V vsakem primeru pa je ob resnejši napaki (crk kontrolerja) software raid dosti lažje zanesljivo spravit skup, ko hw.

Man is condemned to be free; because once thrown into the world,

he is responsible for everything he does.

[J.P.Sartre]

he is responsible for everything he does.

[J.P.Sartre]

Pyr0Beast ::

Sam bi zadevo izpeljal še z dodatnimi Esata diski priklopljenimi direktno na server + backup preko mreže

SW raid zna biti zafrknjen, če se čipset kaj afna pri velikih pretokih podatkov, odpade pa ti potreba po dodatnem kontrolerju za diske, kar pa spet zmanjša obremenitev.

SW raid zna biti zafrknjen, če se čipset kaj afna pri velikih pretokih podatkov, odpade pa ti potreba po dodatnem kontrolerju za diske, kar pa spet zmanjša obremenitev.

Some nanoparticles are more equal than others

Good work: Any notion of sanity and critical thought is off-topic in this place

Good work: Any notion of sanity and critical thought is off-topic in this place

Brane2 ::

Sem probal na dokaj poceni AMD plati s starim Phenomom.

Dela dokaj solidno za največjo večino aplikacij, čeprav so od 10-tih diskov štrije na eksterni 4xSATA--PCIex4 kartici.

Hitrosti branja čez 400MB/s niso problem pri 256KiB chunku. Da se doseči čez 600MiB/s z večjim chunkom, vendar se s tem nisem hotel zezat, ker bi zbilo performanse pri manjših datotekah.

Pri teh Samsungih je treba pazit, ker ima 4KiB sektorje, emulira pa 512-bytne, da je stvar particionirana in filesystem inicializiran tako, da mu podatki optimalno padejo na to velikost...

Kartice te in druge vrste sem najceneje in najugodneje dobil pri Remisu...

Dela dokaj solidno za največjo večino aplikacij, čeprav so od 10-tih diskov štrije na eksterni 4xSATA--PCIex4 kartici.

Hitrosti branja čez 400MB/s niso problem pri 256KiB chunku. Da se doseči čez 600MiB/s z večjim chunkom, vendar se s tem nisem hotel zezat, ker bi zbilo performanse pri manjših datotekah.

Pri teh Samsungih je treba pazit, ker ima 4KiB sektorje, emulira pa 512-bytne, da je stvar particionirana in filesystem inicializiran tako, da mu podatki optimalno padejo na to velikost...

Kartice te in druge vrste sem najceneje in najugodneje dobil pri Remisu...

On the journey of life, I chose the psycho path.

levaky ::

Daedalus: Kaj zate pomeni "poceni" kontroler... Ali se kontrolerji v rangu 400-500EUR smatrajo pod poceni? Pa še glede softraida... Kaj naj bi bil spodoben procesor in količina rama... Trenutno je v kompu nek osnoven i3 dual core z 4GB rama... Bo pa kišta izključno NAS/SAN, tako da bo proc več ali manj idlal, rama se pa tudi prav veliko ne rabi...

Zaenkrat so planirana RAID5 polja + hot spari. RAID6 verjetno ne bomo delali, tako da načeloma softraid nebi bila preveč zahtevna izbira... Sicer mi pa kernel ob bootu javi neke RAID6 performance okoli 2GB/s(ne vem koliko je tisto verodostojno).

Software raid sem probal na trenutnem kontrolerju, pa je bil performance porazen. Ampak verjetno je bil tukaj za slabe performance kriv tudi sam kontroler.

Ima pa vsaka stran svoje pluse in minuse. Pri softraidu v primeru, da odleti en disk, ne morš samo hot swapat diska in stvar dela naprej, ampak moraš ročno narest novo particijsko tabelo in dodati diske v RAID polje. Kar je ponavadi ok, problem pa je, če to dela nekdo, ki tega ne zna(scenarij, da na dosegu ni nobenega administratorja).

Vglavnem, rad bi kupil nek kontroler, za katerega mi ne bo žal čez pol leta, kot mi je za Adapteca. Softraid se sicer fino sliši, ampak si ne morem privoščiti nakupa HBA in potem ugotoviti, da so pa performanci porazni. Ker denarja za HBA in RAID kontroler pa ni:) Edino če bi kupil RAID kontroler, ki podpira tudi JBOD. Areca oh krhota podpira tako RAID kot JBOD, kar ni slabo za takšne eksperimente...:)

Matej

Zaenkrat so planirana RAID5 polja + hot spari. RAID6 verjetno ne bomo delali, tako da načeloma softraid nebi bila preveč zahtevna izbira... Sicer mi pa kernel ob bootu javi neke RAID6 performance okoli 2GB/s(ne vem koliko je tisto verodostojno).

Software raid sem probal na trenutnem kontrolerju, pa je bil performance porazen. Ampak verjetno je bil tukaj za slabe performance kriv tudi sam kontroler.

Ima pa vsaka stran svoje pluse in minuse. Pri softraidu v primeru, da odleti en disk, ne morš samo hot swapat diska in stvar dela naprej, ampak moraš ročno narest novo particijsko tabelo in dodati diske v RAID polje. Kar je ponavadi ok, problem pa je, če to dela nekdo, ki tega ne zna(scenarij, da na dosegu ni nobenega administratorja).

Vglavnem, rad bi kupil nek kontroler, za katerega mi ne bo žal čez pol leta, kot mi je za Adapteca. Softraid se sicer fino sliši, ampak si ne morem privoščiti nakupa HBA in potem ugotoviti, da so pa performanci porazni. Ker denarja za HBA in RAID kontroler pa ni:) Edino če bi kupil RAID kontroler, ki podpira tudi JBOD. Areca oh krhota podpira tako RAID kot JBOD, kar ni slabo za takšne eksperimente...:)

Matej

Zgodovina sprememb…

- spremenil: levaky ()

jype ::

levaky> Pri softraidu v primeru, da odleti en disk, ne morš samo hot swapat diska in stvar dela naprej, ampak moraš ročno narest novo particijsko tabelo in dodati diske v RAID polje. Kar je ponavadi ok, problem pa je, če to dela nekdo, ki tega ne zna(scenarij, da na dosegu ni nobenega administratorja).

V primerjavi z glavobolom, ki ga dobiš, če odleti kontroler (in nujno potrebuješ podatke, pa pojma nimaš kje na diskih se valjajo, enak kontroler je pa 2 tedna dobave daleč), je to zanemarljivo.

V primerjavi z glavobolom, ki ga dobiš, če odleti kontroler (in nujno potrebuješ podatke, pa pojma nimaš kje na diskih se valjajo, enak kontroler je pa 2 tedna dobave daleč), je to zanemarljivo.

Brane2 ::

Kartica za SATA diske je pri REMISu ene EUR60 z DDV AFAIK.

Zapikaj par kartic v uno plato pa probaj.

Zapikaj par kartic v uno plato pa probaj.

On the journey of life, I chose the psycho path.

jype ::

Še eden mojih podvigov, ki je trajal precej predolgo, ker nihče ne dokumentira, kako je polje na diskih kontrolerja dejansko sestavljeno (tu je šlo za 3ware 9500):

webmail:~ # losetup -o 524288 /dev/loop0 /dev/sdd

webmail:~ # losetup -o 524288 /dev/loop1 /dev/sdb

webmail:~ # losetup -o 524288 /dev/loop2 /dev/sdc

webmail:~ # losetup -o 524288 /dev/loop3 /dev/sdd

webmail:~ # ./mdadm -C /dev/md3 -n 4 -l 5 -b /tmp/3wr15 -p ra -c 64 --assume-clean -R -f /dev/loop2 /dev/loop3 /dev/loop0 /dev/loop1

webmail:~ # ./kpartx -av /dev/md3

webmail:~ # pvscan /dev/mapper/md3p5

webmail:~ # vgchange -ay last

webmail:~ # mount /dev/mapper/last-root /mnt/root/

webmail:~ # mount /dev/mapper/md3p1 /mnt/root/boot/

webmail:~ # mount /dev/mapper/last-var /mnt/root/var/

webmail:~ # mount /dev/mapper/last-home /mnt/root/home/

webmail:~ # df -h

Filesystem Size Used Avail Use% Mounted on

/dev/md0 21G 1.5G 19G 8% /

tmpfs 2.0G 0 2.0G 0% /dev/shm

/dev/md2 53G 18G 35G 34% /var

/dev/mapper/last-root

20G 960M 18G 5% /mnt/root

/dev/mapper/md3p1 236M 44M 181M 20% /mnt/root/boot

/dev/mapper/last-var 50G 9.2G 41G 19% /mnt/root/var

/dev/mapper/last-home

600G 132G 469G 22% /mnt/root/home

Zgodovina sprememb…

- spremenilo: jype ()

Brane2 ::

Pa saj če prav vidim, imaš v plati že štekerje za 8 diskov.

Več ko dost za začetek.

Procesor bi moral biti več ko dost za tole.

Kar se diskov in hot swapa tiče, ne vem ampak saj imaš lahko hot + cold spare.

Hot spare je v mašini, cold spare pa že predpripravljen na polici.

Če disk crkne, bo stroj avtomatično uporabil hot-spare. Če je kljub temu frka za zamenjavo, bo pač nekdo s police vzel cold-spare in ga šutnil v mašino.

Bootaš tako mašinco povsem solidno s FLASH USB ključka. Najbolj robustno in najmanj težav.

Kernelu se da že v start vrstici dopovedati, kako naj sestavi in oštevilči polja, tako da imaš komot na raidu cel sistem, ravno tako swap.

Med inicialnim zafrkavanjem in testiranjem obvezno aktiviraj bitmap polja, tako bo sicer delo polja nekaj malega počasnejše in glave bodo letele več sem in tja, ampak ob nenadnem sesutju ali resetu ne bo dolgega rekreiranja paritete.

KO zluftaš vse probleme in sistem dela, bitmape obvezno izklopi, ker takrat samo nepotrebno drkajo glave.

Več ko dost za začetek.

Procesor bi moral biti več ko dost za tole.

Kar se diskov in hot swapa tiče, ne vem ampak saj imaš lahko hot + cold spare.

Hot spare je v mašini, cold spare pa že predpripravljen na polici.

Če disk crkne, bo stroj avtomatično uporabil hot-spare. Če je kljub temu frka za zamenjavo, bo pač nekdo s police vzel cold-spare in ga šutnil v mašino.

Bootaš tako mašinco povsem solidno s FLASH USB ključka. Najbolj robustno in najmanj težav.

Kernelu se da že v start vrstici dopovedati, kako naj sestavi in oštevilči polja, tako da imaš komot na raidu cel sistem, ravno tako swap.

Med inicialnim zafrkavanjem in testiranjem obvezno aktiviraj bitmap polja, tako bo sicer delo polja nekaj malega počasnejše in glave bodo letele več sem in tja, ampak ob nenadnem sesutju ali resetu ne bo dolgega rekreiranja paritete.

KO zluftaš vse probleme in sistem dela, bitmape obvezno izklopi, ker takrat samo nepotrebno drkajo glave.

On the journey of life, I chose the psycho path.

Pyr0Beast ::

Usb flash jaz raje nebi. Se sistem 'zatika' ko gre zadeva v Swap.

Some nanoparticles are more equal than others

Good work: Any notion of sanity and critical thought is off-topic in this place

Good work: Any notion of sanity and critical thought is off-topic in this place

Brane2 ::

Kako to misliš ?

Mislu sem samo /boot ( kernel, grub, memtest itd) na ključku. Vse ostalo je na RAID-u, tudi swap...

S ključka se ti tako naloći samo bootloader, kernel in mogoče boot ramdisk ( initrd ), če ga rabiš.

Mislu sem samo /boot ( kernel, grub, memtest itd) na ključku. Vse ostalo je na RAID-u, tudi swap...

S ključka se ti tako naloći samo bootloader, kernel in mogoče boot ramdisk ( initrd ), če ga rabiš.

On the journey of life, I chose the psycho path.

Pyr0Beast ::

hm

Če bi home zmetal na HDD bi še kar šlo. Hmm.

Če bi home zmetal na HDD bi še kar šlo. Hmm.

Some nanoparticles are more equal than others

Good work: Any notion of sanity and critical thought is off-topic in this place

Good work: Any notion of sanity and critical thought is off-topic in this place

Brane2 ::

Zakaj ? Kje je problem ?

Če hočeš, da ti je sistem na posebni particijo ločeno od glavnine diskov, fajn.

Pač narediš posebno polje za to. na enem je swap, ne drugem sistem, na trejem recimo /root, četrti ima pa recim 16GiB in je načeloma prazna rezerva, ki jo lahko ponucaš v kaki zateženi situaciji kot extra swap, backup sistema etc, in na peti daš vse ostalo.

Zakaj bi ob RAID-u imel karkoli na samostojnem disku ?

Če hočeš, da ti je sistem na posebni particijo ločeno od glavnine diskov, fajn.

Pač narediš posebno polje za to. na enem je swap, ne drugem sistem, na trejem recimo /root, četrti ima pa recim 16GiB in je načeloma prazna rezerva, ki jo lahko ponucaš v kaki zateženi situaciji kot extra swap, backup sistema etc, in na peti daš vse ostalo.

Zakaj bi ob RAID-u imel karkoli na samostojnem disku ?

On the journey of life, I chose the psycho path.

Pyr0Beast ::

Čisto samo zaradi tega ker USB ključki negativno vplivajo na odzivnost sistema. Ko je treba kaj prebrati sistem čaka, ko je treba zapisati sistem čaka. Posledično so prenosi mnogo nižji kakor bi lahko bili.

Some nanoparticles are more equal than others

Good work: Any notion of sanity and critical thought is off-topic in this place

Good work: Any notion of sanity and critical thought is off-topic in this place

Brane2 ::

Prebrat je treba samo par startnih sektorjev, da se naloži GRUB bootloader, nato pa samo tistih 5-10 MiB, da se naloži kernel.

To je sekunda, verjetno manj. Čim je kernel naložen, je ključ nepomemben.

Poleg tega, USB ključek ni tako neodziven kot misliš.

Ja, s kakim klasičnim filesistemom že mogoče. Z NILFS2 pa je _veliko_ hitrejši in trpežnejši.

A nisem ziher, da se zna GRUB bootat z NILFS2, pa tudi ni treba komlicirat za tistih par MB v enem fajlu.

To je sekunda, verjetno manj. Čim je kernel naložen, je ključ nepomemben.

Poleg tega, USB ključek ni tako neodziven kot misliš.

Ja, s kakim klasičnim filesistemom že mogoče. Z NILFS2 pa je _veliko_ hitrejši in trpežnejši.

A nisem ziher, da se zna GRUB bootat z NILFS2, pa tudi ni treba komlicirat za tistih par MB v enem fajlu.

On the journey of life, I chose the psycho path.

Zgodovina sprememb…

- spremenil: Brane2 ()

Pyr0Beast ::

No, Nilfs2 nisem še sprobaval, zna biti res hitrejši. Jaz sem ga fural na ext2

Some nanoparticles are more equal than others

Good work: Any notion of sanity and critical thought is off-topic in this place

Good work: Any notion of sanity and critical thought is off-topic in this place

Brane2 ::

NILFS je zlahka 10x hitrejši, verjetno več.

A kot rečeno, to za /boot ni pomembno...

Aja, pa s sistemom na ključku z ext2/3/4 sem ključek relativno hitro s*ukal.

Na NILFS2 je bil praktično večen.

A kot rečeno, to za /boot ni pomembno...

Aja, pa s sistemom na ključku z ext2/3/4 sem ključek relativno hitro s*ukal.

Na NILFS2 je bil praktično večen.

On the journey of life, I chose the psycho path.

Zgodovina sprememb…

- spremenil: Brane2 ()

levaky ::

Glede boota ni problema, ker je v serverju tako ali tako dedicated 2x250GB disk namenjen samo sistemu.

Obični SATA kontrolerju ne pridejo v poštev, ker imam na SAS backplan-ih SFF-8087 konektorje in nebi rad še SFF-8087 TO SATA kable kupoval(verjetno niti niso ravno poceni). Poleg tega tudi ni ne vem koliko prostora v plati, saj 2 reži zavzemata mrežni, eno grafična, ostaneta pa še 2 PCIe x16 in ena PCI(v primeru, da ven vzamem RAID kontroler in expander). Za 20 diskov bi pa rabil kar nekaj kontrolerjev.

Po drugi strani imam izredno slabe izkušnje z poceni SATA kontrolerji. Ob velikih prenosih so klecal kot po vrsti in so morali ves čas resetirat SATA vodilo...

p.s.: sem šel še enkrat brati Branetov odgovor in vidim zakaj je pisal tisto o poceni SATA kontrolerjih. Bom danes poizkusil direktno na plato priklopit par diskov in naredil SW RAID5, da vidim kako se zadeva obnese...

Če takole malo razmišljam, RAID5 za današnje procesorje tako ali tako nebi smel bit kak velik zalogaj? Če mora računati samo XOR, sploh v primeru, da ima 2 jedra, ki samo idlata... Morda kdo ve, kakšen bi bil teoretični throughput?

Matej

Obični SATA kontrolerju ne pridejo v poštev, ker imam na SAS backplan-ih SFF-8087 konektorje in nebi rad še SFF-8087 TO SATA kable kupoval(verjetno niti niso ravno poceni). Poleg tega tudi ni ne vem koliko prostora v plati, saj 2 reži zavzemata mrežni, eno grafična, ostaneta pa še 2 PCIe x16 in ena PCI(v primeru, da ven vzamem RAID kontroler in expander). Za 20 diskov bi pa rabil kar nekaj kontrolerjev.

Po drugi strani imam izredno slabe izkušnje z poceni SATA kontrolerji. Ob velikih prenosih so klecal kot po vrsti in so morali ves čas resetirat SATA vodilo...

p.s.: sem šel še enkrat brati Branetov odgovor in vidim zakaj je pisal tisto o poceni SATA kontrolerjih. Bom danes poizkusil direktno na plato priklopit par diskov in naredil SW RAID5, da vidim kako se zadeva obnese...

Če takole malo razmišljam, RAID5 za današnje procesorje tako ali tako nebi smel bit kak velik zalogaj? Če mora računati samo XOR, sploh v primeru, da ima 2 jedra, ki samo idlata... Morda kdo ve, kakšen bi bil teoretični throughput?

Matej

levaky ::

Drugi problem, ki se mi pojavlja pri softraidu je hitrost prenosa, ko bo diskov polje enkrat polno. Pri HW RAIDu podatek na disk pošlješ enkrat, kjer ga kontroler obdela in zapiše, medtem ko moraš pri SW raidu isti podatek poslati po vodilu trikrat(v primeru RAID5) in se tako verjetno PCIe vodilo veliko hitreje zapolne?

Trenutno malo gledam zmogljivosti PCIe vodila in v primeru PCIe x8 kontrolerja in verzije PCIe 3.0, zmore stvar 8GB/s, ker bi morali biti dovolj tudi za poln storage diskov.

Matej

Trenutno malo gledam zmogljivosti PCIe vodila in v primeru PCIe x8 kontrolerja in verzije PCIe 3.0, zmore stvar 8GB/s, ker bi morali biti dovolj tudi za poln storage diskov.

Matej

zee ::

Imel sem SW RAID5 na Linuxu s 6x 320GB trdimi diski in je stvar delala brez problema zelo hitro. Poudariti tudi moram, da sem tipicno premetaval (read + write) nekaj 30-50 GB velike datoteke.

zee

Linux: Be Root, Windows: Re Boot

Giant Amazon and Google Compute Cloud in the Sky.

Linux: Be Root, Windows: Re Boot

Giant Amazon and Google Compute Cloud in the Sky.

levaky ::

Tudi pri nas bo 90% sequential read/write, ker bo zadeva služila kot en centralni NAS(veliko bo video materiala iz montaž).

Samo na enem polju bodo web strani in mailu. Tam bi znal RAID10 priti bolj v poštev, kolikor berem po internetu?

Matej

Samo na enem polju bodo web strani in mailu. Tam bi znal RAID10 priti bolj v poštev, kolikor berem po internetu?

Matej

krho ::

@Daedalus: pvepref (openvz performace test), sem pa preč odrezal DNS zakasnitev ter BOGOMIPSe. RAID 5 ter celo RAID 50 sta pri virtualizaciji neuporabna, ker je zadeva vsaj pol počasnejša.

si.Mail odprto-kodni odjemalec elektronske pošte. - http://www.simail.si

Uredite si svojo zbirko filmov, serij in iger - http://xcollect.sf.net

Uredite si svojo zbirko filmov, serij in iger - http://xcollect.sf.net

bosto ::

um, malo pozno pa vendar, če te še zanima uporaba xfs boš morda v tej temi našel kak pameten nasvet: xfs on steroids.

Pred kar precej časa sem se malo igral z xfs, delete časi so res nenormalni, se pa da to kar popravit če se dobro spomnim.

Pred kar precej časa sem se malo igral z xfs, delete časi so res nenormalni, se pa da to kar popravit če se dobro spomnim.

levaky ::

Brane2: Mimogrede, kako pa pravilno particioniram in inicializiram FS za samsung diske?

Matej

Matej

Brane2 ::

ZAkaj pa ne ext4 BTW ?

Sicer ni v uporabi celo večnost, kot je ext3, vendar že kar nekaj časa z njim nihče ni imel težav.

Jaz ga mam na vseh svojih strežnikih, zaenkrat brez problemov, pa prav fino dela.

Res pa da ga nisem šel benchmarkat in neke zmerne razlike v hitrosti še opazil ne bi.

Sem pa uporabil opcije user_xattr dir_index,filetype,extent( ta je bistven), sparse_super( da ni toliko kopij superblokov, na velikem disku se pozna), large_file,acl. Za journal imam journal_data_writeback. stride je pri meni enak chunku RAID polja ( 256k, torej 64 blokov ), stripe-width pa 8x večji ( mam 9 diskov v RAID-5, kjer je 8 diskov podatkovnih in en parity) torej 2048k ( = 512 blokov )

Sicer ni v uporabi celo večnost, kot je ext3, vendar že kar nekaj časa z njim nihče ni imel težav.

Jaz ga mam na vseh svojih strežnikih, zaenkrat brez problemov, pa prav fino dela.

Res pa da ga nisem šel benchmarkat in neke zmerne razlike v hitrosti še opazil ne bi.

Sem pa uporabil opcije user_xattr dir_index,filetype,extent( ta je bistven), sparse_super( da ni toliko kopij superblokov, na velikem disku se pozna), large_file,acl. Za journal imam journal_data_writeback. stride je pri meni enak chunku RAID polja ( 256k, torej 64 blokov ), stripe-width pa 8x večji ( mam 9 diskov v RAID-5, kjer je 8 diskov podatkovnih in en parity) torej 2048k ( = 512 blokov )

On the journey of life, I chose the psycho path.

Brane2 ::

Brane2: Mimogrede, kako pa pravilno particioniram in inicializiram FS za samsung diske?

Matej

Diski v bistvu delajo z 4k sektorji, vendar tega navzven ni videt, ker HW rezucka sektorje na 512-bytne. Softver pač ve, da lahko pri vsaki zahtevi enega sektorja ostalih 7 dobi "zastonj", ker so itak že prebrani, saj so bili del 4-k fizičnega sektorja na plošči.

Problem je sestavljen iz dveh delov:

- vpis enega 512-bytnega sektorja dejanjsko povzroči štalo, ker mora disk narediti read 4k- modify 512 bytes - write 4k sosledje.

Vpis celotnih 4k je cenejši, saj disk samo vpiše cel sektor in s tem prepiše staro vsebino.

- vpis 4k ( torej 8 x 512 B sektorjev), ki niso poravnani na naravne meje. 0,8,16,24,32... sektorjev. Takrat sledita kar dva read-modify-write cikla.

Problema rešuješ po delih.

Drugi del problema rešiš tako, da sparticioniraš disk tako,d a se ti vsaka particija začne na sektorju, katerega številka je deljiva z 8. Tako z fdiskom nastaviš prvo particijo tako, da se ne začne na sektrju 63 ampak 64, naslednje pa podobno, čeprav tam že fdisk _ponavadi_ poskrbi za alignment.

Prvi del problema pa rešiš tako, da nastaviš pri mke2fs ustrezen stride in stripe-width. Takrat bo mke2fs postavil ustrezno metadato tako, da se ta razleze po stripeih, ker pa so ti večkratnik 4k, se bo stvar optimalno usedla tudi na nove sektorje.

To je vse, kar vem. Če imaš kaj novega, prosim za feedback...

On the journey of life, I chose the psycho path.

LuiIII ::

Sam ravno zaradi podobnih izkušenj ne zaupam prav dobro HW RAIDu. Tako imam domači server lepo na ZFS datotečnem sistemu. Ker praktično ni paralelnega prometa in ne rabim visokih IOP, zadostuje en bolj zelen AMD, 4GB ECC RAM za poganjanje RAIDZ1. Hitrosti so blizu 90MB/s, kar mi za filme, risanke in dokumente popolnoma zadošča.

Daedalus ::

Daedalus: Kaj zate pomeni "poceni" kontroler... Ali se kontrolerji v rangu 400-500EUR smatrajo pod poceni?

Tako nekak. S tistimi parimi, s katerimi sem delal, me niso impresionirali. Jih običajno kr potolčejo sw raid - linux al pa zfs. Vsaj HP-jev P800 je zfs tako nabil, da sem samo debelo gledal. Diske sem pa priklopil na LSI-jev HBA za ene 140EUR.

Man is condemned to be free; because once thrown into the world,

he is responsible for everything he does.

[J.P.Sartre]

he is responsible for everything he does.

[J.P.Sartre]

Brane2 ::

Jaz sem si ubodu tele:

Digitus DS-30104

Poceni šrot, a povsem zadosti za mojo uporabo. Gre za PCIex4 karto za 4 diske ( dva sta lahko zunanja), ki dela lepo v portu za grafikuljo.

Stane ene EUR60+ z DDV pri Remisu mislim.

Ma kdo kako poceni varianto za 8 ali več SATA diskov ?

Digitus DS-30104

Poceni šrot, a povsem zadosti za mojo uporabo. Gre za PCIex4 karto za 4 diske ( dva sta lahko zunanja), ki dela lepo v portu za grafikuljo.

Stane ene EUR60+ z DDV pri Remisu mislim.

Ma kdo kako poceni varianto za 8 ali več SATA diskov ?

On the journey of life, I chose the psycho path.

Vredno ogleda ...

| Tema | Ogledi | Zadnje sporočilo | |

|---|---|---|---|

| Tema | Ogledi | Zadnje sporočilo | |

| » | Začetek projekta OpenZFS (strani: 1 2 3 )Oddelek: Novice / Znanost in tehnologija | 19376 (14565) | BaToCarx |

| » | OS za SAN (strani: 1 2 3 )Oddelek: Operacijski sistemi | 17690 (13913) | jlpktnst |

| » | Poceni ESXi strežnik(izbira HWja)Oddelek: Strojna oprema | 3085 (2790) | levaky |

| » | Rack ohišje za diskovno poljeOddelek: Strojna oprema | 2667 (2543) | levaky |

| » | RAID5 - software, s pomocjo maticne, kako drugace.Oddelek: Strojna oprema | 2473 (1992) | Brane2 |