Forum » Strojna oprema » AMD R3xx series

AMD R3xx series

Temo vidijo: vsi

Senitel ::

fr4nc ::

lol

lol

Kaj lol??

Anymal je čisto pravilno napisal: CPU v igrah se testira tako, da čim bolj zmanjšaš resolucijo in s tem odstraniš bottlenech GPUja, ter tako največ obremeniš CPU.

In kaj tisti graf pove? Da AMD lahko izkoristi štiri (4) jedra, več pa ne zna. Nvidija jih zna izkoristiti 6 pri dotičnem benchmarku.

Se pravi AMD deluje bolje od nvidije dokler se pogovarjamo on najpogostejšem CPU.

Očitno res. Ima kdo podatek kakšen je delež 4 jedernih procesorjev? Glede na to, da ima Intel večino trga potem mora biti verjetno trenutno vsaj 40% 4 jedrnikov...ali pač?

Lp

"Rad pomagam, če je le možno" by Fr4nc; blog(2): http://cpuwars.wordpress.com/

"I just love to share the truth!!" by Fr4nc; http://intelvsamd.wordpress.com/

"I just love to share the truth!!" by Fr4nc; http://intelvsamd.wordpress.com/

PredatorX ::

Čeprav so nekaj govorili o tem, če hočeš boost moraš dat velik compute taskov...

Mhm... Ker je nemogoče, da en sam task povsem zafila GPU.

In kaj? si moral dododat brezvezen komentar?

V tem je point...

Zgodovina sprememb…

- predlagal izbris: SuperVeloce ()

Senitel ::

In kaj? si moral dododat brezvezen komentar?

V tem je point...

Moj komentar je ravno tolk brezvezen kot tvoj, ker se te itak ne da premaknit do tega, da bi dejansko razmislil preden bluziš (če bi mi to ratal, potem bi bil moj komentar bistveno manj brezvezen kot tvoj).

Odgovori na vprašanje: Zakaj rabiš "velik compute taskov", če hočeš boost?

To implicira, da en kup compute resourcev ni razpoložljivih, če imaš samo en sam samcat compute task. Kar te pripelje v protislovje s tem, da je mnogo ljudi tako na NV kot na AMD karticah že izmerilo peak flopse v dost enostavnih scenarijih z enim samim taskom. Kako jim je to uspelo?

Dejansko stanje je pa tako, da bo boost od izvajanja grafičnih in compute taskov sočasno, prišel samo v primerih, ko imaš en grafičen in en (ali več) compute taskov, ki so med seboj povsem neodvisni in kjer je grafičen task (močno) omejen z deli GPU-ja, ki niso shader array ter je compute task omejen s strani shader arraya (in ničesar drugega). Kar sem napisal že 50 strani nazaj.

PredatorX ::

Heh, govorimo o Async shaderjih.

Bezond3 - Glede na score predvidevam, da je GTX 980 v tistem benchmarku navita (primerjavi z GTX TITAN Xom, ki naj bi bil 50% hitrejši).

Že spet async shaderji potrebujejo hardware. In zakaj sem prej omenil veliko compute taskov? Tako lahko dejansko sabotirajo performance(+ 0-1% z async shaderji).

Pa tudi mislim, da bo NVIDIA z next generation.. ampak oni bodo z gameworksom sabotirali maxwella/keplerja in AMD.

DX12 vs DX11 na NVIDI-JI

Ja vem beta.

Bezond3 - Glede na score predvidevam, da je GTX 980 v tistem benchmarku navita (primerjavi z GTX TITAN Xom, ki naj bi bil 50% hitrejši).

Že spet async shaderji potrebujejo hardware. In zakaj sem prej omenil veliko compute taskov? Tako lahko dejansko sabotirajo performance(+ 0-1% z async shaderji).

Pa tudi mislim, da bo NVIDIA z next generation.. ampak oni bodo z gameworksom sabotirali maxwella/keplerja in AMD.

DX12 vs DX11 na NVIDI-JI

Ja vem beta.

Zgodovina sprememb…

- spremenilo: PredatorX ()

Jst ::

Boriš se z mlini na veter, Senitel.

Jaz ne razumem ljudi, ki niso sposobni spremeniti mišljenja/prepričanja. Jaz sem skeptik po "naravi" in sem svoje mnenje/prepričanje spremenil mnogokrat - kadar mi je bil na voljo nov fakt, pa četudi sem potem moral začeti "misliti drugače", za 180 stopinj.

---

Trolling really is a art...

Jaz ne razumem ljudi, ki niso sposobni spremeniti mišljenja/prepričanja. Jaz sem skeptik po "naravi" in sem svoje mnenje/prepričanje spremenil mnogokrat - kadar mi je bil na voljo nov fakt, pa četudi sem potem moral začeti "misliti drugače", za 180 stopinj.

---

Trolling really is a art...

Islam is not about "I'm right, you're wrong," but "I'm right, you're dead!"

-Wole Soyinka, Literature Nobelist

|-|-|-|-|Proton decay is a tax on existence.|-|-|-|-|

-Wole Soyinka, Literature Nobelist

|-|-|-|-|Proton decay is a tax on existence.|-|-|-|-|

PredatorX ::

Boriš se z mlini na veter, Senitel.

Jaz ne razumem ljudi, ki niso sposobni spremeniti mišljenja/prepričanja. Jaz sem skeptik po "naravi" in sem svoje mnenje/prepričanje spremenil mnogokrat - kadar mi je bil na voljo nov fakt, pa četudi sem potem moral začeti "misliti drugače", za 180 stopinj.

---

Trolling really is a art...

LOL...

Če rečm da jeben maxwell ni sposoben poganjat async shaderjev je pa vse narobe!

Ne, ne se bom popravil.. Maxwell je sposoben furat async shaderje.

On me pa prepričuje, da se definitivno motim ker on lahko fura več...

Zgodovina sprememb…

- predlagal izbris: SuperVeloce ()

Jst ::

Ashes of the Singularity benchmark poudarja samo eno plat zgodbe, medtem, ko je pa Fable Legends prvi AAA prihajajoči dx12 špil (ki bo podpiral tudi dx11). In zelo zelo dvomim, da bodo drugi AAA špili kazali kakšno drugačno sliko.

Saj ti je Senitel lepo razložil, zakaj pri Ashes takšni rezultati.

---

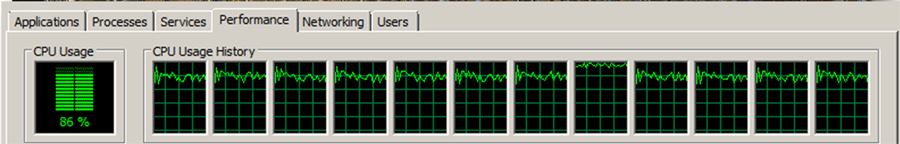

Sicer pa, že v dx11 se pri pravilni rabi da zaposliti 8 jeder CPUja: Civ 5

edit: vir: Guru3D Forums /edit

Ampak glavno, da GPU podpira Asinhrono izvajanje Compute Shaderjev in da ima AMD tu prednost. Ki se bo pa v AAA špilih realno poznala za kakšen odstotek boljše delovanje. Why? Glej Senitelov odgovor zgoraj.

Saj ti je Senitel lepo razložil, zakaj pri Ashes takšni rezultati.

---

Sicer pa, že v dx11 se pri pravilni rabi da zaposliti 8 jeder CPUja: Civ 5

edit: vir: Guru3D Forums /edit

Ampak glavno, da GPU podpira Asinhrono izvajanje Compute Shaderjev in da ima AMD tu prednost. Ki se bo pa v AAA špilih realno poznala za kakšen odstotek boljše delovanje. Why? Glej Senitelov odgovor zgoraj.

Islam is not about "I'm right, you're wrong," but "I'm right, you're dead!"

-Wole Soyinka, Literature Nobelist

|-|-|-|-|Proton decay is a tax on existence.|-|-|-|-|

-Wole Soyinka, Literature Nobelist

|-|-|-|-|Proton decay is a tax on existence.|-|-|-|-|

Zgodovina sprememb…

- spremenil: Jst ()

PredatorX ::

In že spet?

Govorimo o 10-20% boostu mogoče več odvisno od engina/compute taskov.(kar se lahko hitro spremeni v 0-5% boosta)

Dj poglej si ti tole

https://forum.beyond3d.com/threads/dx12...

http://www.extremetech.com/extreme/2135...

Okey, čist priznam, da verjetno v prvih špilih sploh nebo razlike.. pri AMD titlih se zna poznati (že spet govorimo od 10-20% ali celo manj). Govorim pa bolj o razvoju. Čeprav NVIDIA noče nič debate o tem, kako so javno oglašali, da podpirjo async shaderje. Sej jih, ampak ne hardwaresko. Gre se zato, da je GCN bolj napreden.

Fable legends:

Navita GTX 980 povozi Fury X (uporbljali so TAA, kar je v prid nvidi-je - but who cares)

http://www.pcgameshardware.de/DirectX-1...

GTX 960 je na nivoju R9 270X (prav tako je tam tudi GTX 670)

R9 290 gladko povozi GTX 780TI (ampak ni krize)

To je UE4.

Njemu ni treba prav nič mene prepričevat, ker bom ubavil tisto kar bo najbolje in najceneje (NVIDIA/AMD/INTEL). Pa tudi ni me treba prepričevati o tem, kaj je njegov kepler zmožen.. ker očitno async shaderjev nemore poganjat prav tako je GCN zmožen poganjat več threadov.

Govorimo o 10-20% boostu mogoče več odvisno od engina/compute taskov.(kar se lahko hitro spremeni v 0-5% boosta)

Dj poglej si ti tole

https://forum.beyond3d.com/threads/dx12...

http://www.extremetech.com/extreme/2135...

Okey, čist priznam, da verjetno v prvih špilih sploh nebo razlike.. pri AMD titlih se zna poznati (že spet govorimo od 10-20% ali celo manj). Govorim pa bolj o razvoju. Čeprav NVIDIA noče nič debate o tem, kako so javno oglašali, da podpirjo async shaderje. Sej jih, ampak ne hardwaresko. Gre se zato, da je GCN bolj napreden.

Fable legends:

Navita GTX 980 povozi Fury X (uporbljali so TAA, kar je v prid nvidi-je - but who cares)

http://www.pcgameshardware.de/DirectX-1...

GTX 960 je na nivoju R9 270X (prav tako je tam tudi GTX 670)

R9 290 gladko povozi GTX 780TI (ampak ni krize)

To je UE4.

Njemu ni treba prav nič mene prepričevat, ker bom ubavil tisto kar bo najbolje in najceneje (NVIDIA/AMD/INTEL). Pa tudi ni me treba prepričevati o tem, kaj je njegov kepler zmožen.. ker očitno async shaderjev nemore poganjat prav tako je GCN zmožen poganjat več threadov.

Zgodovina sprememb…

- spremenilo: PredatorX ()

Jst ::

>On me pa prepričuje, da se definitivno motim ker on lahko fura več...

Mislim, da je TEBE nehal prepričevati že dolgo časa nazaj. On dejansko pove zakaj&kako, da drugi razumemo in nismo odvisni od fanboy trollinga.

Sam si sicer služim kruh s programiranjem, ampak sem v drugem fohu. Vendar spremljam tehnologijo tudi na GPU področju*. Senitel je bil tako dober, da mi je odgovoril že na več specifičnih vprašanj in enkrat celo z samim konceptom (rasterizacija vs. raytracing).

*in se pospešeno zavedam, da se moram naučiti programiranja za GPU, če hočem ostati konkurenčen na trgu.

Mislim, da je TEBE nehal prepričevati že dolgo časa nazaj. On dejansko pove zakaj&kako, da drugi razumemo in nismo odvisni od fanboy trollinga.

Sam si sicer služim kruh s programiranjem, ampak sem v drugem fohu. Vendar spremljam tehnologijo tudi na GPU področju*. Senitel je bil tako dober, da mi je odgovoril že na več specifičnih vprašanj in enkrat celo z samim konceptom (rasterizacija vs. raytracing).

*in se pospešeno zavedam, da se moram naučiti programiranja za GPU, če hočem ostati konkurenčen na trgu.

Islam is not about "I'm right, you're wrong," but "I'm right, you're dead!"

-Wole Soyinka, Literature Nobelist

|-|-|-|-|Proton decay is a tax on existence.|-|-|-|-|

-Wole Soyinka, Literature Nobelist

|-|-|-|-|Proton decay is a tax on existence.|-|-|-|-|

PredatorX ::

Lol debata je o tem, da jaz pravim da se bo v future uporabljalo async shaderje.

Molnar pa je tudi omenil samo maxell vs GCN in pokazal samo tisti test, ki je njemu všeč.

Ostali DX12 featurees bodo tudi prišle zelo prav stem se strinjam. Ampak, do tj je šše dolga pot kakor verjetno tudi za async shaderje.

Molnar pa je tudi omenil samo maxell vs GCN in pokazal samo tisti test, ki je njemu všeč.

Ostali DX12 featurees bodo tudi prišle zelo prav stem se strinjam. Ampak, do tj je šše dolga pot kakor verjetno tudi za async shaderje.

Zgodovina sprememb…

- spremenilo: PredatorX ()

Jst ::

>Njemu ni treba prav nič mene prepričevat, ker bom ubavil tisto kar bo najbolje in najceneje (NVIDIA/AMD/INTEL).

Glede na tvoja izvajanja v tej temi, dvomim. Ali pa boš kupil "tisto kar bo najbolje in najceneje" vendar samo za tebe in nekaj ostalih fanboyev. Jaz sem imel od Voodooja 1 in 3, mnogo AMD in Nvidia kartic (za gaming, za laptop jih sploh nočem videti noter). Pogledam benchmarke, preberem review (Guru3D me ni "nategnil" že 15 let, Anand se pa malo bolj v tehniko spusti, oba pa imata praktično enake rezultate) in potem kupim. Koliko kartic sem imel, pa sem jih pohvalil tam, kjer so si pohavlo zaslužili in skurcal tam, kjer so ga najbolj srali...

---

>Lol debata je o tem, da jaz pravim da se bo v future uporabljalo async shaderje.

Ja, in kaj misliš, da bodo async shaderji poskrbeli za vse? Daj no, poglej si, kako izgleda pipeline grafične kartice in mogoče, res mogoče, boš zastopil, da je to samo en mali delček zgodbe. Pri AAA špilih, kot so strategije, dober kandidat je tudi recimo FIFA, da, tam bo uporaba večja, pri First Person Shooterjih pa razlike ne bo - se jih ne bo uporabljalo v takšni meri, da bi se poznalo več kot kakšen odstotek.

Glede na tvoja izvajanja v tej temi, dvomim. Ali pa boš kupil "tisto kar bo najbolje in najceneje" vendar samo za tebe in nekaj ostalih fanboyev. Jaz sem imel od Voodooja 1 in 3, mnogo AMD in Nvidia kartic (za gaming, za laptop jih sploh nočem videti noter). Pogledam benchmarke, preberem review (Guru3D me ni "nategnil" že 15 let, Anand se pa malo bolj v tehniko spusti, oba pa imata praktično enake rezultate) in potem kupim. Koliko kartic sem imel, pa sem jih pohvalil tam, kjer so si pohavlo zaslužili in skurcal tam, kjer so ga najbolj srali...

---

>Lol debata je o tem, da jaz pravim da se bo v future uporabljalo async shaderje.

Ja, in kaj misliš, da bodo async shaderji poskrbeli za vse? Daj no, poglej si, kako izgleda pipeline grafične kartice in mogoče, res mogoče, boš zastopil, da je to samo en mali delček zgodbe. Pri AAA špilih, kot so strategije, dober kandidat je tudi recimo FIFA, da, tam bo uporaba večja, pri First Person Shooterjih pa razlike ne bo - se jih ne bo uporabljalo v takšni meri, da bi se poznalo več kot kakšen odstotek.

Islam is not about "I'm right, you're wrong," but "I'm right, you're dead!"

-Wole Soyinka, Literature Nobelist

|-|-|-|-|Proton decay is a tax on existence.|-|-|-|-|

-Wole Soyinka, Literature Nobelist

|-|-|-|-|Proton decay is a tax on existence.|-|-|-|-|

Zgodovina sprememb…

- spremenil: Jst ()

Senitel ::

Ampak glavno, da GPU podpira Asinhrono izvajanje Compute Shaderjev in da ima AMD tu prednost.

Tukaj je še dejstvo, da je "async shader" najbolj neposrečen izraz zadnjih nekaj let. Če nekaj teče asinhrono to niti približno ne implicira, da teče sočasno s čimer koli.

Če rečm da jeben maxwell ni sposoben poganjat async shaderjev je pa vse narobe!

Ne, ne se bom popravil.. Maxwell je sposoben furat async shaderje.

Who gives a fuck, če je Maxwell sposoben poganjat grafiko in compute sočasno...

Ti v vsakem postu v tej temi bluziš kako so ti "async shaderji" najboljša stvar po narezanem kruhu. Ti nakej sanjaš kako ti "async shaderji" odklenejo neke skrivne rezerve.

In konec dneva ti vlečeš sem not kako AotS uporablja "async shaderje", ker je boost iz DX11 na DX12 v primeru AMD kartic in kako Fable Legends ne uporablja "async shaderjev", ker so GeForce-i hitrejši od Radeon-ov. Ker tega nismo videli v nobeni DX11 igri ane in je v vsaki DX11 igri GeForce hitrejši od ekvivalentnega Radeon-a.

In fino, da si linkal debato iz Beyond3D. Škoda samo, da je sploh nisi zastopil, ali vsaj prebral komplet (in na žalost se je tudi tam not našlo en kup idiotov).

PredatorX ::

Jah res je težko, če kupiš AMD grafično in pač poveš folku, da je zelo dobra izbira in celo boljša od NVIDI-je pa vse narobe. GCn je pač bolj napreden za DX12...

Sestavil sem že kar nekaj PC-jev, čeprav bi rad mal več bitke AMD vs INTEL (CPU) vedno priporočam i5.. če je slučajno budget brez OC-ja pa sisnem kakšnega athlona x4 z GTX 750/TI/R7 260X. Ravno nekaj časa nazaj sem nekomu sestavil AThlon x4 860K + GTX 750TI (rabljeno za 85€) in mislim, da je zelo dober build.

No, čeprav pa lahko rečem, da večina folka hoče met NVIDIA grafično. Tako, da kupim pač tisto kar zahtevajo imet.

@ Senitel

AotS - ni ravno nek big deal glede async shaderjev. Ker je tud developer omenil, da... no če bi prebral bi vedel.

Glee fable legends - je pa v UE4. Async shaderji pa verjetno nekih velikih sprememb v UE4 nebodo naredili.

Mislim pa, da je lahko velika razlika uporabe async shaderjev v VR špilih.

Sestavil sem že kar nekaj PC-jev, čeprav bi rad mal več bitke AMD vs INTEL (CPU) vedno priporočam i5.. če je slučajno budget brez OC-ja pa sisnem kakšnega athlona x4 z GTX 750/TI/R7 260X. Ravno nekaj časa nazaj sem nekomu sestavil AThlon x4 860K + GTX 750TI (rabljeno za 85€) in mislim, da je zelo dober build.

No, čeprav pa lahko rečem, da večina folka hoče met NVIDIA grafično. Tako, da kupim pač tisto kar zahtevajo imet.

@ Senitel

AotS - ni ravno nek big deal glede async shaderjev. Ker je tud developer omenil, da... no če bi prebral bi vedel.

Glee fable legends - je pa v UE4. Async shaderji pa verjetno nekih velikih sprememb v UE4 nebodo naredili.

Mislim pa, da je lahko velika razlika uporabe async shaderjev v VR špilih.

Senitel ::

GCn je pač bolj napreden za DX12...

Bolj napreden, ker lahko sočasno poganja compute in grafiko? To je nekaj kar je prišlo povsem transparentno zraven. In čeprav GCN 1.0 sploh ni feature level 12_0.

Mislim pa, da je lahko velika razlika uporabe async shaderjev v VR špilih.

Itak, gremo še več stvari, ki nimajo veze zmešat zraven. VR nima nobene veze z "async shaderji".

Za VR bo pomembno, kako hitro lahko GPU prekine en grafičen command stream (renderiranje naslednje slike) z drugim grafičnim command stream-om (ki bo prestavil pogled). V VR svetu se bo vsak frame (za vsako oko posebej) zrenderiral v višji ločljivosti, kot ga bodo VR očala prikazala. Point tega je, da ob premiku glave ne bo potrebno čakat na naslednji frame, ampak se bo samo spremenil zorni kot na ta večji, že renderiran frame.

Ja, NV je jasno povedala, da lahko grafičen command stream prekinejo samo na draw mejah. V tistih 16ms, kolikor traja rendering enega frame-a pri 60fps, je lahko stisnjenih tudi bistveno več kot 10000 draw ukazov. Problem je samo v primerih, ko bi teh draw ukazov bilo dejansko zelo malo.

AMD dejansko ni povedal kako pogosto lahko delajo preemption. Glede na to, da developerji pravijo, da boljše kot NV, to pomeni ali premption na nivoju posameznih trikotnikov ali nekaj v tej smeri.

Jst ::

Senitel. Pri meni imaš stopnjo zaupanja korektnosti/natančnosti/pravilnosti ene 90%. (I'm a skeptic, remember).

V zadnjem postu si potrdil moje predevanje/razmišljanje o VR. Hvala.

Ali mi lahko odgovoriš na naslednje vprašanje: Če uporabim eno (1) (compute) komando za GPU (OK, mogoče je potrebnih 4 ali sedem), lahko brez posredovanja CPUja, zaposlim GPU na 90%+? Vseeno ali AMD ali Nvidija (ali Intel).

?

edit: Zaposlim Compute enote na 90+%? Teksturne in ostale enote bodo seveda brez dela v tem primeru.

V zadnjem postu si potrdil moje predevanje/razmišljanje o VR. Hvala.

Ali mi lahko odgovoriš na naslednje vprašanje: Če uporabim eno (1) (compute) komando za GPU (OK, mogoče je potrebnih 4 ali sedem), lahko brez posredovanja CPUja, zaposlim GPU na 90%+? Vseeno ali AMD ali Nvidija (ali Intel).

?

edit: Zaposlim Compute enote na 90+%? Teksturne in ostale enote bodo seveda brez dela v tem primeru.

Islam is not about "I'm right, you're wrong," but "I'm right, you're dead!"

-Wole Soyinka, Literature Nobelist

|-|-|-|-|Proton decay is a tax on existence.|-|-|-|-|

-Wole Soyinka, Literature Nobelist

|-|-|-|-|Proton decay is a tax on existence.|-|-|-|-|

Zgodovina sprememb…

- spremenil: Jst ()

Napajalc ::

Point tega je, da ob premiku glave ne bo potrebno čakat na naslednji frame, ampak se bo samo spremenil zorni kot na ta večji, že renderiran frame.

Zakaj je sploh potrebno filat gap s "staro" sliko? Švoh hardware?

011011100111010101100010

Zgodovina sprememb…

- spremenilo: Napajalc ()

Truga ::

Point tega je, da ob premiku glave ne bo potrebno čakat na naslednji frame, ampak se bo samo spremenil zorni kot na ta večji, že renderiran frame.

Zakaj je sploh potrebno filat gap s "staro" sliko? Švoh hardware?

Ker so graficne pocasne in rabijo vec kot 0 milisekund, da zrisejo sliko.

Napajalc ::

Recmo 2k resolucija na oko, torej se rabi grafična kartica ki je v stanju pelat 4k na 120 Hz. To kar kliče po namenski zadevi dokler klasične grafične kartice ne prerastejo 4k.

011011100111010101100010

destroyer2k ::

GenZNPC ::

Mantle je tut bil v khm, kr nekaj špilih... 8 ? AMD pa ga pogrne v več kot 8 drugih... jebat ga.

In dejansko potem vidiš, da je dx12 performance amdja na nivoju zrelega dx11 nvidije, ki se ne preveč obremenjuje z dx12 enkrat, ker bo 11 še nekaj časa v igri oz. bo 11on12 layer

O dx12 se bo zanimivo sekirat šele konec naslednjega leta.

In dejansko potem vidiš, da je dx12 performance amdja na nivoju zrelega dx11 nvidije, ki se ne preveč obremenjuje z dx12 enkrat, ker bo 11 še nekaj časa v igri oz. bo 11on12 layer

O dx12 se bo zanimivo sekirat šele konec naslednjega leta.

skibidi

Zgodovina sprememb…

- spremenil: GenZNPC ()

Senitel ::

Ali mi lahko odgovoriš na naslednje vprašanje: Če uporabim eno (1) (compute) komando za GPU (OK, mogoče je potrebnih 4 ali sedem), lahko brez posredovanja CPUja, zaposlim GPU na 90%+? Vseeno ali AMD ali Nvidija (ali Intel).

?

edit: Zaposlim Compute enote na 90+%? Teksturne in ostale enote bodo seveda brez dela v tem primeru.

Seveda lahko (in zakaj se omejit na 90%?). Če imaš kernel s 16384 threadi to zaposli Fury X 100%. 14080 threadov zaposli 980 Ti. V NV primeru zna bit številka višja, ker nimajo vsi ukazi istih latenc. In tudi compute lahko zasede teksturirne enote.

Senitel ::

Večino aritmetičnih inštrukcij na GCN ima latenco 4 cikle. Fury X ima 4096 ALU-jev, torej 4096 * 4, da so ti ALU-ji busy. Maxwell je malo bolj kompliciran, ker nimajo vse inštrukcije enakih latenc. Seštevanje in množenje imata 5 ciklov, torej pri 980 Ti 2816 * 5.

Se pa stvari dodatno zakomplicirajo, ko pridejo zraven takšni in drugačni dostopi v ram (kar ima letance ranga 100 ciklov in več) ali pa inštrukcije ala rsqrt.

Se pa stvari dodatno zakomplicirajo, ko pridejo zraven takšni in drugačni dostopi v ram (kar ima letance ranga 100 ciklov in več) ali pa inštrukcije ala rsqrt.

PredatorX ::

Večino aritmetičnih inštrukcij na GCN ima latenco 4 cikle. Fury X ima 4096 ALU-jev, torej 4096 * 4, da so ti ALU-ji busy. Maxwell je malo bolj kompliciran, ker nimajo vse inštrukcije enakih latenc. Seštevanje in množenje imata 5 ciklov, torej pri 980 Ti 2816 * 5.

Se pa stvari dodatno zakomplicirajo, ko pridejo zraven takšni in drugačni dostopi v ram (kar ima letance ranga 100 ciklov in več) ali pa inštrukcije ala rsqrt.

Aha,

glede bandiwdtha.

GCN ma 64 bytes per cycle of L1/L2 bandwidth

Navišji (peak) scalar L1 data cache bandwidth per CU je 16 bytes per cycle.

LDS peak je pa 128bytes...

R9 290X 5,5TB/s za LDS BW; 2,8 TB/s za L1 BW; 1 TB/s za L2.. 4/8GB GDDR5 pa 320GB/s. Ja šteti bi bilo še treba BW efficiency.

each CU lahko poganja 2560 threadov

2560*64 = 163,840 tolk jih lahko poganja Fury X

Lahko GTX 980Ti poganja vsaj polovico toliko threads-ov?

Zgodovina sprememb…

- spremenilo: PredatorX ()

Truga ::

Se pa stvari dodatno zakomplicirajo, ko pridejo zraven takšni in drugačni dostopi v ram (kar ima letance ranga 100 ciklov in več)

No, v igrah vecinoma probas pre-fetchat iz rama ze prej, ker naceloma ves kaj bos izrisoval. Zato se tudi visoke latence na GPU ramu ne smatrajo kot velik problem. Ja, latenca je boljsa nizja, ampak ce imas izbiro bandwidth ali latenca bos vzel bandwidth.

Me pa zanima, kako bo to HBM spremenil? So tam latence nizje?

D3m0r4l1z3d ::

Mah, na koncu je ssmo optimizacija za posamezno igro pomembna, Dying Light na 720p s 290x ne teče gladko, vse na high razen spceifika od nvidie na off

ETN Wallet addr.: etnkGuvhDzR7Dh8us4e69VStubGbmQHrh5pe2fnpNDhEhX5

A1nCWrFBMK2NmkycgVN4sAwhvY8YyNNbF6KUSJyFZ99QKU8phCn

Cryptopia ref. link: https://www.cryptopia.co.nz/Register?referrer=Anymalus

A1nCWrFBMK2NmkycgVN4sAwhvY8YyNNbF6KUSJyFZ99QKU8phCn

Cryptopia ref. link: https://www.cryptopia.co.nz/Register?referrer=Anymalus

Napajalc ::

Any, nekaj fino narobe delaš, 1080p hi setings (max view range) razen nVidia stuff teče na r9 290x pri 1050/1400mhz na 60 HZ vsync ON BP na CPU i5 4x2500mhz. Se glih igram snemanje + monitoring + da ne pokavari vsyn ON, mogoče naredim posnetek.

011011100111010101100010

Zgodovina sprememb…

- spremenilo: Napajalc ()

D3m0r4l1z3d ::

Sem prebral na netu, da max distance zjebe performance, bom probal potem doma, mogoče pa nimam popravka najnovejšega

ETN Wallet addr.: etnkGuvhDzR7Dh8us4e69VStubGbmQHrh5pe2fnpNDhEhX5

A1nCWrFBMK2NmkycgVN4sAwhvY8YyNNbF6KUSJyFZ99QKU8phCn

Cryptopia ref. link: https://www.cryptopia.co.nz/Register?referrer=Anymalus

A1nCWrFBMK2NmkycgVN4sAwhvY8YyNNbF6KUSJyFZ99QKU8phCn

Cryptopia ref. link: https://www.cryptopia.co.nz/Register?referrer=Anymalus

Senitel ::

Večja latenca pomeni bolje v tem primiru?

Večja latenca pomeni, da rabiš več threadov, da lahko GPU polno zasedeš.

No, v igrah vecinoma probas pre-fetchat iz rama ze prej, ker naceloma ves kaj bos izrisoval. Zato se tudi visoke latence na GPU ramu ne smatrajo kot velik problem. Ja, latenca je boljsa nizja, ampak ce imas izbiro bandwidth ali latenca bos vzel bandwidth.

Me pa zanima, kako bo to HBM spremenil? So tam latence nizje?

Pre-fetch kako in kam? V principu (*) za vsak draw ukaz GPU sicer ve, katere teksture bodo uporabljene. 4096x4096 32bit tekstura ja 64MB kam boš to spravil (in lahko je v igri več tekstur)?

(*) V principu zato, ker lahko danes tudi to katera tekstura bo uporabljena shader izračuna sam, ali prebere nekje iz neke druge "teksture" za vsak pixel posebej.

Ne. Warp/wavefront nabaše na 32/64 pixlov/threadov, ki hočejo teksturirat. Teh 32/64 texture fetchev se preda naprej TMU-jem, kar bo trajalo več kot en cikel (8 TMU/SMM za Maxwell, 4 TMU/CU za GCN). Ko ta warp/wavefront spravi skoz vseh 32/64 texture fetchev, ga scheduler enostavno ne bo zbudil dokler TMU-ji ne dostavijo željenih podatkov v regsiter file. Obdelava se premakne na naslednji warp/wavefront, oziroma na naslednjo grupo pixlov/threadov.

RAM tudi ni edini vir latence. Podatki potujejo skozi TMU-je (texture filtering) kar doda latenco.

each CU lahko poganja 2560 threadov

2560*64 = 163,840 tolk jih lahko poganja Fury X

Lahko GTX 980Ti poganja vsaj polovico toliko threads-ov?

Ne more in ne rabi. 980 Ti lahko drži 45056 threadov. 980 Ti ima 22 SMM-ov, vsak SMM lahko drži 64 warpov (22 * 64 * 32). Fury X ima 64 CU-jev, vsak CU lahko drži 40 wavefront-ov (64 * 40 * 64).

SMM torej skriva latenco za 64 warpi, GCN pa za 40 wavefront-i.

SuperVeloce ::

ups. Cooler master je pogrnil v USA. Upajmo, da ni to problem za AMD

ryzen 5900x, MSI 5700xt Gaming X, 2x16GB 3600CL16, 850evo+860qvo, Fractal Mini C

AapocalypseE ::

Vsi pa znajo samo kazat avg. fps

Kaj mi pomaga, če mam višji avg., če je min. nižji.

Kaj mi pomaga, če mam višji avg., če je min. nižji.

Napajalc ::

Fino bi blo da bi imeli posnetke s kamero, wattmeter zraven, najpogostejše CPU, nastavitve v igri da se vrti na 60 FPS. Ogromno dela, samo to bi blo to.

Mogoče bi šlo brez wattmetra in kamere, če bi imeli "afterburner" ki bi skoču iz ozadja direkt čez igro ko bi pritisnu neko tipko. Na ta način bi lahko vsi delal kredibilne posnetke.

Mogoče bi šlo brez wattmetra in kamere, če bi imeli "afterburner" ki bi skoču iz ozadja direkt čez igro ko bi pritisnu neko tipko. Na ta način bi lahko vsi delal kredibilne posnetke.

011011100111010101100010

GenZNPC ::

To je zdej tko, imaš na izbiro:

1fps razlike v minimum - - na vsake par minut za sekundo (vzrok je lahko tudi cpu, driver) 1% of the time

ali pa

15 fps manj 99% of the time

oz.

en poseben efekt manj forever

1fps razlike v minimum - - na vsake par minut za sekundo (vzrok je lahko tudi cpu, driver) 1% of the time

ali pa

15 fps manj 99% of the time

oz.

en poseben efekt manj forever

skibidi

Napajalc ::

Zate NO1 poraba, zame NO1 lomljenje slike, ne moreš mimo te nastavitve. Polahko se boš moral adaptirat na nizko porabo če že govoriš o tem.

011011100111010101100010

GenZNPC ::

Zate NO1 poraba, zame NO1 lomljenje slike, ne moreš mimo te nastavitve. Polahko se boš moral adaptirat na nizko porabo če že govoriš o tem.

Jaz mam oboje zaenkrat in se ne sekiram, tu je še tišina brez vode in še kak efekt vklopljen, ki ga ti žal ne-moreš, ker padeš pod 60.

Aja pa tiste igre, ki jih jaz igram delujejo muchos grande bolje...

GVR si že probal ?

skibidi

Zgodovina sprememb…

- spremenil: GenZNPC ()

Napajalc ::

Poraba in glasnost gre doli z vsync ON, kjub temu da v tvojmu primeru zategneš powerlimit, da ti neha trotlat takrat ko ne sme (dropi).

011011100111010101100010

GenZNPC ::

Pri men glasnost ne gre pod 25db

Osebne izkušnje? ker res nevem o kakšnih problemih govoriš

Poraba in glasnost gre doli z vsync ON, kjub temu da v tvojmu primeru zategneš powerlimit, da ti neha trotlat takrat ko ne sme (dropi).

Osebne izkušnje? ker res nevem o kakšnih problemih govoriš

skibidi

Zgodovina sprememb…

- spremenil: GenZNPC ()

GenZNPC ::

Nope res nevem... Zadeva dela že od prvega dne končanega testiranja, bolje kot pričakovano.

Ni potrebe po "iskanju" popolnih nastavitev in 2 leti testiranja, kot pr rdečih.

Ni potrebe po "iskanju" popolnih nastavitev in 2 leti testiranja, kot pr rdečih.

skibidi

Napajalc ::

Ne projeciraj tvoje nesposobnosti na AMD.

011011100111010101100010

Zgodovina sprememb…

- predlagal izbris: SuperVeloce ()

GenZNPC ::

Žal je res, za ATi moraš bit doktor znanosti (aka Napajalc) in imeti dovolj časa za testiranje (dokazovati nasprotje tople vode), ter laboratorij, da čez nekaj časa dela kot si človk želi...

Pač posledica polizdelkov, kot kitajske bormašine. Lej sej vem, če bi ti dal vsaj 500EUR za 290 in bil brez vode .... nebi bi zdal tukaj glasen.

Pač posledica polizdelkov, kot kitajske bormašine. Lej sej vem, če bi ti dal vsaj 500EUR za 290 in bil brez vode .... nebi bi zdal tukaj glasen.

skibidi

Zgodovina sprememb…

- spremenil: GenZNPC ()

Napajalc ::

Hočeš rečt da se izogibaš vsynca zaradi polizdelka ki dejansko ne dela na 160w. Drgač Vsync obstaja že zelo dolgo, čudno da nisi uspel pogruntat do sedaj kaj zmore ta nastavitev.

011011100111010101100010

SuperVeloce ::

Torej bomo nižali nastavitve, zato da so razpoložljivi fps vedno in povsod >60, potem vključili vsync, zato da grafika skoraj nikoli ni 100% izkoriščena... samo da bo tebi voda na mlin tekla?

ryzen 5900x, MSI 5700xt Gaming X, 2x16GB 3600CL16, 850evo+860qvo, Fractal Mini C

GenZNPC ::

Z v-sync je še manjša, kot uradno specificirana... Nekatere igre se pa ne igra z v-sync, samo ti itak neveš k si vajen 200ms

Tripple buffering so pa naredili za koga?

Tripple buffering so pa naredili za koga?

skibidi