Forum » Strojna oprema » AMD Vega GPU

AMD Vega GPU

Temo vidijo: vsi

Napajalc ::

Si ne predstavljam nvidijo z povečanimi TFLOPSi, to bi šlo nekako tako, 2 uri igranja, - (minus) 22 ur mininga, - prepočasno staranje, - pcb z večjim številom povezav zavoljo zmogljivejšega rama, - povečan napajalni del zavoljo večje porabe, - hitrejši ram.... ne, se jim enostavno nebi sešlo, bolje da pustijo tole AMD ki zna s tem hendlat za ceno 1x hdmi 2.0 priključka.

011011100111010101100010

D3m0r4l1z3d ::

meh, pa te teoretične hitrosti

ETN Wallet addr.: etnkGuvhDzR7Dh8us4e69VStubGbmQHrh5pe2fnpNDhEhX5

A1nCWrFBMK2NmkycgVN4sAwhvY8YyNNbF6KUSJyFZ99QKU8phCn

Cryptopia ref. link: https://www.cryptopia.co.nz/Register?referrer=Anymalus

A1nCWrFBMK2NmkycgVN4sAwhvY8YyNNbF6KUSJyFZ99QKU8phCn

Cryptopia ref. link: https://www.cryptopia.co.nz/Register?referrer=Anymalus

M1tj4 ::

Moje skromno mnenje o cenah: Nvidia je postavila (zakaj in kako niti ni pomembno) neko ceno, na primer 250$ za GTX1060 (6GB) in 400$ za GTX1070. AMD je naredil rx480 (8GB) in ji je lahko dal samo eno ceno - 240$, ker je performačno zelo blizu 1060. Če bi bila konkurenčna 1070 pa pač cena blizu te. Ta Vega, če bo (baje) performančno kakih 10% boljša od trenutne 1080 bo sigurno dražja od slednje, s časom mogoče simbolično cenejša. Če bo pocenila Nvidia bo seveda tudi AMD. Seveda cene obstoječih GTX ne bodo več dosti padle. Bodo pa prišli novo modeli.

Isto je v primerjavi z Intelom. Intel ima ceno za nek i7 4c/8t procesor 300$, če AMD izda procesor s podobnim IPC in 6c/12t bo stal vsaj 400$. Če bo IPC občutno slabši pa res pod 300$. Intel in Nvidia postavljata cene. Res je tudi, da bi bile še višje, če ne bi bilo konkurence AMDja. Še bolj pa je res, da te visoke cene pašejo tudi AMDju :)

Glede superiornosti AMDja v DX12: Zakaj je potem GTX1060 v Tomb Rider hitrejša od RX480?

Isto je v primerjavi z Intelom. Intel ima ceno za nek i7 4c/8t procesor 300$, če AMD izda procesor s podobnim IPC in 6c/12t bo stal vsaj 400$. Če bo IPC občutno slabši pa res pod 300$. Intel in Nvidia postavljata cene. Res je tudi, da bi bile še višje, če ne bi bilo konkurence AMDja. Še bolj pa je res, da te visoke cene pašejo tudi AMDju :)

Glede superiornosti AMDja v DX12: Zakaj je potem GTX1060 v Tomb Rider hitrejša od RX480?

D3m ::

Mešaš izdaje.

RX 480 je bila pred 1060, s katero je nvidia hitela zaradi pokritje segmenta.

RX 480 je bila pred 1060, s katero je nvidia hitela zaradi pokritje segmenta.

|HP EliteBook|R7 8840U|

Zgodovina sprememb…

- spremenil: D3m ()

Napajalc ::

AMD je postavil rx 480 za 199$ ko še ni bilo znanega nič o gtx 1060, potem ko je bilo znano kaj bo gtx 1060 so šle cene AMD v višave, in custom gtx 1060 si dobil za ceno referenčnega modela. Tako da AMD je zamenjal r9 380x z rx480 brez da bi dvigoval cene, torej ekvivalent bi bil če bi nvidija zamenjala gtx 970 za gtx 1070, sevda za isto ceno.

011011100111010101100010

M1tj4 ::

Torej je amd dvignil ceno iz 199 na 240, ker se je 1060 ustalila pri 250? O tem govorim, cene postavlja Nvidia.

Samo sem hotel povedati, da Vega ne bo stala 320$, da ne sanjate.

Samo sem hotel povedati, da Vega ne bo stala 320$, da ne sanjate.

Zgodovina sprememb…

- spremenil: M1tj4 ()

Jst ::

Če ima igra oboje, in DX11 in DX12 kodo, potem bi ob pravilni implementaciji morala biti DX12 koda hitrejša oz. pri enakih fpsih z več detajli v 3D prostoru v primerjavi z DX11 kodo. Če to ni, potem v tisti igri DX12 ni pravilno implementiran. Low overhead, asinhrono računanje in pravi multi-core način delovanja pogona igre potegne to (več fps oz. višji fidelity) za seboj.

To sploh ni tako evidentno jasno in enostavno, kot si napisal. Če ima igra enako "grafično lepoto" v DX11 in DX12, in če ni CPU bottleneck, in če igra izrisuje enako FPSjev, bo CPU v primeru DX12 manj obremenjen. Ne moreš pa zaradi manjše obremenitve CPUja, več dela naložiti GPUju, če je ta že prej bil 100% zaseden. Ampak ni pa tudi to čisto res. Naj Senitel pove zakaj, jaz se z GPUji ne ukvarjam...

Islam is not about "I'm right, you're wrong," but "I'm right, you're dead!"

-Wole Soyinka, Literature Nobelist

|-|-|-|-|Proton decay is a tax on existence.|-|-|-|-|

-Wole Soyinka, Literature Nobelist

|-|-|-|-|Proton decay is a tax on existence.|-|-|-|-|

Predator X ::

-Razloži nam zakaj je nvidija izdala 2 seriji gpu ki ne profitirata nič z dx12

Ker je AMD preslaba konkurenca.

In za dva pa pol spila z defektnim dx12 ni interesa.

DX11 ima se vedno monopol.

Vprašanje njegovega visočanstva je jasno kretensko. Ampak tudi ti sekaš mimo. Zakaj bi bila ena in ista igra z enim in istim contentom hitrejša v DX12 kot DX11? Slučajno kakšna igra rine v območje, kjer je dejansko kakšna korist od low CPU overhead API-ja? Ja ena porine nos malenkost v to smer.

Misliš, da bo z Volto kaj drugače? Ves ta bullshit okrog DX12 izvira iz dejstva, da v splošnem folku ni niti minimalno jasno od kje performančne razlike med DX11 in DX12 sploh pridejo.

Iz tegale recimo (februar 2015) se še vedno vleče povsem napačne zaključke.

Ali pa (september 2011):

Tudi nobenemu ne potegne.

Pa kaj ti je graf tolk pomemben?

Če slučajn hočš povedat, da ni potrebe po low lvl APIju za PC platformo. Ja, AMD ma malce večjo srečo, ker XBOX One scorpio (tud PS4 Pro ima amd arch) uporablja DX12 (zdej pride scorpio brez edrama).

Če pa misliš, povedat, da je DX11 dovolj dober in se ga da dobro optimiziran - enostavno se motiš. Tud nvidia bo laufala lepš na DX12ki.

Jst ::

Če pa misliš, povedat, da je DX11 dovolj dober in se ga da dobro optimiziran - enostavno se motiš. Tud nvidia bo laufala lepš na DX12ki.

Prosim odgovori mi tole:

Zakaj sploh obstajajo knjižnice, kot so DirectX, OpenGL, OpenAL?

Islam is not about "I'm right, you're wrong," but "I'm right, you're dead!"

-Wole Soyinka, Literature Nobelist

|-|-|-|-|Proton decay is a tax on existence.|-|-|-|-|

-Wole Soyinka, Literature Nobelist

|-|-|-|-|Proton decay is a tax on existence.|-|-|-|-|

Predator X ::

Če pa misliš, povedat, da je DX11 dovolj dober in se ga da dobro optimiziran - enostavno se motiš. Tud nvidia bo laufala lepš na DX12ki.

Prosim odgovori mi tole:

Zakaj sploh obstajajo knjižnice, kot so DirectX, OpenGL, OpenAL?

Dobr zdej že spet v eno skrajnost. DX12 je boljši od DX11 in to je to.

D3m0r4l1z3d ::

Res je.

Me je zmedel z ceno za 4GB različico.

Sure.

Mešaš izdaje.

RX 480 je bila pred 1060, s katero je nvidia hitela zaradi pokritje segmenta.

Verjetno bo tudi s gp102 hitela, ko Vega izzide.

ETN Wallet addr.: etnkGuvhDzR7Dh8us4e69VStubGbmQHrh5pe2fnpNDhEhX5

A1nCWrFBMK2NmkycgVN4sAwhvY8YyNNbF6KUSJyFZ99QKU8phCn

Cryptopia ref. link: https://www.cryptopia.co.nz/Register?referrer=Anymalus

A1nCWrFBMK2NmkycgVN4sAwhvY8YyNNbF6KUSJyFZ99QKU8phCn

Cryptopia ref. link: https://www.cryptopia.co.nz/Register?referrer=Anymalus

Zgodovina sprememb…

- spremenilo: D3m0r4l1z3d ()

Senitel ::

Me ima pognat na 680 z enimi starejšimi driverji in zadnjimi (ajde dam še R9 380X zraven). Tko da pokažem kaj se je glede tega zgodilo pri NV tam enkrat začetek 2015... Naslednji vikend.

Sem se spomnil, da bi za ta test dejansko moral postavit kišto z Win 7, kar je pa bistveno več časa kot sem ga pripravljen vložit v tole.

Je pa stanje danes takole:

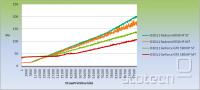

Torej iz 2x razlike leta 2011 smo prišli na 4x razliko leta 2017. Zelo lepo se vidi kje rata na kateri grafi problem DX (kje se graf prelomi). In kako zabavno se R9 390X obnaša v multi threading scenariju (ki ga ATI/AMD ni nikoli implementiral). 100k Draw klicev: playable na NV (100FPS), unplayable na AMD (25FPS).

Edini špil, ki gre v to smer je Ashes of the Singularity (in je zlo na meji igrabilnosti v DX11 na AMD grafah).

Tudi ti sekaš mimo. Če ima igra oboje, in DX11 in DX12 kodo, potem bi ob pravilni implementaciji morala biti DX12 koda hitrejša oz. pri enakih fpsih z več detajli v 3D prostoru v primerjavi z DX11 kodo. Če to ni, potem v tisti igri DX12 ni pravilno implementiran. Low overhead, asinhrono računanje in pravi multi-core način delovanja pogona igre potegne to (več fps oz. višji fidelity) za seboj.

Glej... Kaj naj ti rečem? Kot prvo zakaj misliš, da je tvoje razumevanje na nivoju, da se boš šel o tem bockat recimo z NV inžinirjem?

Kot drugo: low overhead in multi threading niti najmanj ne zmanjšata dela na GPU-ju. Igre so primarno omejene s strani GPU-ja. Če nebi bile, potem bi dal v kišto najprej 280X in potem Fury X in bi imel v obeh primerih identično izkušnjo. "Async compute" pomaga pri izkoriščenosti GPU-ja v nekaterih primerih. Ne rabiš pa niti približno DX12, da prideš do tega (NV na Pascalih dela to tudi v DX11, AMD sklepam da ne; preverjal pa za forumske trolle ne bom).

Če frame rabi 16ms na GPU in 10ms na CPU v DX11 in bo v DX12 rabil 16ms na GPU in 1ms na CPU, ali si stvar dejansko kaj pohitril? Čisto nič, ker je ozko grlo GPU. Stvar se rahlo zakomplicira, ker ni nujno, da je celih 16ms, kolikor se recimo frame renderira, ozko grlo GPU. Lahko je samo 80% časa (12.8ms). Bolj, ko optimiziraš preostalih 20% za nižji CPU usage, bolj boš dvignil %, ko je ozko grlo GPU.

Predator X je izjavil:

Pa kaj ti je graf tolk pomemben?

Če slučajn hočš povedat, da ni potrebe po low lvl APIju za PC platformo. Ja, AMD ma malce večjo srečo, ker XBOX One scorpio (tud PS4 Pro ima amd arch) uporablja DX12 (zdej pride scorpio brez edrama).

Če pa misliš, povedat, da je DX11 dovolj dober in se ga da dobro optimiziran - enostavno se motiš. Tud nvidia bo laufala lepš na DX12ki.

In kaj je vam trollom tolk pomembno bluzit o tem kako je AMD zakon za DX12 in kako je NV crap?

Jaz samo razlagam zakaj je temu tako. In bi temu bilo tako leta 2011 (star graf) in je danes še bolj očitno (graf v temle postu zgoraj).

Seveda je API kot je DX12 potreben. GPU-ji so že 6 let nazaj zamenjal način naslavljanja resourcev, ki je sedaj veliko manj restriktiven kot v DX11 (o low level API-ju s tabo pač nima smisla debatirat, ker nimaš pojma kako dejansko izgleda D3D11 API ne kako izgleda D3D12 API).

To kaj uporablja XBox One je dost irelavantno (PS4 ne uporablja DirectX-a). Konzole so že od nekdaj imele bolj light weight API. Ker so zaprt ekosistem, kjer se kontrolira kaj se spusti gor (lahko zaupaš, da ne bo nek X hardware kombinacija z Y software-om enostavno usula mašine, ergo API ne rabi delat validacije).

Vprašanje, če bodo igre sploh kdaj šle do 100K draw klicev na frame (ker konec koncev kakšno korist imaš od tega kot igralec?). V razvoju so pogoni, kjer se GPU krmi kar sam, z zelo minimalno interakcijo s CPU-jem. Zato spet rabiš DX12. Z naslednjim Win10 update-om pride v DX12 končno še SM6...

Za današnje igre je pa DX12 čisto samo igračkanje s strani developerjev. Potrebno zato, da se developerji navadijo novega API-ja. Za igralce pa povsem brez veze, razen za tiste, ki si lastijo AMD grafo.

Predator X ::

Noben ne bluzi o tem kolk je NVIDIA crap na DX12tki. Okey nekateri radi troolajo, drugi pa radi dregajo v nvidia fanboye.

RX 480 ma bolj poštiman CPU overhead.

Teli tvoji grafi niso ravno najbolj dostojni.

DX11 je preveč...

Počak a slučajn vidm 1.5-2x na i3jki?

RX 480 ma bolj poštiman CPU overhead.

Teli tvoji grafi niso ravno najbolj dostojni.

DX11 je preveč...

Počak a slučajn vidm 1.5-2x na i3jki?

Zgodovina sprememb…

- spremenilo: Predator X ()

D3m0r4l1z3d ::

Torej ne razumeš še vedno, PredatorX?

ETN Wallet addr.: etnkGuvhDzR7Dh8us4e69VStubGbmQHrh5pe2fnpNDhEhX5

A1nCWrFBMK2NmkycgVN4sAwhvY8YyNNbF6KUSJyFZ99QKU8phCn

Cryptopia ref. link: https://www.cryptopia.co.nz/Register?referrer=Anymalus

A1nCWrFBMK2NmkycgVN4sAwhvY8YyNNbF6KUSJyFZ99QKU8phCn

Cryptopia ref. link: https://www.cryptopia.co.nz/Register?referrer=Anymalus

D3m ::

Me ima pognat na 680 z enimi starejšimi driverji in zadnjimi (ajde dam še R9 380X zraven). Tko da pokažem kaj se je glede tega zgodilo pri NV tam enkrat začetek 2015... Naslednji vikend.

Sem se spomnil, da bi za ta test dejansko moral postavit kišto z Win 7, kar je pa bistveno več časa kot sem ga pripravljen vložit v tole.

Je pa stanje danes takole:

Torej iz 2x razlike leta 2011 smo prišli na 4x razliko leta 2017. Zelo lepo se vidi kje rata na kateri grafi problem DX (kje se graf prelomi). In kako zabavno se R9 390X obnaša v multi threading scenariju (ki ga ATI/AMD ni nikoli implementiral). 100k Draw klicev: playable na NV (100FPS), unplayable na AMD (25FPS).

Edini špil, ki gre v to smer je Ashes of the Singularity (in je zlo na meji igrabilnosti v DX11 na AMD grafah).

Tudi ti sekaš mimo. Če ima igra oboje, in DX11 in DX12 kodo, potem bi ob pravilni implementaciji morala biti DX12 koda hitrejša oz. pri enakih fpsih z več detajli v 3D prostoru v primerjavi z DX11 kodo. Če to ni, potem v tisti igri DX12 ni pravilno implementiran. Low overhead, asinhrono računanje in pravi multi-core način delovanja pogona igre potegne to (več fps oz. višji fidelity) za seboj.

Glej... Kaj naj ti rečem? Kot prvo zakaj misliš, da je tvoje razumevanje na nivoju, da se boš šel o tem bockat recimo z NV inžinirjem?

Kot drugo: low overhead in multi threading niti najmanj ne zmanjšata dela na GPU-ju. Igre so primarno omejene s strani GPU-ja. Če nebi bile, potem bi dal v kišto najprej 280X in potem Fury X in bi imel v obeh primerih identično izkušnjo. "Async compute" pomaga pri izkoriščenosti GPU-ja v nekaterih primerih. Ne rabiš pa niti približno DX12, da prideš do tega (NV na Pascalih dela to tudi v DX11, AMD sklepam da ne; preverjal pa za forumske trolle ne bom).

Če frame rabi 16ms na GPU in 10ms na CPU v DX11 in bo v DX12 rabil 16ms na GPU in 1ms na CPU, ali si stvar dejansko kaj pohitril? Čisto nič, ker je ozko grlo GPU. Stvar se rahlo zakomplicira, ker ni nujno, da je celih 16ms, kolikor se recimo frame renderira, ozko grlo GPU. Lahko je samo 80% časa (12.8ms). Bolj, ko optimiziraš preostalih 20% za nižji CPU usage, bolj boš dvignil %, ko je ozko grlo GPU.

Predator X je izjavil:

Pa kaj ti je graf tolk pomemben?

Če slučajn hočš povedat, da ni potrebe po low lvl APIju za PC platformo. Ja, AMD ma malce večjo srečo, ker XBOX One scorpio (tud PS4 Pro ima amd arch) uporablja DX12 (zdej pride scorpio brez edrama).

Če pa misliš, povedat, da je DX11 dovolj dober in se ga da dobro optimiziran - enostavno se motiš. Tud nvidia bo laufala lepš na DX12ki.

In kaj je vam trollom tolk pomembno bluzit o tem kako je AMD zakon za DX12 in kako je NV crap?

Jaz samo razlagam zakaj je temu tako. In bi temu bilo tako leta 2011 (star graf) in je danes še bolj očitno (graf v temle postu zgoraj).

Seveda je API kot je DX12 potreben. GPU-ji so že 6 let nazaj zamenjal način naslavljanja resourcev, ki je sedaj veliko manj restriktiven kot v DX11 (o low level API-ju s tabo pač nima smisla debatirat, ker nimaš pojma kako dejansko izgleda D3D11 API ne kako izgleda D3D12 API).

To kaj uporablja XBox One je dost irelavantno (PS4 ne uporablja DirectX-a). Konzole so že od nekdaj imele bolj light weight API. Ker so zaprt ekosistem, kjer se kontrolira kaj se spusti gor (lahko zaupaš, da ne bo nek X hardware kombinacija z Y software-om enostavno usula mašine, ergo API ne rabi delat validacije).

Vprašanje, če bodo igre sploh kdaj šle do 100K draw klicev na frame (ker konec koncev kakšno korist imaš od tega kot igralec?). V razvoju so pogoni, kjer se GPU krmi kar sam, z zelo minimalno interakcijo s CPU-jem. Zato spet rabiš DX12. Z naslednjim Win10 update-om pride v DX12 končno še SM6...

Za današnje igre je pa DX12 čisto samo igračkanje s strani developerjev. Potrebno zato, da se developerji navadijo novega API-ja. Za igralce pa povsem brez veze, razen za tiste, ki si lastijo AMD grafo.

Ena napaka. Pri sliki piše R9 390X v testu je R9 380X, kar je precejšna razlika.

|HP EliteBook|R7 8840U|

Senitel ::

Eko še 680 zraven:

Nevem zakaj govoriš v tretji osebi?

RX 480 ne naredi ničesar glede tega. To ni problem hardware-a, ampak driverja. AMD ni tolk usekan kot nekateri forumaši, da bi to popravil v driverjih za neko novo generacijo, prejšnjo pa pustil na suhem.

Imaš prav, 380X je. Ampak razlika bi bila samo v prvi 1/5 grafa.

Predator X je izjavil:

Noben ne bluzi o tem kolk je NVIDIA crap na DX12tki. Okey nekateri radi troolajo, drugi pa radi dregajo v nvidia fanboye.

RX 480 ma bolj poštiman CPU overhead.

Nevem zakaj govoriš v tretji osebi?

RX 480 ne naredi ničesar glede tega. To ni problem hardware-a, ampak driverja. AMD ni tolk usekan kot nekateri forumaši, da bi to popravil v driverjih za neko novo generacijo, prejšnjo pa pustil na suhem.

Predator X je izjavil:

Teli tvoji grafi niso ravno najbolj dostojni.

Ena napaka. Pri sliki piše R9 390X v testu je R9 380X, kar je precejšna razlika.

Imaš prav, 380X je. Ampak razlika bi bila samo v prvi 1/5 grafa.

Zgodovina sprememb…

- spremenil: Senitel ()

D3m ::

Precej impresivno, če gledamo 680 ampak v igrah ji to ne pomaga kaj veliko, ker je R9 380X hitrejša.

Se pa vidi, da morajo še delati na poliranju driverjev.

Katere driver verzije si uporabil?

Vprašanje, če bodo igre sploh kdaj šle do 100K draw klicev na frame

Se pa vidi, da morajo še delati na poliranju driverjev.

Katere driver verzije si uporabil?

|HP EliteBook|R7 8840U|

Jst ::

Predator X je izjavil:

Če pa misliš, povedat, da je DX11 dovolj dober in se ga da dobro optimiziran - enostavno se motiš. Tud nvidia bo laufala lepš na DX12ki.

Prosim odgovori mi tole:

Zakaj sploh obstajajo knjižnice, kot so DirectX, OpenGL, OpenAL?

Dobr zdej že spet v eno skrajnost. DX12 je boljši od DX11 in to je to.

A kar tako, zaradi višje številke?

Zakaj obstaja DirectInput knjižnica? Ter XInput?

Islam is not about "I'm right, you're wrong," but "I'm right, you're dead!"

-Wole Soyinka, Literature Nobelist

|-|-|-|-|Proton decay is a tax on existence.|-|-|-|-|

-Wole Soyinka, Literature Nobelist

|-|-|-|-|Proton decay is a tax on existence.|-|-|-|-|

D3m0r4l1z3d ::

Precej impresivno, če gledamo 680 ampak v igrah ji to ne pomaga kaj veliko, ker je R9 380X hitrejša.

Vprašanje, če bodo igre sploh kdaj šle do 100K draw klicev na frame

Se pa vidi, da morajo še delati na poliranju driverjev.

Katere driver verzije si uporabil?

Letnice moraš upoštevati pri HW, žal gpuja ne moreš hotfixat, 680 je bila 2012 že na policah.

ETN Wallet addr.: etnkGuvhDzR7Dh8us4e69VStubGbmQHrh5pe2fnpNDhEhX5

A1nCWrFBMK2NmkycgVN4sAwhvY8YyNNbF6KUSJyFZ99QKU8phCn

Cryptopia ref. link: https://www.cryptopia.co.nz/Register?referrer=Anymalus

A1nCWrFBMK2NmkycgVN4sAwhvY8YyNNbF6KUSJyFZ99QKU8phCn

Cryptopia ref. link: https://www.cryptopia.co.nz/Register?referrer=Anymalus

D3m ::

Ampak po hitrosti sta skoraj identične, če gledaš HW specifikacijo.

http://www.hwcompare.com/29506/geforce-...

Oz. je GTX 680 v prednosti.

http://www.hwcompare.com/29506/geforce-...

Oz. je GTX 680 v prednosti.

|HP EliteBook|R7 8840U|

Zgodovina sprememb…

- spremenil: D3m ()

Predator X ::

Predator X je izjavil:

Če pa misliš, povedat, da je DX11 dovolj dober in se ga da dobro optimiziran - enostavno se motiš. Tud nvidia bo laufala lepš na DX12ki.

Prosim odgovori mi tole:

Zakaj sploh obstajajo knjižnice, kot so DirectX, OpenGL, OpenAL?

Dobr zdej že spet v eno skrajnost. DX12 je boljši od DX11 in to je to.

A kar tako, zaradi višje številke?

Zakaj obstaja DirectInput knjižnica? Ter XInput?

Toliko detailov, ki jih lahko dosežeš z DX12 jih z DX11 nemoreš. Na kateri grafi bo pa bolje laufal je pa odvisno od developerjev.

Graf, ki ga kaže Senitel tudi ne pove celotne zgodbe.

Zgodovina sprememb…

- spremenilo: Predator X ()

Senitel ::

Precej impresivno, če gledamo 680 ampak v igrah ji to ne pomaga kaj veliko, ker je R9 380X hitrejša.

Point teh grafov je kaj se dogaja v DX12. Point je, če igra vrže 30000 draw-jev na GPU se bo frame rate na kateri koli AMD grafi enostavno sesedu. NV grafe na drugi strani bodo to požrle brez najmanjšega problema. Če igra naredi isto v DX12 potem se tudi AMD grafe ne bodo več sesedle. Future proof ane.

Se pa vidi, da morajo še delati na poliranju driverjev.

Katere driver verzije si uporabil?

Zakaj morajo še polirat driverje? Saj mamo DX12. DX11 bo na AMD-ju ostal v takem stanju kot je danes. Driverji so drugače zadnji razpoložljivi tako za AMD kot NV.

Ampak po hitrosti sta skoraj identične, če gledaš HW specifikacijo.

http://www.hwcompare.com/29506/geforce-...

Oz. je GTX 680 v prednosti.

Še ena z alternativnimi dejstvi al kako? 680 in 380X sta zlo tam tam po večini specifikacij. Ima pa 380X precej večji compute kick (in grafika že več kot desetletje teče v shaderjih). 680 je 3/4 od 380X v najboljšem primeru in 1/2 v najslabšem. In kljub temu 680 kar nekak ne krepne proti 380X. Zakaj? Grafi v mojih prejšnjih postih...

D3m0r4l1z3d ::

Že 15 let ne gledam samo po specikacijah in teoretičnih testih. Recimo pixel fillrate, pa ta zdaj od Senitela. Sigurno vse velja, ampak najboljše reviewe kjer je vse skupaj pojasnjeno in seveda testi v igrah.

ETN Wallet addr.: etnkGuvhDzR7Dh8us4e69VStubGbmQHrh5pe2fnpNDhEhX5

A1nCWrFBMK2NmkycgVN4sAwhvY8YyNNbF6KUSJyFZ99QKU8phCn

Cryptopia ref. link: https://www.cryptopia.co.nz/Register?referrer=Anymalus

A1nCWrFBMK2NmkycgVN4sAwhvY8YyNNbF6KUSJyFZ99QKU8phCn

Cryptopia ref. link: https://www.cryptopia.co.nz/Register?referrer=Anymalus

Zgodovina sprememb…

- spremenilo: D3m0r4l1z3d ()

Senitel ::

Predator X je izjavil:

Toliko detailov, ki jih lahko dosežeš z DX12 jih z DX11 nemoreš. Na kateri grafi bo pa bolje laufal je pa odvisno od developerjev.

Graf, ki ga kaže Senitel tudi ne pove celotne zgodbe.

Število draw call-ov ni enako količina detajlov. Lahko izrišeš tudi miljardo trikonikov v stotih draw klicih.

Predator X ::

Predator X je izjavil:

Toliko detailov, ki jih lahko dosežeš z DX12 jih z DX11 nemoreš. Na kateri grafi bo pa bolje laufal je pa odvisno od developerjev.

Graf, ki ga kaže Senitel tudi ne pove celotne zgodbe.

Število draw call-ov ni enako količina detajlov. Lahko izrišeš tudi miljardo trikonikov v stotih draw klicih.

Zate je vse tko simpl.

Očitno poznaš vse rešitve.

Zgodovina sprememb…

- predlagal izbris: SuperVeloce ()

D3m ::

Za enkrat še ne. Če je govora o najdražji.

|HP EliteBook|R7 8840U|

Zgodovina sprememb…

- spremenil: D3m ()

Predator X ::

iloveboobz je izjavil:

Ne bit tak salty, če ne razumeš zadeve. In ker tvoj favorit ni on top.

Noben ni salty, senitel je pač človek, ki je 50 let pred vsemi.

Zgodovina sprememb…

- predlagal izbris: SuperVeloce ()

GenZNPC ::

DX12 je za AMD Emergency exit iz DX11. Vse lepo in prav. Pac so v DX11 prej prisli do nepremagljivega zida, kot NV

skibidi

D3m0r4l1z3d ::

Še najbolj jih heca 250W. Če bi lahko 350+w gpu dobro prodajali, potem bi zmagali

ETN Wallet addr.: etnkGuvhDzR7Dh8us4e69VStubGbmQHrh5pe2fnpNDhEhX5

A1nCWrFBMK2NmkycgVN4sAwhvY8YyNNbF6KUSJyFZ99QKU8phCn

Cryptopia ref. link: https://www.cryptopia.co.nz/Register?referrer=Anymalus

A1nCWrFBMK2NmkycgVN4sAwhvY8YyNNbF6KUSJyFZ99QKU8phCn

Cryptopia ref. link: https://www.cryptopia.co.nz/Register?referrer=Anymalus

Jarno ::

Zanimivi zaključki. Če nekdo nekaj zna, potem implikantno drugi ne zna, če ju primerjaš.

Zakaj AMD ne bi znal ASM optimizacij kritičnih delov driverjev, ki posredujejo klice v gpu, pa mi še ni jasno.

Znajo pa spisati mantle po drugi strani.

Lahko bi tudi rekli hebeš DX12, imamo Vulkan, ki je cross-platform.

Kar se tiče Vege, a bo klecnila pri 30k draw klicih v DX11? DX11 bomo žulili še precej časa.

Zakaj AMD ne bi znal ASM optimizacij kritičnih delov driverjev, ki posredujejo klice v gpu, pa mi še ni jasno.

Znajo pa spisati mantle po drugi strani.

Lahko bi tudi rekli hebeš DX12, imamo Vulkan, ki je cross-platform.

Kar se tiče Vege, a bo klecnila pri 30k draw klicih v DX11? DX11 bomo žulili še precej časa.

Jst ::

Zakaj sem dal primerjavo DirectInput in XInput?

DirectInput so knjižnice, ki mappajo input (miš, tipkovnica, gamepad,...) v game engine. XInput pa je knjižica, ki mappa XBox style kontroler klice v game engine.

Dosti enostavneje je uporabiti XInput za gamepade, ker je namenjen točno temu.

Lepa analogija z DirectX. Samo da je CPU tu obrnjen. DX11 je lažji za uporabo a bolj obremenjuje CPU.

Sicer pa, na področju grafike, se šele zadnja leta udejanjajo tehnike, ki so bile na voljo že vsaj 5 let nazaj. DX11 je star skoraj 10 let! Tako, da ja. Senitel je from the future.

DirectInput so knjižnice, ki mappajo input (miš, tipkovnica, gamepad,...) v game engine. XInput pa je knjižica, ki mappa XBox style kontroler klice v game engine.

Dosti enostavneje je uporabiti XInput za gamepade, ker je namenjen točno temu.

Lepa analogija z DirectX. Samo da je CPU tu obrnjen. DX11 je lažji za uporabo a bolj obremenjuje CPU.

Sicer pa, na področju grafike, se šele zadnja leta udejanjajo tehnike, ki so bile na voljo že vsaj 5 let nazaj. DX11 je star skoraj 10 let! Tako, da ja. Senitel je from the future.

Islam is not about "I'm right, you're wrong," but "I'm right, you're dead!"

-Wole Soyinka, Literature Nobelist

|-|-|-|-|Proton decay is a tax on existence.|-|-|-|-|

-Wole Soyinka, Literature Nobelist

|-|-|-|-|Proton decay is a tax on existence.|-|-|-|-|

FireSnake ::

Predator X je izjavil:

Predator X je izjavil:

Toliko detailov, ki jih lahko dosežeš z DX12 jih z DX11 nemoreš. Na kateri grafi bo pa bolje laufal je pa odvisno od developerjev.

Graf, ki ga kaže Senitel tudi ne pove celotne zgodbe.

Število draw call-ov ni enako količina detajlov. Lahko izrišeš tudi miljardo trikonikov v stotih draw klicih.

Zate je vse tko simpl.

Očitno poznaš vse rešitve.

Zate je še bolj preprosto, ko nimaš pojma pa bleješ v tri krasne.

Pa nisi edini.

Sta vsaj še dva taka pacienta v tej temi.

Poglej in se nasmej: vicmaher.si

Predator X ::

iloveboobz je izjavil:

sj razumemo da morš nekam svoje vsakodnevne frustracije spustit.

LOL, uglavm AMD sucks. Thats it.

Zgodovina sprememb…

- predlagal izbris: SuperVeloce ()

Predator X ::

Veliko se trola, moraš razumeti.

Sej sm dal benchmark kjer DX11 popuši proti DX12, na NVIDIA kartici. Če se prab spomnim, je star swarm benchmark utiliziral samo 2 jedra na DX11 na AMD gpuju.

Zgodovina sprememb…

- spremenilo: Predator X ()

Predator X ::

Ni izjeme. DX11 je občutno slabši od DX12. Če hočeš doseči max performance z low power proci ali pa normalno igrati nek špil z 200+ igralci na mapi.

GenZNPC ::

normalno igrati nek špil z 200+ igralci na mapi.

Normalno z 200+ igralci itak ne mores igrat

skibidi

Jarno ::

Predator X je izjavil:

LOL, uglavm AMD sucks. Thats it.

Sploh ne. Prodajne številke z mindfactory.de so kar spodbudne.

Recimo tudi pri RX 460, ki se kar prodaja (preko 3k artiklov), kar niti ni slabo v primerjavi z 5k GTX 1050Ti.

Naštel sem tudi okoli 7k prodanih RX 470. Po spominu so se radeoni 380 in 380X prodajali precej slabše.

Moraš biti bolj natančen pri svojih izjavah, recimo bi lahko napisal, da AMD sucks v določenem cenovnem segmentu, v katerem so trenutno fury, fury-x in nano.