Forum » Strojna oprema » AMD Vega GPU

AMD Vega GPU

Temo vidijo: vsi

D3m0r4l1z3d ::

...ki se zelo slabo obnese v igrah...

Cveto, imam občutek, da se tako obnese, ker je tudi njen geforce counterpart star oziroma slab čip

Irelevantno.

Cveto, imam občutek, da se tako obnese, ker je tudi njen geforce counterpart star oziroma slab čip

Boš poslal instruction manual?

Irelevantno.

ETN Wallet addr.: etnkGuvhDzR7Dh8us4e69VStubGbmQHrh5pe2fnpNDhEhX5

A1nCWrFBMK2NmkycgVN4sAwhvY8YyNNbF6KUSJyFZ99QKU8phCn

Cryptopia ref. link: https://www.cryptopia.co.nz/Register?referrer=Anymalus

A1nCWrFBMK2NmkycgVN4sAwhvY8YyNNbF6KUSJyFZ99QKU8phCn

Cryptopia ref. link: https://www.cryptopia.co.nz/Register?referrer=Anymalus

Zgodovina sprememb…

- spremenilo: D3m0r4l1z3d ()

D3m0r4l1z3d ::

AMD RX Vega to support DirectX 12 level 12.1 features

According to details spotted by Overclock3D.com, over at the Beyond3D forum, Vega GPU will not only have support for DirectX 12 level 12.1 but also bring features that are not available on Nvidia Pascal GPUs, the Conservative Rasterisation Level 3 and support for 16-bit minimum floating point precision. The Vega GPU will also bring support for Rasterizer-Ordered Views and Tiled Resources Level 3, something that Nvidia had since Maxwell days.

Senitel na Beyond3D forumu:

https://forum.beyond3d.com/threads/dire...

According to details spotted by Overclock3D.com, over at the Beyond3D forum, Vega GPU will not only have support for DirectX 12 level 12.1 but also bring features that are not available on Nvidia Pascal GPUs, the Conservative Rasterisation Level 3 and support for 16-bit minimum floating point precision. The Vega GPU will also bring support for Rasterizer-Ordered Views and Tiled Resources Level 3, something that Nvidia had since Maxwell days.

Senitel na Beyond3D forumu:

https://forum.beyond3d.com/threads/dire...

ETN Wallet addr.: etnkGuvhDzR7Dh8us4e69VStubGbmQHrh5pe2fnpNDhEhX5

A1nCWrFBMK2NmkycgVN4sAwhvY8YyNNbF6KUSJyFZ99QKU8phCn

Cryptopia ref. link: https://www.cryptopia.co.nz/Register?referrer=Anymalus

A1nCWrFBMK2NmkycgVN4sAwhvY8YyNNbF6KUSJyFZ99QKU8phCn

Cryptopia ref. link: https://www.cryptopia.co.nz/Register?referrer=Anymalus

DarwiN ::

Torej se bo zgodba nadaljevala? Trenutni performance zgolj OK, vendar kmalu v PRIHODNOSTI, ko bodo igre začele izkoriščati vse te sodobne bonbončke, takrat pa res štala in bo Vega pometla še z Volto, če bo treba.

You just wait. The AMD way.

You just wait. The AMD way.

You don't see faith healers working in hospitals

for the same reason you don't see psychics winning the lottery!

for the same reason you don't see psychics winning the lottery!

RejZoR ::

Niti ne, samo driverje morajo prvo spravit v red za gaming ker so imo totalno v riti (z drugimi besedami "zaenkrat delujoči tolk da pokažejo sliko"). Glede na to da so špili za en drek na Vega FE, productivity pa deluje super bi reku, da je to kar realna ocena. Zato pa bo RX Vega izšla tolk kasneje. Če bi bilo vse tipitopi okoli rasteriziranja iger bi RX Vega lahko releasali skupaj z Vega FE, pa tega niso storili. In če se nič ne da več pridobit, zakaj zaboga bi potem 30 dni gledal v luft? Tle sploh ne gre za % performansa, tle se gre, da bojo sploh dejansko deloval kot je treba.

Angry Sheep Blog @ www.rejzor.com

Grey ::

Vega "Fake Edition" je bila izdana samo zato, ker so jo lahko (ker so jo morali) in ker za productivity deluje že s takimi driverji, kjer pol stvari manjka, hitreje od prejšnjih GCN kartic. Zdaj, če ljudje na podlagi tega ocenjujejo gaming performans...jah njihov problem. Jasno je bilo rečeno, da bo RX Vega boljša v igrah. Gaming optimizirani driverji z vsemi bonbončki pa čakajo na disku v štabu AMD in ga bodo splavili, ko bo launch za RX Vega. Dokler niso naredili malo zaloge za 8GB verzijo ni imelo smisla to ven dajat, ker bi se lahko nVidia prej prilagodila. Tako se bo pa pač malo kasneje.

Zgodovina sprememb…

- spremenilo: Grey ()

DarwiN ::

Ampak tolk katastrofalni driverji ne bi smeli biti, ko pa je menda že pred februarjem 80% software inženirjev delalo na driverjih, da bi tokrat ponudili izpiljene driverje on day one.

You don't see faith healers working in hospitals

for the same reason you don't see psychics winning the lottery!

for the same reason you don't see psychics winning the lottery!

Grey ::

Ampak tolk katastrofalni driverji ne bi smeli biti, ko pa je menda že pred februarjem 80% software inženirjev delalo na driverjih, da bi tokrat ponudili izpiljene driverje on day one.

Sej so. Za workstation so čist v redu driverji. Za gaming pa preberi moj post zgoraj in Kodurijeve besede glede RX Vega.

Me pa zanima nekaj od znalcev tukaj...Tile Based Rasterization se bo potem poznala/delovala tudi na R9 3xx in 4xx serijah?

Zgodovina sprememb…

- spremenilo: Grey ()

RejZoR ::

Vega "Fake Edition" je bila izdana samo zato, ker so jo lahko (ker so jo morali) in ker za productivity deluje že s takimi driverji, kjer pol stvari manjka, hitreje od prejšnjih GCN kartic. Zdaj, če ljudje na podlagi tega ocenjujejo gaming performans...jah njihov problem. Jasno je bilo rečeno, da bo RX Vega boljša v igrah. Gaming optimizirani driverji z vsemi bonbončki pa čakajo na disku v štabu AMD in ga bodo splavili, ko bo launch za RX Vega. Dokler niso naredili malo zaloge za 8GB verzijo ni imelo smisla to ven dajat, ker bi se lahko nVidia prej prilagodila. Tako se bo pa pač malo kasneje.

Točno takega mnenja sem tud sam. Ker productivity številke so dobre. Gaming številke pa so totalno v PM. Glede na to da planirajo release RX Vega z 1 mesecem zamika tle ne moremo govorit o 5% boosta ampak o tem, da bojo driverji dejansko sploh polno delujoči. Kar pa dvomim, da bo zgolj 5%. Al pa 10%. Za take male razlike bi bilo vseeno če bi releasal Vego as is in kasneje izdal boljše driverje.

Angry Sheep Blog @ www.rejzor.com

Senitel ::

Torej se bo zgodba nadaljevala? Trenutni performance zgolj OK, vendar kmalu v PRIHODNOSTI, ko bodo igre začele izkoriščati vse te sodobne bonbončke, takrat pa res štala in bo Vega pometla še z Volto, če bo treba.

D3D12 feature level-i nimajo nič s performansami. In pa Vega sedaj vpeljuje razliko v feature-jih do Polarisa.

Me pa zanima nekaj od znalcev tukaj...Tile Based Rasterization se bo potem poznala/delovala tudi na R9 3xx in 4xx serijah?

Itak. Še na Rage MAXX bo to pol delal.

In pa: I still call dibs na Titan XP (gaming) performance za 550€ (če bo trebe dve Vegi se ne bom sekiral).

In pa: zakaj brihte po internetu zdej na veliko uporabljajo "Tile Based Rasterization", če to ni to kar NV počne? That's PowerVR thing ne pa NV thing.

RejZoR ::

PowerVR se je iz desktopov poslovil s Kyro II. Zato folk referira NVIDIO in ne PowerVR.

Vega vbistvu uporablja mal drugačno metodo od NVIDIE, ampak ni znano kako se odraža v onem tester programu (tist trikotnik, ki se obarva na specifičen način če je TBR v uporabi). TBR je strojna zadeva in je ne moreš kar vržt na Polarisa ali Grenado brez da bi spreminjal dejanski čip.

Vega vbistvu uporablja mal drugačno metodo od NVIDIE, ampak ni znano kako se odraža v onem tester programu (tist trikotnik, ki se obarva na specifičen način če je TBR v uporabi). TBR je strojna zadeva in je ne moreš kar vržt na Polarisa ali Grenado brez da bi spreminjal dejanski čip.

Angry Sheep Blog @ www.rejzor.com

Senitel ::

Point je, da to kar NV počne ni per se TBR, to kar PowerVR počne je T(D)BR. NV je še vedno IMR.

RejZoR ::

TBR je bil vsaj na Kyro II dost problematičen v precej špilih, pa takrat niti niso bili tolk kompleksni (grafično) kot danes. Zdej ne vem al zarad same implementacije in manjka dela na driverjih al je bil zadaj kakšen drug razlog za redne težave z raztegnjenimi polyji, artefakti in sličnimi zadevami?

Angry Sheep Blog @ www.rejzor.com

Grey ::

Me pa zanima nekaj od znalcev tukaj...Tile Based Rasterization se bo potem poznala/delovala tudi na R9 3xx in 4xx serijah?

Itak. Še na Rage MAXX bo to pol delal.

In pa: I still call dibs na Titan XP (gaming) performance za 550EUR (če bo trebe dve Vegi se ne bom sekiral).

In pa: zakaj brihte po internetu zdej na veliko uporabljajo "Tile Based Rasterization", če to ni to kar NV počne? That's PowerVR thing ne pa NV thing.

Heh, dobro, da mi sarkazem detektor dela :)

No, verjetno se je uporaba izraza razširila zaradi tega in ostalih podobnih člankov.

TBR je strojna zadeva in je ne moreš kar vržt na Polarisa ali Grenado brez da bi spreminjal dejanski čip.

Jasno, hvala.

Zgodovina sprememb…

- spremenilo: Grey ()

D3m ::

Ampak tolk katastrofalni driverji ne bi smeli biti, ko pa je menda že pred februarjem 80% software inženirjev delalo na driverjih, da bi tokrat ponudili izpiljene driverje on day one.

Sej so. Za workstation so čist v redu driverji. Za gaming pa preberi moj post zgoraj in Kodurijeve besede glede RX Vega.

Me pa zanima nekaj od znalcev tukaj...Tile Based Rasterization se bo potem poznala/delovala tudi na R9 3xx in 4xx serijah?

Ne. Ker kartice ne podpirajo tega.

|HP EliteBook|R7 8840U|

Jst ::

>Tile Based Rasterization

A še vedno? Ali je Vega spet kickala to?

Če prav razumem, Maxwell in Pascall skrbita, da so podatki dostopni v Cache-u, in s tem pridobijo na dveh stvareh. Manj prekladanja z RAMom in večja zaposlenost Stream enot.

Razumem prav?

Vega Arch diagram, ki so ga izdali, sugerira točno to.

A še vedno? Ali je Vega spet kickala to?

Če prav razumem, Maxwell in Pascall skrbita, da so podatki dostopni v Cache-u, in s tem pridobijo na dveh stvareh. Manj prekladanja z RAMom in večja zaposlenost Stream enot.

Razumem prav?

Vega Arch diagram, ki so ga izdali, sugerira točno to.

Islam is not about "I'm right, you're wrong," but "I'm right, you're dead!"

-Wole Soyinka, Literature Nobelist

|-|-|-|-|Proton decay is a tax on existence.|-|-|-|-|

-Wole Soyinka, Literature Nobelist

|-|-|-|-|Proton decay is a tax on existence.|-|-|-|-|

Jst ::

>Razumem prav?

To se nanaša na tisti program in zakaj se renderira vedno manjši "tile", ko se veča kompleksnost. Ker je v L2 Cache podatkov samo za določeno "tile" velikost.

To se nanaša na tisti program in zakaj se renderira vedno manjši "tile", ko se veča kompleksnost. Ker je v L2 Cache podatkov samo za določeno "tile" velikost.

Islam is not about "I'm right, you're wrong," but "I'm right, you're dead!"

-Wole Soyinka, Literature Nobelist

|-|-|-|-|Proton decay is a tax on existence.|-|-|-|-|

-Wole Soyinka, Literature Nobelist

|-|-|-|-|Proton decay is a tax on existence.|-|-|-|-|

D3m0r4l1z3d ::

A je ta L2 cache res tako drag?

ETN Wallet addr.: etnkGuvhDzR7Dh8us4e69VStubGbmQHrh5pe2fnpNDhEhX5

A1nCWrFBMK2NmkycgVN4sAwhvY8YyNNbF6KUSJyFZ99QKU8phCn

Cryptopia ref. link: https://www.cryptopia.co.nz/Register?referrer=Anymalus

A1nCWrFBMK2NmkycgVN4sAwhvY8YyNNbF6KUSJyFZ99QKU8phCn

Cryptopia ref. link: https://www.cryptopia.co.nz/Register?referrer=Anymalus

RejZoR ::

L2 cache je največji cache na GPU-jih. Nekako tko kot L3 na CPU-jih. Če nekaj zaseda velik del jedra, potem je to ponavadi drago (iz stališča izdelave, ker ne sme bit nobenih defektov in iz stališča design prostora). Plus tak cache se zelo rad precej greje kar predstavlja dodatne ovire. R9 Fury X je imel 2MB L2 cache, za RX Vega pa nikjer ne najdem info... Samo da bo L2 precej večji.

Angry Sheep Blog @ www.rejzor.com

Jst ::

Senitel: Če je bilo tisti tekst namenjen direktno meni z vzvišenim tonom pisanja, ker sem quatal tole:

Razloži mi, PROSIM, naslednje:

AMD je dal primerjavo DeusEx side by side z HBCC On in HBCC Off. Ko je bil HBCC vključen, je igra (/benchmark) laufala smooth, brez zatikanja. Na monitorju, kjer je bil HBCC Off, so bili DIAPOZITIVI. (Takšna razlika, da slepec ne more faliti.)

Gamer Nexus so na YouTubu dali primerjavo Fury X in Vega FE, Zmanjšali Core Clock in enak Memory Bandwidth. Rezultati? Enak performans Fury X in Vega FE v igrah.

Please, explain this conundrum. Pa ne na način, kot je v srednješolskih učbenikih, kako poteka procesiranje. Veš, da kodiram* za kruh, samo nisem "specializiran" na GPU rendering področjih.

*Čedalje manj, ker sem seveda v desetletju in pol, ko sva se takrat "kregala" o raytracingu, karierno napredoval.

The AMD Radeon R9 Fury X kind of backs that statement up since it was able to allocate dynamic VRAM for extra VRAM past its 4GB of dedicated VRAM capacity. We saw up to a 4GB utilization of dynamic VRAM. That allowed the Fury X to keep its 4GB of dedicated VRAM maxed out and then use system RAM for extra storage. In our testing, this did not appear to negatively impact performance. At least we didn't notice anything in terms of choppy framerates or "micro-stutter." The Fury X seems to be using the dynamic VRAM as a cache rather than a direct pool of instant VRAM. This would make sense since it did not cause a performance drain and obviously system RAM is a lot slower than local HBM on the Fury X. If you remember a good while ago that AMD was making claims to this effect, but this is the first time we have actually been able to show results in real world gaming. It is awesome to see some actual validation of these statements a year later. This is what AMD said about this in June of 2015.

Note that HBM and GDDR5 memory sized can't be directly compared. Think of it like comparing an SSD's capacity to a mechanical hard drive's capacity. As long as both capacities are sufficient to hold local data sets, much higher performance can be achieved with HBM, and AMD is hand tuning games to ensure that 4GB will not hold back Fiji's performance. Note that the graphics driver controls memory allocation, so its incorrect to assume that Game X needs Memory Y. Memory compression, buffer allocations, and caching architectures all impact a game's memory footprint, and we are tuning to ensure 4GB will always be sufficient for 4K gaming. Main point being that HBM can be thought of as a giant embedded cache, and is not directly comparable to GDDR5 sizes.

Razloži mi, PROSIM, naslednje:

AMD je dal primerjavo DeusEx side by side z HBCC On in HBCC Off. Ko je bil HBCC vključen, je igra (/benchmark) laufala smooth, brez zatikanja. Na monitorju, kjer je bil HBCC Off, so bili DIAPOZITIVI. (Takšna razlika, da slepec ne more faliti.)

Gamer Nexus so na YouTubu dali primerjavo Fury X in Vega FE, Zmanjšali Core Clock in enak Memory Bandwidth. Rezultati? Enak performans Fury X in Vega FE v igrah.

Please, explain this conundrum. Pa ne na način, kot je v srednješolskih učbenikih, kako poteka procesiranje. Veš, da kodiram* za kruh, samo nisem "specializiran" na GPU rendering področjih.

*Čedalje manj, ker sem seveda v desetletju in pol, ko sva se takrat "kregala" o raytracingu, karierno napredoval.

Islam is not about "I'm right, you're wrong," but "I'm right, you're dead!"

-Wole Soyinka, Literature Nobelist

|-|-|-|-|Proton decay is a tax on existence.|-|-|-|-|

-Wole Soyinka, Literature Nobelist

|-|-|-|-|Proton decay is a tax on existence.|-|-|-|-|

Zgodovina sprememb…

- spremenil: Jst ()

D3m0r4l1z3d ::

V teh 15 letih si sigurno tudi opazil, da pri igrah šteje le dejanski performance. Ssd vs. Hdd v marsikaterem primeru naredi super prednost, hbm na Fury ni nič posebnega. A bo mogoče hbm2 naredil dejansko razliko ali pa mogoče šele pri Navi?

Drugače povedano, a bi gddr5 držal nazaj Fiji gpu?

Drugače povedano, a bi gddr5 držal nazaj Fiji gpu?

ETN Wallet addr.: etnkGuvhDzR7Dh8us4e69VStubGbmQHrh5pe2fnpNDhEhX5

A1nCWrFBMK2NmkycgVN4sAwhvY8YyNNbF6KUSJyFZ99QKU8phCn

Cryptopia ref. link: https://www.cryptopia.co.nz/Register?referrer=Anymalus

A1nCWrFBMK2NmkycgVN4sAwhvY8YyNNbF6KUSJyFZ99QKU8phCn

Cryptopia ref. link: https://www.cryptopia.co.nz/Register?referrer=Anymalus

Zgodovina sprememb…

- spremenilo: D3m0r4l1z3d ()

Senitel ::

Please, explain this conundrum. Pa ne na način, kot je v srednješolskih učbenikih, kako poteka procesiranje. Veš, da kodiram* za kruh, samo nisem "specializiran" na GPU rendering področjih.

What conundrum? I don't see any. Vidim samo primerjavo jabolk in kislih kumaric...

AMD je dal primerjavo DeusEx side by side z HBCC On in HBCC Off. Ko je bil HBCC vključen, je igra (/benchmark) laufala smooth, brez zatikanja. Na monitorju, kjer je bil HBCC Off, so bili DIAPOZITIVI. (Takšna razlika, da slepec ne more faliti.)

Ob tem demotu je bilo eksplicitno rečeno, da gre za simulirano 2GB Vega karto. Deus Ex ja game, ki skuri več kot 4GB. Kot sem zgoraj pisal HBCC pomaga, če igra rabi več rama, kot ga je fizično na grafični kartici. Res mi ni jasno kaj pričakuješ od tega na 16GB Vega FE grafi?

Gamer Nexus so na YouTubu dali primerjavo Fury X in Vega FE, Zmanjšali Core Clock in enak Memory Bandwidth. Rezultati? Enak performans Fury X in Vega FE v igrah.

Kaj konkretno ima Vega FE, da bi morala bit clock per clock hitrejša od Fury X? FP16 mora bit eksplicitno uporabljen s strani iger in trenutno je točno 0 iger na trgu, ki bi to uporabljale. Primitive shader je, kot je to izbrskal en tip na B3D iz Mesa driverjev, združitev vertex in geometry shaderjev. Ampak geometry shaderji se v igrah uporabljajo zelo poredko, ker so v zadnjih 10 letih bili vedno počasni (eksplozija podatkov v pipeline-u, o čemer sem že tudi pisal tu gor).

Edini wildcard je Draw Stream Binning Rasterizer. Ampak tudi tu folk iz nekega neznanega razloga pričakuje, da bo zadeva praktično kopija NV pristopa. Ne vemo kako se AMD-jev zadeva obnaša v praksi. Je pa jasno, da oni test dejansko povzroči izklop enega dela prednosti, ki jih "tiling" prinese. Test šteje renderirane pixle z atomic counterjem v UAV-ju. Ko GPU izriše določeno število pixlov bo shader ubil vse nadaljne. GPU bo še vedno moral izvest shaderje tudi za pixle, ki niso vidni na koncu (ker vplivajo na atomic counter). Je pa v NV primeru še vedno možno prihranit bandwidth, ker sam vrstni red atomičnih operacij na UAV-ju ni predpisan.

RejZoR ::

Na Vega FE ne, kjer pa v končni fazi lahko pričakuješ loade krepko višje od 16GB. Samo ne za gaming ampak productivity/compute. Definitivno pa se bo poznalo že na 8GB RX Vega verziji. Sicer ne v veliko igrah ampak vseeno.

Angry Sheep Blog @ www.rejzor.com

Senitel ::

A greva kaj stavit glede tega koliko se bo to poznalo na 8GB verziji? V današnjih igrah čisto nič. Bo moral memory usage v igrah zrasti kar lepo čez 10GB, da bo kakšen efekt na 8GB Vegi.

RejZoR ::

Glede na to da s kartico ciljajo na malo dlje kot na "jutri" in da GTX 1080Ti ima 11GB je nekako za pričakovat, da bojo razvijalci iger šli tud v take "ekstreme". 8GB namreč ni nek poseben luksuz glede na to da so ga imele že R9 390X kartice kolk časa nazaj? 2 leti? Več?

Angry Sheep Blog @ www.rejzor.com

RejZoR ::

SimplyMiha je izjavil:

Zakaj bi razvijalci iger ciljali na izredno majhen trg, ki ga predstavlja 1080Ti?

Gee, zakaj razvijalci delajo ULTRA profile nastavitev v igrah? Zakaj vsi ciljajo 4K kot nek benchmark?

Kot sem že rekel. Si ziher, da ne bo 4GB Vega variante? HBCC ima še vedno failure point.

O kakšni failure točki govoriš? Če bo HBCC deloval kot so predvidel je 4GB verzija povsem mogoča.

Angry Sheep Blog @ www.rejzor.com

Senitel ::

Da bo 4GB HBCC kartica še vedno postala povsem neuporabna na neki točki. Je AMD pokazal grafe kako se igre vsak frame dotikajo približno polovice alociranega rama. Kar se da prebrat že iz tega, da če rabiš za top level tekstur 1 enoto prostora boš za vse mip mape rabil še 3/4 enot prostora. Torej približno 50:50.

RejZoR ::

Jah, če na to gledaš bo to prej ali slej doletelo VSAKO kartico. Zdej, al privarčujejo z uporabo HBC al pa namesto tega gor dajo več dražjega 8GB VRAMa. Vse je povezano s ceno. Tolk dnarja, tolk muzke. Če to drži vsepovsod, zakaj bi bile grafične kartice neka posebna izjema? Če bo neka 4GB verzija čisti nadomestek GTX 1070 ne vidim težave. Za RX Vega pa itaq že vemo, da bo 8GB + kar ponuja HBC. Kar recimo pomeni, da ima efektivno na voljo najmanj toliko spomina kot GTX 1080Ti.

Angry Sheep Blog @ www.rejzor.com

Predator X ::

Jah, če na to gledaš bo to prej ali slej doletelo VSAKO kartico. Zdej, al privarčujejo z uporabo HBC al pa namesto tega gor dajo več dražjega 8GB VRAMa. Vse je povezano s ceno. Tolk dnarja, tolk muzke. Če to drži vsepovsod, zakaj bi bile grafične kartice neka posebna izjema? Če bo neka 4GB verzija čisti nadomestek GTX 1070 ne vidim težave. Za RX Vega pa itaq že vemo, da bo 8GB + kar ponuja HBC. Kar recimo pomeni, da ima efektivno na voljo najmanj toliko spomina kot GTX 1080Ti.

Glej gornji benchmark. Poraba rama je podobna.

Zgleda, da HBC še ne deluje.

RejZoR ::

To bo pa kar hecno dopovedati strankam.

Butast folk ne kupuje takih kartic. Al kupujejo cheapo low in mid end kartice al pa top of the line, ker so glupi ampak polni dnarja. Da greš kupit en model nižje od top end kartice pomeni, da razumeš določene specifike in se zavestno odločaš za tako kartico. Glede na vse informacije naokoli se mi to zdi malo verjetno. Šur, še vedno boš našel debile, ki bojo samo gledal raw kapaciteto spomina kot vedno ampak takih imo ne bo veliko.

Predator X je izjavil:

Jah, če na to gledaš bo to prej ali slej doletelo VSAKO kartico. Zdej, al privarčujejo z uporabo HBC al pa namesto tega gor dajo več dražjega 8GB VRAMa. Vse je povezano s ceno. Tolk dnarja, tolk muzke. Če to drži vsepovsod, zakaj bi bile grafične kartice neka posebna izjema? Če bo neka 4GB verzija čisti nadomestek GTX 1070 ne vidim težave. Za RX Vega pa itaq že vemo, da bo 8GB + kar ponuja HBC. Kar recimo pomeni, da ima efektivno na voljo najmanj toliko spomina kot GTX 1080Ti.

Glej gornji benchmark. Poraba rama je podobna.

Zgleda, da HBC še ne deluje.

Vega FE ima 16GB VRAMa. Verjetno HBC ni aktiven, če driver zazna, da igra ne zahteva več. Zakaj bi dajal v L4 cache (RAM), ko pa lahko vse spraviš v L3 (VRAM)?

Angry Sheep Blog @ www.rejzor.com

Grey ::

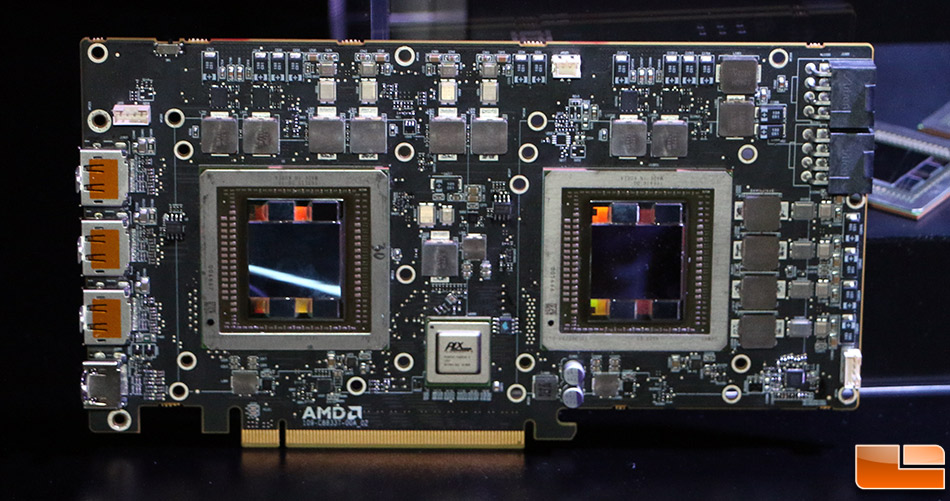

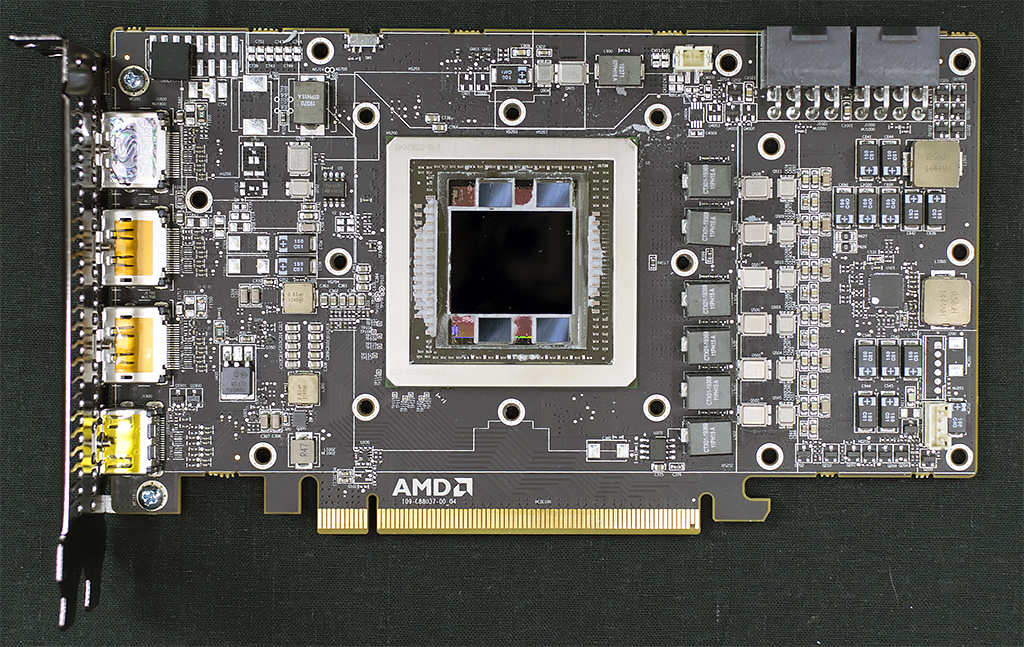

Fantje, jaz sem 100%, da je Vega multi-core.

Torej...na zadnji sliki manjkata PLX čip in še eno vidno jedro...da nista res dva majhna jedra združena v enega večjega preko Infinity Fabric (Ryan Shrout videl padec porabe ob enaki frekvenci, kar kaže, da se tam notri morebiti res skriva deljeno jedro in je Vega predhodnica Navija).

Fury X je bil 28 nm, tale stvar je 14 nm. Zaradi tega so dobili za cca 50% višjo hitrost, 50% nižjo porabo in prostor za več Stream Processorjev. Sešteješ 1+1 in prideš na to dimenzijo ter to porabo. Nizko število Stream Procesorjev je tu malo čudno glede na prehod na 14 nm...lahko, da jih bo imela RX Vega še več (so zaklenjeni na Vega FE)...prostora bi jih moralo biti za še enkrat toliko.

Ali to ali pa bodo naknadno dodali še en enak GPU potem...bolj se nagibam na prvo varianto glede na to, da je Navi naslednja arhitektura. 7 nm pomeni še manjši modul in še manjšo potrebno površino za modul enakega performansa in manj potrebne moči. Ne bo pa škodilo, če že sedaj dajo tak GPU na trg, da bodo optimizacije, driverji in ostale stvari pripravljene za Navi.

Torej...na zadnji sliki manjkata PLX čip in še eno vidno jedro...da nista res dva majhna jedra združena v enega večjega preko Infinity Fabric (Ryan Shrout videl padec porabe ob enaki frekvenci, kar kaže, da se tam notri morebiti res skriva deljeno jedro in je Vega predhodnica Navija).

Fury X je bil 28 nm, tale stvar je 14 nm. Zaradi tega so dobili za cca 50% višjo hitrost, 50% nižjo porabo in prostor za več Stream Processorjev. Sešteješ 1+1 in prideš na to dimenzijo ter to porabo. Nizko število Stream Procesorjev je tu malo čudno glede na prehod na 14 nm...lahko, da jih bo imela RX Vega še več (so zaklenjeni na Vega FE)...prostora bi jih moralo biti za še enkrat toliko.

Ali to ali pa bodo naknadno dodali še en enak GPU potem...bolj se nagibam na prvo varianto glede na to, da je Navi naslednja arhitektura. 7 nm pomeni še manjši modul in še manjšo potrebno površino za modul enakega performansa in manj potrebne moči. Ne bo pa škodilo, če že sedaj dajo tak GPU na trg, da bodo optimizacije, driverji in ostale stvari pripravljene za Navi.

Zgodovina sprememb…

- spremenilo: Grey ()

Senitel ::

Predator X je izjavil:

Glej gornji benchmark. Poraba rama je podobna.

Zgleda, da HBC še ne deluje.

Tebi tudi marsikaj ne deluje...

Torej...na zadnji sliki manjkata PLX čip in še eno vidno jedro...da nista res dva majhna jedra združena v enega večjega preko Infinity Fabric (Ryan Shrout videl padec porabe ob enaki frekvenci, kar kaže, da se tam notri morebiti res skriva deljeno jedro in je Vega predhodnica Navija).

Hmm... Stealth jedra?

Ti samo ne pozabit, da imam pri tebi prednaročenega Titan XP gaming performance-a za 550€ konec meseca.

RejZoR ::

Vega sigurno ni multi-GPU. Mogoče je v planu dvojedrna verzija ampak to kar bojo izdali sedaj definitivno ni.

Angry Sheep Blog @ www.rejzor.com

Grey ::

Vega sigurno ni multi-GPU. Mogoče je v planu dvojedrna verzija ampak to kar bojo izdali sedaj definitivno ni.

Ryzen ima module na katerih se ne vidi, da je multi-core navzven...če gledaš R5 ali pa R7. Vega ima verjetno dual core singular modul. Namreč...

Vsi indici kažejo, da stvar gre v to smer.

- slikice PCB dizajnov in njihovega napajanja

- frekvenca v Afterburnerju ostane enaka ob padcu Wattov med laufanjem igre

- in sploh največji tell: številke glede velikosti jedra so nekako nepričakovane...

Verjetno ne bodo dodajali jeder kot sem prej pričakoval, ampak bodo uporabili enako filozofijo tako kot je modificiran Ryzen.

Glede na površino Hawaii, Grenada, Fiji, Polarisa in Vege, Vega Frontier Edition najverjetneje ni polno odklenjena.

Vega ima po besedah Kodurija površino 484 mm2. Torej številke nekako ne gredo skupaj.

R9 290X/390X

2816 Stream Processors

176 TMU

64 ROP

438 mm2 (28 nm)

219 mm2 (14 nm)

275W TDP

R9 Fury Nano

4096 Stream Processors

256 TMU

64 ROP

596 mm2 (28 nm)

298 mm2 (14 nm)

175W TDP

Polaris

2304 Stream Processors

144 TMU

32 ROP

232 mm2 (14 nm)

180W TDP

Vega Frontier Edition

4096 Stream Processors

256 TMU

64 ROP

484 mm2 (14 nm)

300W TDP

Številke gredo skupaj, če ima Vega dva modulčka (zato dvojno napajanje) in bo zato polna gaming RX Vega ob izidu utegnila izgledati takole:

6144 Stream processors

384 TMU

128 ROP

484 mm2

450W

Ne bodo samo driverji proper, ampak bo tudi dejanski hardver bolj beefy.

Kar se bo potem zgodilo je epsko...

Vega 56

3584 Stream Processors

224 TMU

96 ROP

484 mm2

300W

Vega 80

5120 Stream Processors

320 TMU

96 ROP

484 mm2

400W

Vas te številke na kaj spomnejo? Tako je, Volta.

Ne razumem, kako bi drugače lahko Koduri rekel, some flavors (množina) of gaming RX Vega will be faster than Vega Frontier Edition.

DarwiN ::

400 in 450W v letu 2017? Res da govorimo o AMDju, ampak to je tudi zanje veliko preveč (4x efficiency, remember?). Te cifre so absolutno nesprejemljive in bi bili tarča posmeha po vsem svetu, ne glede na performance.

Drgač pa hitro kupi delnice, Grey, če si tako prepričan, da bo Vega velikanski uspeh. Put your money where...

Drgač pa hitro kupi delnice, Grey, če si tako prepričan, da bo Vega velikanski uspeh. Put your money where...

You don't see faith healers working in hospitals

for the same reason you don't see psychics winning the lottery!

for the same reason you don't see psychics winning the lottery!

Zgodovina sprememb…

- spremenil: DarwiN ()

dxx ::

Jaz res komaj čakam Vego, ker sem za 1070 dobil 550eur. Kot napoveduje grey (troll),bom kmalu za 700eur dobil dual gpu Vego. In primerljivo z titan x in porabo pod 500w.

RejZoR ::

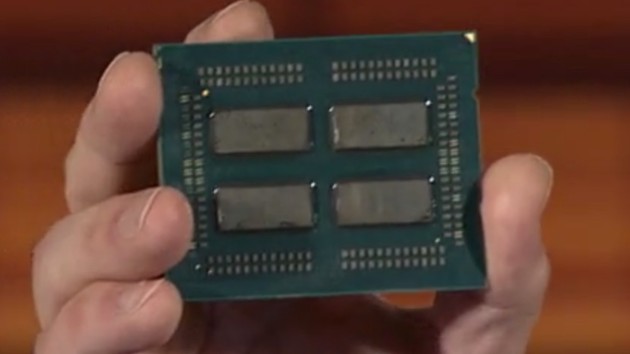

Grey, GPU-ji so že v osnovi "multi core". Vsak shader je vbistvu svoje jedro. Da pa vem, da Vega ni multi-GPU pa imaš na netu cel kup die shotov Vege. Imaš interposer in gor 3 module. 1x jedro in 2x stack HBM2 spomina. Ta večji modul je GPU. Dejanski GPU. Pri GPUjih ne uporabljajo IHS-a, kar pomeni da kar vidiš je dejanski GPU core. In Vega ima samo enega. Če pa pogledaš delide Ryzen procesorja, ki ga je naredil der8auer, pa boš videl, da sta pod IHS-om dejansko dva fizično ločena čipa(CCX modula) postavljena čist skupaj. Če pogledaš slike Threadripperja, en interposer in gor 4 ločeni čipi (CCX moduli) z mal več razdalje, med seboj povezani z Infinity Fabric. Torej, Vega je single GPU. Do zdej so vse kartice naredil v Dual GPU izvedbi, verjetno bojo tud Vego ane, ampak trenutno je še nimajo. In sigurno GPU-ja ne bosta skupaj kot pri Ryzen procih ampak bosta fizično ločena vsa na svojem interposerju povezana z Infinity Fabric. Več za Vego ne pričakujem. Pri Navi pa znajo zložit 2 ali več jeder na isti interposer.

Angry Sheep Blog @ www.rejzor.com

Grey ::

Grey, GPU-ji so že v osnovi "multi core". Vsak shader je vbistvu svoje jedro. Da pa vem, da Vega ni multi-GPU pa imaš na netu cel kup die shotov Vege. Imaš interposer in gor 3 module. 1x jedro in 2x stack HBM2 spomina. Ta večji modul je GPU. Dejanski GPU. Pri GPUjih ne uporabljajo IHS-a, kar pomeni da kar vidiš je dejanski GPU core. In Vega ima samo enega. Če pa pogledaš delide Ryzen procesorja, ki ga je naredil der8auer, pa boš videl, da sta pod IHS-om dejansko dva fizično ločena čipa(CCX modula) postavljena čist skupaj. Če pogledaš slike Threadripperja, en interposer in gor 4 ločeni čipi (CCX moduli) z mal več razdalje, med seboj povezani z Infinity Fabric. Torej, Vega je single GPU. Do zdej so vse kartice naredil v Dual GPU izvedbi, verjetno bojo tud Vego ane, ampak trenutno je še nimajo. In sigurno GPU-ja ne bosta skupaj kot pri Ryzen procih ampak bosta fizično ločena vsa na svojem interposerju povezana z Infinity Fabric. Več za Vego ne pričakujem. Pri Navi pa znajo zložit 2 ali več jeder na isti interposer.

Mislim, da sem videl fotke, kjer Ryzen R7 (eden od štirih modulov na Threadripperju) izgleda kot ena "čokoladka" brez vidnih črtic, ki bi nakazovale na to, da je sestavljena iz dveh Quad modulov. Zato in zato, ker je Navi naslednji pravim, da je možno da sta spodaj dve jedri.

Se pa ne morem strinjat glede te logike. Shaderji so samo se en del celote GPU jedra...novo delovno mesto v podjetju GPU d.o.o. na katerem je zaposleno nekaj tisoč delavcev. Multi-core grafična kartica pa je kot koncern dveh ali več podjetij, ki delajo proti skupni nalogi.

Ok, mnenje sprejeto. Več kot počakat, kaj bodo rekli po 1.8. tak al tak ne moremo.

D3m0r4l1z3d ::

Ja, boš kar imel nekaj od prej postavljene diagnoze, mogoče le poiščeš pomoč še preden Vega izide, ker bo potem premočan udarec in čakat na magic driverje bo prehuda zate.

ETN Wallet addr.: etnkGuvhDzR7Dh8us4e69VStubGbmQHrh5pe2fnpNDhEhX5

A1nCWrFBMK2NmkycgVN4sAwhvY8YyNNbF6KUSJyFZ99QKU8phCn

Cryptopia ref. link: https://www.cryptopia.co.nz/Register?referrer=Anymalus

A1nCWrFBMK2NmkycgVN4sAwhvY8YyNNbF6KUSJyFZ99QKU8phCn

Cryptopia ref. link: https://www.cryptopia.co.nz/Register?referrer=Anymalus

Zgodovina sprememb…

- spremenilo: D3m0r4l1z3d ()

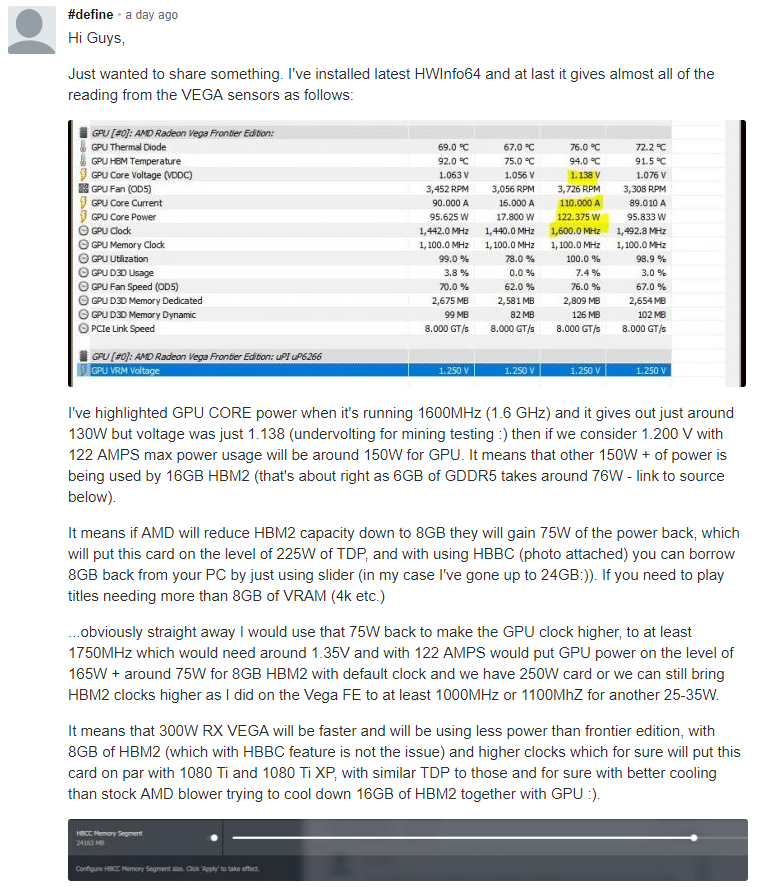

Grey ::

Grey a ti o tem govoriš?

Zanimivo, tega še nisem videl. Ta človek nima ravno točnih informacij...HBM/HBM2 pomnilnik porabi bistveno bistveno manj elektrike kot GDDR5 (cca 50% manj).

4GB HBM1 na R9 Fury rabi 14.6W...HBM2 power spec ostaja enak...se pravi 16GB HBM bi moralo trošiti nekje blizu 60W. Daleč od 150W+, ki ga predstavlja OP.

Tako, da imamo več možnosti:

- neučinkovito napajanje na Vega FE

- še eno jedro znotraj tistega poliranega die, ki ga programi ne znajo prebrat normalno, ker ni tipičen Crossfire Dual GPU (manjko vidnega fizičnega jedra, manjko PLX čipa, nespremenjena frekvenca v Afterburnerju med PCPer testom čeprav je kartica throttlala za 60W manj itd.)

- kaj tretjega, kar bi lahko povzročilo tako porabo energije

Glede na vse ostalo, kar se da izbrskat...jaz še vedno mislim, da je opcija 2.

RejZoR ::

Jeder ne moreš kar združevat in polirat. Al je fabriciran kot eno jedro(čip če hočeš) al pa sta dva. Lahko seveda združuješ manjša jedra v enega velikega, kar se je že delalo pri procesorjih, da si za quad core vzel dva dual cora in ju pri sami izdelavi waferja združil (kar pomeni, da ju ne zlepiš skupaj ampak moraš čip tko zasnovat, kar je vseeno cenejše in hitrejše kot iz nule naredit tak čip s pravimi 4 jedri). Tisto pa izgleda na zunaj kot en čip čeprav sta dejansko samo dva združena dual cora. Ampak iz shem Vega čipa to ni bilo razvidno ampak gre za en monolitni GPU.

Angry Sheep Blog @ www.rejzor.com

Grey ::

Jeder ne moreš kar združevat in polirat. Al je fabriciran kot eno jedro(čip če hočeš) al pa sta dva. Lahko seveda združuješ manjša jedra v enega velikega, kar se je že delalo pri procesorjih, da si za quad core vzel dva dual cora in ju pri sami izdelavi waferja združil (kar pomeni, da ju ne zlepiš skupaj ampak moraš čip tko zasnovat, kar je vseeno cenejše in hitrejše kot iz nule naredit tak čip s pravimi 4 jedri). Tisto pa izgleda na zunaj kot en čip čeprav sta dejansko samo dva združena dual cora. Ampak iz shem Vega čipa to ni bilo razvidno ampak gre za en monolitni GPU.

Shem? Misliš tisto GPU marketinško slikco za katero je Wasson rekel in da je in da ni prava?