Članki » Grafične kartice » nVidia GeForce4 Ti4400

nVidia GeForce4 Ti4400

Ko mi je bil ta skupek silicija, odet v težko srajco aluminija, predan v roke, sem si mislil: "Uau, kartica in pol". S svojo zastrašljivo predstavo že ob prvem pogledu vliva strahospoštovanje, saj je razvidno, da mora kartica v sebi skrivati huronsko moč. Ampak o izgledu ter arhitekturi pozneje - saj me poznate - uvode najraje namenjam samim vzrokom, da je do te kartice sploh prišlo. Pa se pojdimo vzročno-posledična razmerja. Kot sem omenil že v pred tremi tedni objavljenem testu nVidiinega Geforcea4 MX440, je šestega februarja to podjetje izdalo serijo Geforce4 kartic kot odgovor na ATIjev Radeon, ki se je kitil s 128 MB pomnilnikom. Razložil sem tudi že, zakaj se nVidia ni držala svoje grožnje, da bo nove generacije GPUjev izdajala na vsake pol leta - zaradi grožnje lastni proizvodni liniji, saj so se takrat (v začetku oktobra 2001) nVidiini Geforce3 Ti200 prodajali kot vroče žemljice. Sicer sem sam še vedno mnenja, da je za današnje potrebe Ti200 popolnoma zadosti, a se moramo vseeno sprijazniti z dejstvom - da ta kartica odhaja na smetišče računalniške zgodovine. Kot zmagovalka, a vseeno. Uporabniki imamo, gledano samo z nVidiinega aspekta, le dve izbiri - lahko damo okoli štirideset jurjev za Geforce4 MX (ki smrdi - za to ceno raje kupite Geforce2 Ti, cenejša je, pa še bolje vam bo delovala), ali pa začnemo pri strošku 60 tisočakov, kolikor bomo morali pljuniti za najšibkejšo od treh kartic družine Geforce4 Titanium. Bodi dosti besedičenja o teoriji ter zgodovini - pojdimo pogledat kartico, ki sem jo dobil v roke! Ali serija Titanium upraviči ime Geforce4? Se za strošek stotih tisočakov splača kupiti Titanium 4400? Berite dalje.

Novosti v Geforceu 4 Titanium

Seveda nVidia ne bi bila v položaju izdati novoimenovan procesor, ako se v njem ne bi kitilo precej novosti, ki nam prikradejo nasmešek na obraz. Začnimo najprej z jedrom samim. Grajeno je v 0.15 mikronski tehnologiji, enaki, s katero so bili narejeni Geforce3, Geforce2 Ti, ATI Radeon 8500 ter 7500. Gledano strogo iz vidika površine jedra opazimo, da je Geforce4 za 5 odstotkov večji od Geforcea3. Razlike med NV20 (kodno ime za GF3) ter NV25 (kodno ime za GF4)?

nFiniteFX II

NV25 ima vgrajeni dve Vertex Shading enoti, ki delujeta vzporedno. Skladno z vse večjimi potrebami programerjev po osvetljevanju ter ostalih grafični kartici zahtevnih procesih, se bo v prihodnosti želja po vzporednem računanju pokazala za zelo uporabno. Pixel Shading enota ostaja, tako kot večina ostalega renderirnega cevovoda, enaka. Tako bomo v prihodnjih generacijah grafičnih kartic (ki se, mimogrede, ne bodo več imenoval Geforce) videli močno povečano potrebo po zmogljivejših Pixel Shader enotah, da ne bi prišlo do zastojev v cevovodu. Kot sem rekel v prejšnjem odstavku, je GF4 pridobil 5% na velikosti jedra, kar sedaj postane logično, saj so pri nVidii vgradili še eno Vertex Shader enoto, ki pobere svoj davek pri površini ter posledično količini porabljene elektrike ter oddane toplote. Ti dve enoti, razširjena Vertex Shading ter enaka Pixel Shading enota, sta skriti pod tržnim imenom nFiniteFX II. O Pixel ter Vertex Shaderju smo pisali že na obširno, in sicer v mojem testu Geforcea3 ter Senitelovem članku na temo Vertex in Pixel Shaderjev. Če ste že pozabili, za kaj je nFiniteFX "kriv" v 3D Marku 2001, kar pogumno kliknite in si osvežite znanje.

LMA II

LMA II pomeni "Lightspeed Memory Architecture II", ali po naše "Svetlobno hitra pomnilniška arhitektura II". Katere tehnologije se skrivajo tu zadaj? Prva omembe vredna je deljenje širine vodila pri komunikaciji s pomnilniškim kontrolerjem ter pomnilnikom samim. Namesto da bi Geforce4 imel v sebi 128-biten pomnilniški kontroler, so se pri nVidii odločili, da raje v čip vgradijo štiri neodvisne 32-bitne kotrolerje. Tako se vsaka zahteva GPUja porazdeli po potrebi - najmanje obremenjen kontroler dobi največ podatkov - tako so pri nVidii poskrbeli za uravnoteženo obdelavo podatkov. Sicer to ni novost - taisto tehnologijo najdete vgrajeno v Geforce3. Zanimivo je pa to, da ATi, navkljub vsej svoji konkurenčnosti, v svojega R200 te tehnologije ni vgradil. Ne mislite, da ni imel znanja ali izkušenj, saj so na razvoju "prečne pomnilniške arhitekture" preždeli marsikatero urico, a so na koncu ugotovili, da je v večini primerov samo en 128-bitni pomnilniški usmerjevalnih hitrejši, zahvala gre pa predpomnilniku GPUja. Tukaj pridemo do novosti v Geforceu4: Quad Cacheju.

Quad Cache (kunšten slovenski prevod bi narekoval prevod v stilu "Kvadro predpomnilnik" :)) je točno to - skupeh štirih predpomnilnikov GPUja. Prvi ter drugi imata v sebi shranjene pogosto dostopane podatke o trikotnikih, tretji in četrti pa skrbita za pogosto dostopane podatke o teksturah ter točkah. Če se vsaj malo spoznate na procesorje, veste, da je količina predpomnilnika pri njih ključnega pomena. Ravno zato je prvi Celeron delal obupno počasi, nato bil s prihodom modela 300A izjemen nakup, medtem ko so Pentiumi II nesporno kraljevali v hitrosti matematičnih operacij. Poglejte: Če dela moj procesor pri 1466 MHz, pomnilnik pa pri 266 MHz, obstaja med frekvencama delitelj 5.5. Za predpomnilnik je pa značilno, da deluje s hitrostjo procesorja. Ker lahko procesor v svojih 384 KB (v tem primeru govorimo o Athlonih XP) predpomnilnika dostopa s kar 5.5-kratno hitrostjo centralnega pomnilnika, vam lahko kaj kmalu postane jasno, v katerem grmu tiči zajec. Pri grafičnih karticah je prisotnost predpomnilnika zaželena, a ne tako nujno potrebna, saj dela pomnilnik grafične kartice pri nesramno hitrih 550 MHz. Samo toliko, da veste :).

Pod LMA II spada tudi izboljšan algoritem za odstranjevanje poligonov, ki na končni sliki niso vidni. Pri Geforceu2 so se morali pred prikazom končne slike zrenderirati vsi objekti v vidnem spektru. Če si predstavljamo kocko, katero na pol prekriva krogla, si lahko predstavljate, da je Geforce2 moral zrenderirati oba objekta ter šele nato "vprašati" Z-Buffer, kaj naj prikaže in česa ne. No, Geforce3 je to odpravil s postopkom "Z-Occlusion Culling" (izločanje pokritih delov (sicer direkten prevod pove drugače, ampak pustimo detajle)). To je tehnologija, ki dopusti GPUju za vsak končni piksel pobrskati v Z-Buffer, da vidi, če bo prikazan na končni sliki. Po končanem procesu se renderirni enoti pošlje bistveno manj podatkov, kar se odraža v manjši zabasanosti cevovoda. Sicer pa nobena tehnologija nima slabe plati. Če je bil proces opravljen slabo (kar se odraža predvsem v mejnih primerih prekrivanja objektov), lahko pride pri sliki do anomalij. LMA II naj bi odstotek napak bistveno zmanjšal ter proces odstranjevanja nevidnih površin optimaliziral, kar se le da.

Accuview Anti-Aliasing

O postopku FSAA, ki ga je uvedel pokojni (slava Ti!) 3dfx, sem že pisal novembra 2000, tako da o samem postopku na kratko: FSAA ali Full Scene Anti-Aliasing je v svoji izvirni različici zrenderiral končno sliko na 2x velikosti (namesto 800x600 na 1600x1200) ter jo nato programsko skrčil nazaj na 800x600, kar se je odražalo v večji gladkosti robov. Ta postopek je bil uveden zaradi izjemno kakovostne slike računalniških zaslonov. Mogoče tega ne veste, ampak - zakaj izgledajo igrice, ki jih igramo na konzolah, tako lepo? Ker so televizorji prave male neumne živali ter prikazujejo sliko z namenom, da jo boste gledali iz razdalje treh ali več metrov. Pri 50 Hz interlaced, kolikor so jih zmožne prikazati povprečne televizije, so vsi robovi popačeni, kar je točno ta efekt, v katerega vlaga nVidia težke milijone dolarjev. Smešno :). No, Geforce3 je prinesel poleg 2x ter 4x FSAA še Quincunx, ki je pri hitrostnem davku dvokratnega FSAA obljubljal kakovost štirikratnega, končno sliko je pa naredil s popolnoma samosvojim matematičnim algoritmom, ki je primerjal barve pikslov v okolici ciljnega ter izvedel neko vrsto interpolacije. Geforce4 ne bi bil Geforce4, če ne bi prinesel še ene vrste celozaslonskega mehčanja robov: Accuview AA. nVidia je v svojemu jedru namenila enoti za FSAA kar trinajst odstotkov celotne površine. Postopek mehčanja je v veliki meri enak Quincunxu, le da je mnogo hitrejši. Uveden pa je še en način FSAA, imenovan 4XS AA, ki se od štirikratnega razlikuje po tem, da lahko v maličenje vzame več tekstur na piksel, kar izboljša končno kakovost slike.

nView

Pa smo se prebili do (po mojem mnenju) daleč najuporabnejše nove tehnologije, vgrajene v čip. nVidiin prvi poskus vgrajevanja podpore smo videli s prihodom tehnologije TwinView, ki jo je prva nosila kartica Geforce2 MX. Imela je vgrajeni dve RAMDAC vezji ter podpirala hkratno prikazovanje dveh različnih slik. Geforce4 ima dve 350 MHz RAMDAC vezji vgrajeni v čipu, tako da zunanja vezja za prikazovanje slike niso potrebna, razen v primeru, če hočemo priključiti LCD zaslon preko DVI izhoda, za kar mora imeti grafična kartica na tiskanem vezju TMDS (Transmission-Minimized Differential Signaling) oddajnik. Na trgu so že kartice, ki imajo vgrajena dva, kar omogoča priklop dveh LCD zaslonov hkrati.

Specifikacije

Še malo obdelovanja krutihkrutih številk:

| Primerjalna tabela | nVidia Geforce4 Ti4400 | ATI Radeon 8500 | nVidia Geforce3 Ti500 | nVidia Geforce4 MX440 |

|---|---|---|---|---|

| Jedro | NV25 | R200 | NV20 | NV17 |

| Tehnologija | 0.15μ | 0.15μ | 0.15μ | 0.15μ |

| Hitrost procesorja | 275 MHz | 275 MHz | 240 MHz | 270 MHz |

| Število cevovodov | 4 | 4 | 4 | 2 |

| Tekslov / ukaz | 2 | 2 | 2 | 2 |

| Tekslov / sekundo | 2,4 G | 2,2 G | 1,92 G | 1,1 G |

| Tip pomnilnika | 128-bitni DDR | 128-bitni DDR | 128-bitni DDR | 128-bitni DDR |

| Hitrost pomnilnika | 550 MHz | 550 MHz | 500 MHz | 400 MHz DDR |

| Prepustnost pomnilnika | 8,8 GB/s | 8,8 GB/s | 8,0 GB/s | 6,4 GB/s |

| Količina pomnilnika | 128 MB | 64 MB | 64 MB | 64 MB |

Kakor vidimo, je Ti4400 prava zverina. Pomnite, to ni najmočnejša od treh kartic - po hitrosti jo prekaša še Ti4600, ki ima 300 MHz jedro ter 650 MHz DDR pomnilnik, kar mu daje krute moči prenosa kar 10.4 gigabajtov v eni sami sekundi. Če upoštevamo še dejstvo, da je na grafični 128 MB pomnilnika ter da je jedro, z ozirom na Geforcea3, kar precej izboljšano, se spet lahko nadejamo hitrostnega prvaka, kateremu še dolgo ne bo nobena kartica kos. Prav je tako, saj Ti4400 stane zajetnih 100 tisočakov. Preden preidemo na primerjalni test, si oglejmo še kartico samo ter preletimo ponudbo, ki jo je za nas sestavil Winfast s paketom A250 TD. Po specifikacijah bi morala biti boljša od ATIjevega Radeona zaradi povečane količine pomnilnika. Je res tako?

Šatulja in kartica

Za razliko od Leadtekovega A170, ki sem ga testiral enkrat daleč nazaj, čez zasnovo kartice nimam pripomniti popolnoma nič, saj je, kolikor sem gledal slike Geforceov Ti4400 drugih proizvajalcev, izjemno kvalitetno narejena. Na nekaterih modelih Ti4400 pomnilniški moduli sploh niso hlajeni, kar ne vpliva blagodejno na stabilnost. Ostali, pametnejši, se ponavadi odločijo za pasivno hlajenje pomnilnika s tem, da na modul pritrdijo kos kovine čimvečje površine, ki nato skrbi za izmenjavo toplote z zrakom. Leadtek je izbral hvalevredno potezo - kartico je enostavno odel v sendvič-hlajenje. Na zadnji strani kartice štiri pomnilniške module pokriva tanjša plast aluminija, na sprednji pa, na debelejšem sloju kovine, ki pokriva ostale štiri pomnilniške module ter GPU, svoje trpljenje gonita kar dva 4x4 centimeterska ventilatorja, ki imata povrh vsega na sebi še protiprašni filter. Poleg dejstva, da kartica izgleda pošastno, se tudi zelo hvaležno navija - a o tem kasneje. Osredotočimo se na zunanje konektorje. Zelo je očitno, da se je nVidia zgledovala po svojemu največjemu konkurentu (ATIju - za laike :)), saj je, kot sem že omenil, v čip vgradila dve RAMDAC vezji. Ubrali so enako pot - na kartici ugledamo navaden VGA priključek, DVI izhod za priklop LCD zaslonov ter S-Video izhod za priklop televizije. Tudi upravljanje preko programske opreme je zelo podobno, saj lahko naenkrat kartica prikazuje dve različni sliki preko katerekoli kombinacije dveh priključkov. Za tiste, ki bi radi povezali na kartico dva VGA zaslona, dobimo v paketu še DVI v VGA pretvornik, za lastnike starejših televizorjev pa paketu ne manjka tudi pretvornik iz S-Videa v kompoziten izhod. Še beseda o pomnilniku: Je 550 megaherčen, kar pomeni, da bi moral Leadtek na kartico priciniti vsaj 3.6 nanosekundni pomnilnik, kar je tudi naredil. Pomnilniški moduli so po novem "zapakirani" v BGA načinu (za podrobnejše informacije odklikajte semlele), kar naj bi kartici zaradi zaradi boljših električnih in termalnih karakteristik izboljšalo stabilnost ter zagotovilo večje frekvence navitja. Še prijetno presenečenje - nVidia se je končno spomnila na Geforce4 naciniti čip za strojno zajemanje slike, ki lahko v realnem času kodira 720x576 DVD sliko v formatu MPEG-2. Sicer ima to ATi že leta, a bolje pozno kot nikoli...

Testno računalo

- AMD Athlon XP 1700+ - procesor

- 256 MB Kingmax PC2700 DDR RAM, CAS2, Turbo Settings - pomnilnik

- EPoX 8KHA+, VIA KT266A - osnovna plošča

- 2x 30 GB IBM DTLA372030 - trdi disk

- Windows XP Professional - operacijski sistem

- nVidia Detonator 28.32 - v času testiranja najnovejši komplet gonilnikov

Kako sem testiral

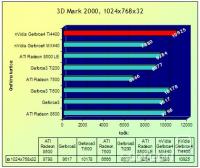

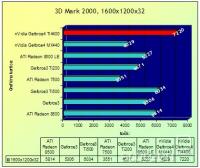

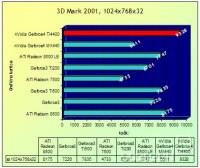

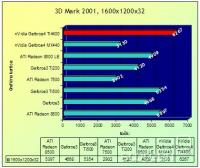

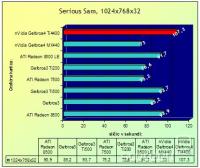

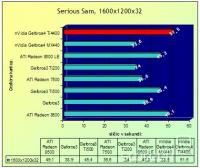

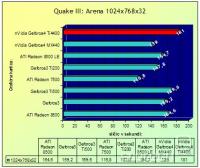

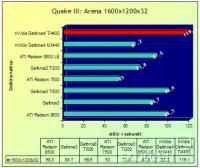

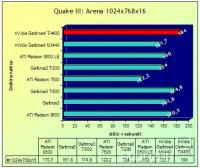

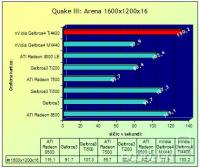

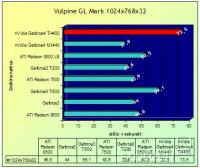

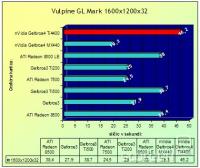

Najbrž se vsi, ki berete moje teste, najbrž praskate po zadnji plati ter sprašujete, kaj je tukaj novega povedati. In jaz vam rečem - popolnoma nič, saj skoraj eno leto testiram na popolnoma enak način. Testiram v petih programih: 3D Mark 2000, 3D Mark 2001, Quake III:Arena, Serious Sam ter Vulpine GLMark. V vseh aplikacijah sta uporabljani dve ločljivosti pri eni barvni globini in sicer 1024x768x32 ter 1600x1200x32. Zaradi nostalgije za dobrimi starimi 16-bitnimi barvami sem v Quakeu pognal teste tudi pri tej barvni globini, a le zaradi osnovne predstave. Q3:A, Serious Sam ter GLMark pokažejo pošastnost kartice v OpenGL knjižnici ukazov, medtem ko 3D Mark 2000 do konca izkoristi Microsoftov DirectX 7, 3D Mark 2001 pa pokaže, ali je kartica pripravljena na izzive prihodnosti ter zahtevne operacije, ki jih je prinesel DirectX 8.

Dolgcajt, hehe. Če ste si sedaj pozorno ogledali rezultate, vidite, da kartica za sto jurjev pač naredi tisto, kar od nje za teh sto jurjev pričakujemo - raztura. V vsakem programu prevzame pobudo ter prehiti ATi Radeona 8500, a je to tudi logično zaradi dosti bolj dodelanih gonilnikov ter dvakratne količine pomnilnika. Zanimivo bi bilo primerjati Radeona 8500 128 MB s Ti4400, saj sta to dve kartici s popolnoma enakimi specifikacijami. Sicer pa - poglejte si rezultat v 3D Marku 2001. Hiter procesor, hiter pomnilnik, vzporedno delujoča Vertex Shaderja ter sáma količina pomnilnika sta dali dodaten elan kartici, ki je v testu Nature, katerega število sličic v sekundi šteje najbolj, preprosto carovala. Okej, zadeva je pošastno hitra - kako se pa navija? Zaradi praktičnih namenov sem hotel preizkusiti, kje je njena končna meja brez vsakršnega dodatnega hlajenja (ventilatorja ob stranici ali česa podobnega). Navijal sem postopoma preko programa PowerStrip ter bil izjemno navdušen, saj so se artefakti na sliki začeli pojavljati šele nad hitrostjo 300/675, kar je 20% hitrejši procesor ter kar 23% hitrejši pomnilnik. Leadteku vsaka čast, saj je z namestitvijo nadmočnega hlajenja naredil res pravo grafično kartico za navdušence nad višanjem frekvenc. Hej, deset jurjev pik v 3D Marku 2001 ni tako slabo, ane? :)

Zaključek

Zakaj, o zakaj stane tale kup silicija zajetnih sto tisočakov? In zakaj, o zakaj sprašujem neumna vprašanja :)? Torej - če ste človek, ki preprosto mora imeti najhitrejši kos strojne opreme, brž v trgovino. Saj je res, da si lahko kupite še hitrejšega Ti4600 ter zanj pljunete 150 jurjev, ampak to bi bilo dejanje norosti. Navkljub vsem bonbončkom kartice, neomajni hitrosti ter robustnosti - pa nakupa (še) ne priporočam. Za vse vaše potrebe še vedno več kot dobro poskrbi ATi Radeon 8500, ki pa stane 76.000 SIT. Več res ne potrebujete, razen če ste pač vrženi na to, da imate daljš... uhm... več točk v 3D Marku 2001 od soseda. Brez veze, resno! Raje uživajte v visoki kvaliteti igranja ter prihranite dodatnih 25.000 SIT. Če ste se odločili počakati, pa bi prosil na potrpljenje do začetka maja, saj takrat v naše loge zaide Geforce4 Ti4200, ki naj bi imel ceno, primerljivo z Radeonom 8500. Če je res, kar berem na internetu, je kartica pravi biser, saj se pusti navijati do specifikacij Ti4600, kar bi jo avtomatsko postavilo v oddelek "Najboljši nakup". Je bilo pa lepo videti petmestno številko na izpisih rezultatov v 3D Marku 2001 - priznam. A sem se vseeno še zelo rad vrnil k mojemu dobremu staremu 3D Prophetu PRO. Slava mu...

| Winfast A250 TD | |

|---|---|

| Plusi | Minusi |

|

|

Primerjava Radeonov 9500

"Včeraj sem prodal svojo desno ledvico." "Res, zakaj?" "Jah, grafične kartice niso poceni!" [st.slika 3264] Takole nekako bi lahko potekal dialog med dvema povprečnima prebivalcema Evropske unije. Priznajmo si, in to čim hitreje: najhitrejši modeli grafičnih ...

nVidia Geforce4 MX440

Kako je sploh prišlo do tega? Tega obsednega stanja, kateremu ne zmore slediti več nihče? Poglejmo v zelo bližnjo računalniško preteklost. Ko je nVidia izdala GeForce3 serijo izdelkov, je zadela popolno terno. Novi procesor je podpiral vse napredne funkcije, ki jih je ...

GF3 Ti200, R7500 ter R8500 LE

Zgornje tri naštete kartice, katere sem popeljal na test, med sabo ne konkurirajo. Nikakor. Vsaka pač zapolnjuje nek tržni segment, katerega je treba pokriti, da je raja zadovoljna. Recimo, Radeon 7500 je mišljen kot direktna konkurenca Geforceu2 Titanium (ki naj bi tudi bil v ...

Hercules Geforce3 Ti500

Vse nekako kaže na to, da se je nVidia prvič po zelo dolgem času malo zbala za svojo izjemno dominacijo na igričarskem trgu grafičnih kartic. Odkar je pred pol leta izdala najhitrejšo grafično kartico na trgu, ki je poleg vsega tudi popolnoma podpirala DirectX 8.0 ...

Grafične kartice, november 2002

Od 12. 7. 2001, odkar sva z Goorxom s skupnimi močmi pretestirala kar osem takrat aktualnih grafičnih kartic, je minilo že dobro leto. V teh petnajstih mesecih se je spremenilo marsikaj, saj nobene od takrat testiranih grafičnih kartic ni več na voljo. Trg se je popolnoma spremenil ...