Forum » Strojna oprema » AMD Radeon R9 400 Series

AMD Radeon R9 400 Series

PredatorX ::

D3m0r4l1z3d je izjavil:

Stare finte in iskanje 1 dobrega futura, da lahko ljubo firmo na pediastal postavi, transparentno ko glass, samo, da predator vse jovo na novo razlaga in fanboyizira na amd, pač mladenič se mora še veliko naučiti

Kaj že spet razlagam?

Pascal nima takega lvl preemtiona, kot GCN.

Nima Hardwareske pdopore za async shaderje.

Nvidia bo očitno softwaresko izpeljala zadeve, kot so jih omenili (physx,post processing).

Pascal ma slabši clock per clock perf kot maxwell... jst nekih velikih sprememb nevidim na pascalu? Dej mi jih pokaži. Sam ne mi kazat bombončke in modifikacije (color compression).

Jarno ::

Pascal ma slabši clock per clock perf kot maxwell... jst nekih velikih sprememb nevidim na pascalu? Dej mi jih pokaži. Sam ne mi kazat bombončke in modifikacije (color compression).

Največji bonbonček je seveda 16nm. Ampak v paketu dobiš še odličen driver team in široko podprtost na sceni, slednje AMD-ju malce manjka.

Kvaliteta izrisane slike ni pod vprašajem, zato šteje hitrost in to nVidia ima, za AMD (polaris) še ne vemo, kje bo pristal.

AapocalypseE ::

AMD bi moral s Polarisom naredit boom in pomest s Pascalom, ampak oni se raje šlepajo in je treba čakat na Vego, ki bi naj bila naslednjica Fury X.

Kaj takega bi si lahko Nvidia privoščla, ki ima dosti večji delež in bi lahko glih oni šli bolj na izi, ampak AMD pa bi se moral dosti bolj potrudit tukaj za nas kupce.

Kaj takega bi si lahko Nvidia privoščla, ki ima dosti večji delež in bi lahko glih oni šli bolj na izi, ampak AMD pa bi se moral dosti bolj potrudit tukaj za nas kupce.

GenZNPC ::

jst nekih velikih sprememb nevidim na pascalu?

Tipicen AMD, k neve kaj se prodaja. Ne async pa ne aots.... ne bo spremenilo nic.

cas je dnar.

skibidi

Zgodovina sprememb…

- spremenil: GenZNPC ()

NightHawk ::

Mnja, zelo zanimive debate...

Kdaj pridejo AMD kartice, ki naj bi konkurirale GTX 1080? Se že kaj ve?

Kdaj pridejo AMD kartice, ki naj bi konkurirale GTX 1080? Se že kaj ve?

AapocalypseE ::

In Nvidia že ima pripravljen odgovor na to in sicer GP100.

Pri amdju se mora nekaj konkretno spremenit, ker večno ne bo šlo tako.

Pri amdju se mora nekaj konkretno spremenit, ker večno ne bo šlo tako.

D3m ::

Pascal ma slabši clock per clock perf kot maxwell... jst nekih velikih sprememb nevidim na pascalu? Dej mi jih pokaži. Sam ne mi kazat bombončke in modifikacije (color compression).

Največji bonbonček je seveda 16nm. Ampak v paketu dobiš še odličen driver team in široko podprtost na sceni, slednje AMD-ju malce manjka.

Kvaliteta izrisane slike ni pod vprašajem, zato šteje hitrost in to nVidia ima, za AMD (polaris) še ne vemo, kje bo pristal.

Saj se lahko vzdržimo takih komentarjev?

|HP EliteBook|R7 8840U|

Jarno ::

Pascal ma slabši clock per clock perf kot maxwell... jst nekih velikih sprememb nevidim na pascalu? Dej mi jih pokaži. Sam ne mi kazat bombončke in modifikacije (color compression).

Največji bonbonček je seveda 16nm. Ampak v paketu dobiš še odličen driver team in široko podprtost na sceni, slednje AMD-ju malce manjka.

Kvaliteta izrisane slike ni pod vprašajem, zato šteje hitrost in to nVidia ima, za AMD (polaris) še ne vemo, kje bo pristal.

Saj se lahko vzdržimo takih komentarjev?

Odlični driver team od nVidie je resničnost. So kot hobotnica, ki razpreda svoje lovke po gaming industriji in po mojih predvidevanjih znajo prisluhniti in komunicirati z devsi še v času razvoja.

Tudi pri AMD-ju testne mašine laufajo na intel cpu-jih, nek "neodvisni" gaming team pa ne bi smel optimizirat za nVidio?

AMD po drugi strani ni slab, ampak včasih probleme rešujejo z zamudo, kar nekateri zamerijo.

Zelo dober primer je AMD Radeon HD Diablo 3 Desolate sands bug (dokaj kritično vpliva na gameplay), ki ga pri Blizzardu niso hoteli popraviti celo večnost, dokler ni naposled AMD popravil skozi beta driverje.

Zato se ni potrebno vzdržati tovrstnih komentarjev. Give credit where credit is due.

iloveboobz ::

glavno, da je raw power, ki ga mogoče izkoristiš čez 5 leti. Software pa ni važn...

Večni argument amd navijačic

Večni argument amd navijačic

smoki

tikitoki ::

AapocalypseE je izjavil:

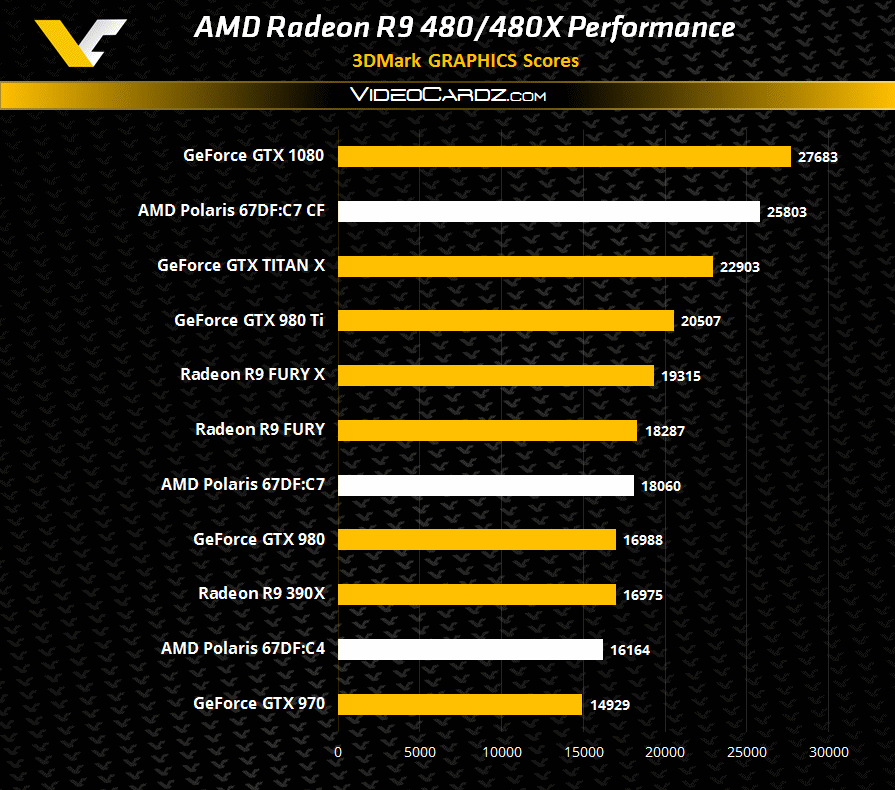

In, če na grobo zračunam procente iz tega, je 1080 za 45% hitrejša od 980Ti v tem benchmarku.

Kje je šele OC potencial 1080.

ne obstaja. vsaj ne pr founders moneygrabu

Alien123 ::

Zanimivo kak pravijo nvidiasi kak amd neve kaj se prodaja, a nima vecje plače kot minimalec

iloveboobz ::

Včasih je bolje prodat manjši volumen z večjo maržo kot večji z nižjo :)

Ni vse količina, na koncu dneva šteje samo net profit.

Ni vse količina, na koncu dneva šteje samo net profit.

smoki

klinker ::

AapocalypseE ::

AapocalypseE je izjavil:

In, če na grobo zračunam procente iz tega, je 1080 za 45% hitrejša od 980Ti v tem benchmarku.

Kje je šele OC potencial 1080.

ne obstaja. vsaj ne pr founders moneygrabu

Kdo pa govori o reference kartici?

Zanimivo kak pravijo nvidiasi kak amd neve kaj se prodaja, a nima vecje plače kot minimalec

Ne spuščaj se spet na osebni nivo, če nimaš drugega argumenta za napisat.

Drugače pa številke povejo svoje, koliko deleža ima Nvidia in koliko amd, tako da se lepo vidi kdo zna bolje in kdo slabše poslovat.

Senitel ::

Kaj naj bi AotS pomenil ?

Minority report (za razumevanje finte poglej istoimenski film).

Igra je dokaz, da ma GCN en dober performance feature, nič drugega.

Smešno mi pa je, da ji raje ne daš iskrenega komplimenta. Shareholder?

Če imaš čip z 2048 SP-ji, in jih v grafičnem loadu večino časa dela samo 1536 je to dober feature?

Jarno ::

Če imaš čip z 2048 SP-ji, in jih v grafičnem loadu večino časa dela samo 1536 je to dober feature?Shit one reads around here.

Valda je to predmet optimizacij, saj sam veš, da niso vsi SP-ji enaki in eni računajo "specialne" funkcije, ki so včasih na kupu, včasih pa jih sploh ni.

Od oke 4 na 1, torej vse štima. Če pa razlagaš, da ma nVidia tiste specialne SP-je hibridne narave, potem jim dam kompliment.

Senitel ::

Valda je to predmet optimizacij, saj sam veš, da niso vsi SP-ji enaki in eni računajo "specialne" funkcije, ki so včasih na kupu, včasih pa jih sploh ni.

Od oke 4 na 1, torej vse štima. Če pa razlagaš, da ma nVidia tiste specialne SP-je hibridne narave, potem jim dam kompliment.

A da kaj vem? Glej, ne rabim nobenega priznanja tule gor, da kaj vem. Lahko imamo argumentirano debato, ali pa takle vrtec...

Kaj za vraga imajo "specialne" funkcije s poganjanjem grafike in compute sočasno? Če ti ni jasno kaj CU-ji (AMD) in SM-i (NV) sploh počnejo to nima povezave z "async compute".

Jarno ::

Če imaš čip z 2048 SP-ji, in jih v grafičnem loadu večino časa dela samo 1536 je to dober feature?Shit one reads around here.

OK, poskusimo znova.

Torej "special function" SP-je, ki bi lahko idlali večino časa ne štejemo zraven. Check.

Gre za GCN arhitekturo. Check.

AMD zato ponuja rešitve z recimo 4096 SP-ji, ker vedo, da jih bo večino časa delalo 3072. Check.

Problem je na nivoju CU-jev. Check.

AMD async compute je hoax in marketinška zadeva. Check.

Nekako razumem, kaj bi rad povedal. Brez skrbi, gre za eno igro, zahtevne optimizacije in za folk, ki ne bo masovno kupoval grelnikov.

Kaj bi pa drugače rad slišal?

Senitel ::

Običajno se oglasim, ko kdo zine kakšno neumnost (čeprav jih veliko spustim, ker well rocks).

Zanima me, zakaj se tebi zdi to tak fajn performance feature? Nebi raje imel vedno spodobno zasedenost shader arraya in "reklamiran" 20% večji fps brez, da morajo developerji tweekat zadeve? In async compute ob tem dejansko postane async compute, torej orodje, da lahko GPU med normalnim delom asinhrono poskrbi še za kaj drugega (VR).

In to ni noben hoax, je dejansko stanje, ki se ga po forumih hypa v stratosfero. AotS precej profitira, če je ta path v igri vklopljen. Glede na to kaj je NV ob splavitvi Pascala povedala na to temo (*), lahko začnemo NV morit, da v driverjih zafiksirajo 20% SM-ov za compute, ker je to tako dobra ideja! Hej sicer bo iz GTX 980 nenadoma postal GTX 970, ampak bo pa boost v Ashes of the Singularity (še vedno bo pa fps v igri manjši kot sedaj)!

(*) - Maxwell lahko sočasno poganja grafiko in compute, ampak mora statično alocirat SM-e za grafiko in za compute in se ta alokacija ne more spremenit dokler oba taska ne končata. Ni pa ta feature nikoli bil vklopljen v public driverjih.

Zanima me, zakaj se tebi zdi to tak fajn performance feature? Nebi raje imel vedno spodobno zasedenost shader arraya in "reklamiran" 20% večji fps brez, da morajo developerji tweekat zadeve? In async compute ob tem dejansko postane async compute, torej orodje, da lahko GPU med normalnim delom asinhrono poskrbi še za kaj drugega (VR).

In to ni noben hoax, je dejansko stanje, ki se ga po forumih hypa v stratosfero. AotS precej profitira, če je ta path v igri vklopljen. Glede na to kaj je NV ob splavitvi Pascala povedala na to temo (*), lahko začnemo NV morit, da v driverjih zafiksirajo 20% SM-ov za compute, ker je to tako dobra ideja! Hej sicer bo iz GTX 980 nenadoma postal GTX 970, ampak bo pa boost v Ashes of the Singularity (še vedno bo pa fps v igri manjši kot sedaj)!

(*) - Maxwell lahko sočasno poganja grafiko in compute, ampak mora statično alocirat SM-e za grafiko in za compute in se ta alokacija ne more spremenit dokler oba taska ne končata. Ni pa ta feature nikoli bil vklopljen v public driverjih.

PredatorX ::

LoL,

okey zdej pravte, da fury X uporablja samo 3072 shaderjev. Dobr okey shader utilization je slabši pri AMDju kot pri NVIDIJI.

Sam async shaderji pomagaji pri uporabi shaderjev, rasterizerjev in DMA. R9 Fury X čip je približn ena velikosti kot TITAN X? Zakaj potem vsebuje 1K več shaderjev?

okey zdej pravte, da fury X uporablja samo 3072 shaderjev. Dobr okey shader utilization je slabši pri AMDju kot pri NVIDIJI.

Sam async shaderji pomagaji pri uporabi shaderjev, rasterizerjev in DMA. R9 Fury X čip je približn ena velikosti kot TITAN X? Zakaj potem vsebuje 1K več shaderjev?

iloveboobz ::

R9 Fury X čip je približn ena velikosti kot TITAN X? Zakaj potem vsebuje 1K več shaderjev?

mislim, da je odgovor na to očiten.

smoki

PredatorX ::

iloveboobz je izjavil:

R9 Fury X čip je približn ena velikosti kot TITAN X? Zakaj potem vsebuje 1K več shaderjev?

mislim, da je odgovor na to očiten.

In kaj je potem narobe, da z uporabo async shaderjev bolj utiliziraš celoten čip? Zdej so pa async shaderji neki slabga in so brezvezni... ker koštajo? Počak, zdej pejt pa do intela pa mu sporoči, da je hyperthreading brez veze, ker te košta plac na čipu....

Fury X shaderji delajo na 100%, čeprav pride potem ven recimo 50 fpsjev zaradi slabše utilzacije. Ampak, z async shaderji dobiš boljšo utilizacijo čipa.

Sony je govoril o tem 2009/2010 in njim se nezdi slččaba zadeva. Dice oziroma večina developerjem se ne zdi slaba ideja... a tukaj enmu slo pro programerju in fanboyu se pa zdi zelo slaba ideja in se ostali motijo.

Zgodovina sprememb…

- spremenilo: PredatorX ()

iloveboobz ::

In kaj je potem narobe, da z uporabo async shaderjev bolj utiliziraš celoten čip?

nič

Počak, zdej pejt pa do intela pa mu sporoči, da je hyperthreading brez veze, ker te košta plac na čipu....

Slaba primerjava. Za HT nerabiš zadeve eksplicitno spisat, da ga uporablja.

Fury X shaderji delajo na 100%, čeprav pride potem ven recimo 50 fpsjev zaradi slabše utilzacije. Ampak, z async shaderji dobiš boljšo utilizacijo čipa.

That.. Makes no sense.

Sony je govoril o tem 2009/2010 in njim se nezdi slččaba zadeva. Dice oziroma večina developerjem se ne zdi slaba ideja

Kaj ma veze, kaj si en developer misli o zadevi. Važno je samo to, kako se bo stvar v praksi uporabljala across the board, ne samo pri enem studiu in eni igri.

smoki

PredatorX ::

Kaj teb še ni jasn?

Zakaj ma en motor boljši izkoristek kot drugi motor?...

Quantum break lepo pokaže...

Zakaj ma en motor boljši izkoristek kot drugi motor?...

Quantum break lepo pokaže...

Zgodovina sprememb…

- spremenilo: PredatorX ()

Senitel ::

-Use with great care!

-Always check this is a performance win

-If a technique suitable for pairing is due to poor utilization of the GPU, first ask "why does utilization suck?"

-Always check this is a performance win

-If a technique suitable for pairing is due to poor utilization of the GPU, first ask "why does utilization suck?"

PredatorX ::

Ja, AMD se je z 7970 in fury X posvetil na compute perf. 7870 in R9 390X imata pa boljši izkoristek.

Zgodovina sprememb…

- spremenilo: PredatorX ()

Senitel ::

Super! In kje na teh slidih vidiš omenjene 7970 ali FuryX ali 7870 ali R9 390X, da ima tvoj post kakršno koli povezavo s tem kar sem jaz izpostavil?

Videl si 10% in takoj pripel zraven še "currently"... Ker pričakuješ, da bo 50% performance gain. Tko kot Hitman in "heavy use" (what ever the fuck that is) ane...

Vrtec.

Videl si 10% in takoj pripel zraven še "currently"... Ker pričakuješ, da bo 50% performance gain. Tko kot Hitman in "heavy use" (what ever the fuck that is) ane...

Vrtec.

PredatorX ::

Super! In kje na teh slidih vidiš omenjene 7970 ali FuryX ali 7870 ali R9 390X, da ima tvoj post kakršno koli povezavo s tem kar sem jaz izpostavil?

Videl si 10% in takoj pripel zraven še "currently"... Ker pričakuješ, da bo 50% performance gain. Tko kot Hitman in "heavy use" (what ever the fuck that is) ane...

Vrtec.

Dej, glede nato da si nek pro programer je tvoje obnašanje za vrtec.

GenZNPC ::

Tehnikalije gor al dol, async je slab za industrijo tako kartic, kot iger, ker ne prinasa linearnega boosta v vseg igrah/na_karticah in je stroskovno visje od trenutno izpiljenega nacina dela.

Je pa dobro za konzole, tam je skos isti hardware v vseh ps4-kah. PC je pa druga zgodba, ko mas paleto 50+ razlicnih gpujev, cpujev, arhov na strani userjev.

Je pa dobro za konzole, tam je skos isti hardware v vseh ps4-kah. PC je pa druga zgodba, ko mas paleto 50+ razlicnih gpujev, cpujev, arhov na strani userjev.

skibidi

PredatorX ::

Tehnikalije gor al dol, async je slab za industrijo tako kartic, kot iger, ker ne prinasa linearnega boosta v vseg igrah/na_karticah in je stroskovno visje od trenutno izpiljenega nacina dela.

Je pa dobro za konzole, tam je skos isti hardware v vseh ps4-kah. PC je pa druga zgodba, ko mas paleto 50+ razlicnih gpujev, cpujev, arhov na strani userjev.

Ni fora to. Ampak Senitelovo prepričanje v njegov "prov"... krk sm rekel pameten je za 7 milijard ljudi. AMD nima pojma, developerji pa tudi ne... kakšen veleum imamo v SLO.

dolenc ::

Zdej to ne vemo, definitivno pa maš ti take cvetke tle gor, da ne veš al bi jokal al se smejal.

Drugače pa še par dni da ta jajca predstavijo, pa da vidmo če se bo kej kupovalo. Moja boga hd4400 že potrebuje dopust, upam da bodo s polarisom saj 980 po hitrosti ujeli.

Drugače pa še par dni da ta jajca predstavijo, pa da vidmo če se bo kej kupovalo. Moja boga hd4400 že potrebuje dopust, upam da bodo s polarisom saj 980 po hitrosti ujeli.

PredatorX ::

Zdej to ne vemo, definitivno pa maš ti take cvetke tle gor, da ne veš al bi jokal al se smejal.

Drugače pa še par dni da ta jajca predstavijo, pa da vidmo če se bo kej kupovalo. Moja boga hd4400 že potrebuje dopust, upam da bodo s polarisom saj 980 po hitrosti ujeli.

3-4 mesece nazaj sem govoril, da fury x ne izkorišča vseh shaderjev.. pa se je smejal, "zakaj potem kaže load na 100%". Zdej pa on govori, da uporablja samo 3K shaderjev?... ma dej se pa že odločte. Lansko leto sem mu prevedel kitguru in njihovo mnenje kako šader potuje... a se je jebenoi smejal, dokler nisem dal linka.

Zdej pa hoče povedat, da so async shaderji samo "peace of shit" in so nepotrebni... ker AMD nezna naredit archa.

Zgodovina sprememb…

- spremenilo: PredatorX ()

Jarno ::

Tehnikalije gor al dol, async je slab za industrijo tako kartic, kot iger, ker ne prinasa linearnega boosta v vseg igrah/na_karticah in je stroskovno visje od trenutno izpiljenega nacina dela.

Je pa dobro za konzole, tam je skos isti hardware v vseh ps4-kah. PC je pa druga zgodba, ko mas paleto 50+ razlicnih gpujev, cpujev, arhov na strani userjev.

Besede modrosti. Bo že res, da se prodajajo preizkušene in uporabne rešitve.

Zato sam navijam za AMD midrange 48ROP zadevo s 6GB (384bit) pri 250€ in tam 150W porabe in ne 32ROP kot recimo 380X. Recimo 1.5 * 380X.

To je performance boost, ki bi ga v midrange pozdravili. Poceni "32ROP" ni dovolj, "64ROP" pa ne bo poceni. Get my point?

Edini problem je, da bi s takšnim setupom dejansko bili konkurenčni, če že ne dominantni v midrange performance sektorju.

iloveboobz ::

Kaj teb še ni jasn?

Zakaj ma en motor boljši izkoristek kot drugi motor?...

Quantum break lepo pokaže...

v enem stavku govoriš o 100% izkoriščenosti, v drugem pa kako stvar nima dobrega izkoristka.. Kaj bo sedaj ?

smoki

Senitel ::

3-4 mesece nazaj sem govoril, da fury x ne izkorišča vseh shaderjev.. pa se je smejal, "zakaj potem kaže load na 100%". Zdej pa on govori, da uporablja samo 3K shaderjev?... ma dej se pa že odločte. Lansko leto sem mu prevedel kitguru in njihovo mnenje kako šader potuje... a se je jebenoi smejal, dokler nisem dal linka.

Zdej pa hoče povedat, da so async shaderji samo "peace of shit" in so nepotrebni... ker AMD nezna naredit archa.

Pa si spet zmišljuješ neki v tri krasne. Kje sem jaz napisal, kar koli kar mi očitaš tule? A imaš težave z razdvojeno osebnostjo, saj si se sam hvalil, da imaš več accountov tule gor in misliš, da se tudi jaz sam s sabo pogovarjam?

Nič niso "piece of shit"! Asinhron del je zelo uporaben, ampak samo asinhron del ti ne da nobenega boosta. Boost pride samo iz tega, če je hardware v določenih pogojih neučinkovit in ne zmore zafilat shader array-a. Kaj pa če Polaris recimo poštima določene stvari v grafičnem delu in bo priobitev "async compute" v AotS kar na enkrat med 0 in 2%?

buttplugs ::

PredatorX ::

iloveboobz ::

Za trenutek sn mislu, da je polaris za petami 1080..... CF

čeprav honestly kr vzamem tisti fury like polaris za ~300€

čeprav honestly kr vzamem tisti fury like polaris za ~300€

smoki

Zgodovina sprememb…

- spremenil: iloveboobz ()

klinker ::

Pa niti ne bo slabo, ce bo res tako. 480X boljsa od 980ke.

Za ceno 300€ super nakup.

Kolko pa to kaj zre?

Za ceno 300€ super nakup.

Kolko pa to kaj zre?